|

ąÆ ą┐čĆąĄą┤čŗą┤čāčēąĄą╣ čćą░čüčéąĖ [2] ą▒čŗą╗ąŠ ą┐ąŠą║ą░ąĘą░ąĮąŠ, ą║ą░ą║ ąĘą░ą┐čāčüčéąĖčéčī ąĘą░ą┤ą░čćčā (task) ąĮą░ ą┐ąŠč鹊ą║ąĄ (thread), ą║ą░ą║ ą║ąŠąĮčäąĖą│čāčĆąĖčĆąŠą▓ą░čéčī ą┐ąŠč鹊ą║ ąĖ ą║ą░ą║ ą┐ąĄčĆąĄą┤ą░čéčī ą┤ą░ąĮąĮčŗąĄ ą▓ ąŠą▒ąŠąĖčģ ąĮą░ą┐čĆą░ą▓ą╗ąĄąĮąĖčÅčģ (ą▓ ą┐ąŠč鹊ą║ ąĖ ąĖąĘ ą┐ąŠč鹊ą║ą░). ąóą░ą║ąČąĄ ąŠą┐ąĖčüčŗą▓ą░ą╗ąŠčüčī, ą║ą░ą║ąĖą╝ ąŠą▒čĆą░ąĘąŠą╝ ą╗ąŠą║ą░ą╗čīąĮčŗąĄ ą┐ąĄčĆąĄą╝ąĄąĮąĮčŗąĄ ą┤ąĄą╗ą░čÄčéčüčÅ ą┐čĆąĖą▓ą░čéąĮčŗą╝ąĖ ą┤ą╗čÅ ą┐ąŠč鹊ą║ą░, ąĖ ą║ą░ą║ čüčüčŗą╗ą║ąĖ ą╝ąŠą│čāčé ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčīčüčÅ ą╝ąĄąČą┤čā ą┐ąŠč鹊ą║ą░ą╝ąĖ čüąŠą▓ą╝ąĄčüčéąĮąŠ, čćč鹊ą▒čŗ ą╝ąŠąČąĮąŠ ą▒čŗą╗ąŠ ąŠą▒ą╝ąĄąĮąĖą▓ą░čéčīčüčÅ ą┤ą░ąĮąĮčŗą╝ąĖ ą╝ąĄąČą┤čā ą┐ąŠč鹊ą║ą░ą╝ąĖ č湥čĆąĄąĘ ąŠą▒čēąĖąĄ ą┐ąŠą╗čÅ ą║ą╗ą░čüčüą░.

ąĪą╗ąĄą┤čāčÄčēąĖą╣ ą▓ą░ąČąĮčŗą╣ čłą░ą│ čŹč鹊 čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖčÅ: ą║ąŠąŠčĆą┤ąĖąĮą░čåąĖčÅ ą┤ąĄą╣čüčéą▓ąĖą╣ ą┐ąŠč鹊ą║ąŠą▓, čćč鹊ą▒čŗ ąŠąĮąĖ čĆą░ą▒ąŠčéą░ą╗ąĖ ą┐čĆąĄą┤čüą║ą░ąĘčāąĄą╝čŗą╝ ąŠą▒čĆą░ąĘąŠą╝. ąĪąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖčÅ ą▓ čćą░čüčéąĮąŠčüčéąĖ ą▓ą░ąČąĮą░, ą║ąŠą│ą┤ą░ ą┐ąŠč鹊ą║ąĖ ąŠą▒čĆą░čēą░čÄčéčüčÅ ą║ ąŠą┤ąĮąĖą╝ ąĖ č鹥ą╝ ąČąĄ ą┤ą░ąĮąĮčŗą╝; čāą┤ąĖą▓ąĖč鹥ą╗čīąĮąŠ ą┐čĆąŠčüč鹊 čĆą░ą▒ąŠčéą░čéčī čü čéą░ą║ąĖą╝ąĖ ą┤ą░ąĮąĮčŗą╝ąĖ.

ąÜąŠąĮčüčéčĆčāą║čåąĖąĖ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ ą╝ąŠąČąĮąŠ ą┐ąŠą┤ąĄą╗ąĖčéčī ąĮą░ 4 ą║ą░č鹥ą│ąŠčĆąĖąĖ:

ą¤čĆąŠčüčéčŗąĄ ą╝ąĄč鹊ą┤čŗ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąĪčāčéčī čŹčéąĖčģ ą╝ąĄč鹊ą┤ąŠą▓ ą▓ ąŠąČąĖą┤ą░ąĮąĖąĖ, ą║ąŠą│ą┤ą░ ą┤čĆčāą│ąŠą╣ ą┐ąŠč鹊ą║ ąĘą░ą▓ąĄčĆčłąĖčéčüčÅ. ą×ąČąĖą┤ą░ąĮąĖąĄ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĘą░ą┤ą░ąĮąŠ ąĮą░ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮčŗą╣ ą┐ąĄčĆąĖąŠą┤ ą▓čĆąĄą╝ąĄąĮąĖ. ąÜ ą╝ąĄč鹊ą┤ą░ą╝ ą┐čĆąŠčüč鹊ą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąŠčéąĮąŠčüčÅčéčüčÅ Sleep, Join ąĖ Task.Wait.

ąÜąŠąĮčüčéčĆčāą║čåąĖąĖ ą║čĆąĖčéąĖč湥čüą║ąĖčģ čüąĄą║čåąĖą╣ (locking constructs). ąŁč鹊 ą▓ą▓ąŠą┤ąĖčé ąŠą│čĆą░ąĮąĖč湥ąĮąĖąĄ, čćč鹊 ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮą░čÅ čüąĄą║čåąĖčÅ ą║ąŠą┤ą░ ą╝ąŠąČąĄčé ąĖčüą┐ąŠą╗ąĮčÅčéčīčüčÅ ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ č鹊ą╗čīą║ąŠ ąŠą│čĆą░ąĮąĖč湥ąĮąĮčŗą╝ ą║ąŠą╗ąĖč湥čüčéą▓ąŠą╝ ą┐ąŠč鹊ą║ąŠą▓. ąśčüą║ą╗čÄčćąĖč鹥ą╗čīąĮą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ (exclusive locking) ą▓čüčéčĆąĄčćą░ąĄčéčüčÅ čćą░čēąĄ ą▓čüąĄą│ąŠ - ąŠąĮą░ ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ č鹊ą╗čīą║ąŠ ąŠą┤ąĮąŠą╝čā ą┐ąŠč鹊ą║čā ąŠčüčāčēąĄčüčéą▓ą╗čÅčéčī ą┤ąŠčüčéčāą┐ ą║ ąŠą▒čēąĖą╝ ą┤ą░ąĮąĮčŗą╝, ą┐čĆąĖ čŹč鹊ą╝ ą┤čĆčāą│ąĖąĄ ą┐ąŠč鹊ą║ąĖ ąĮąĄ ą╝ąŠą│čāčé ą┐ąŠą╝ąĄčłą░čéčī ą┤ąŠčüčéčāą┐čā. ąĪčéą░ąĮą┤ą░čĆčéąĮčŗąĄ ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ ąĖčüą║ą╗čÄčćąĖč鹥ą╗čīąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ čŹč鹊 lock (Monitor.Enter/Monitor.Exit, čüą╝. ą┤ą░ą╗ąĄąĄ "Locking"), Mutex (čüą╝. ą┤ą░ą╗ąĄąĄ) ąĖ SpinLock (čüą╝. [3]). ąÜąŠąĮčüčéčĆčāą║čåąĖąĖ ąĮąĄ ąĖčüą║ą╗čÄčćąĖč鹥ą╗čīąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ (nonexclusive locking) čŹč鹊 Semaphore, SemaphoreSlim (čüą╝. ą┤ą░ą╗ąĄąĄ) ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ reader/writer (čüą╝. [4]).

ąÜąŠąĮčüčéčĆčāą║čåąĖąĖ čüąĖą│ąĮą░ą╗ąĖąĘą░čåąĖąĖ (signaling). ą×ąĮąĖ ą┐ąŠąĘą▓ąŠą╗čÅčÄčé ą┐ąŠč鹊ą║čā ą┐čĆąĖąŠčüčéą░ąĮąŠą▓ąĖčéčīčüčÅ, ą┐ąŠą║ą░ ąĮąĄ ą┐čĆąĖą┤ąĄčé ąŠą┐ąŠą▓ąĄčēąĄąĮąĖąĄ ąŠčé ą┤čĆčāą│ąŠą│ąŠ ą┐ąŠč鹊ą║ą░, čćč鹊 čāčüčéčĆą░ąĮčÅąĄčé ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéčī ąĮąĄ čŹčäč乥ą║čéąĖą▓ąĮąŠą│ąŠ ąŠą┐čĆąŠčüą░ (ą║ą░ą║ąĖčģ-č鹊 ąŠą▒čēąĖčģ čäą╗ą░ą│ąŠą▓ ąĖą╗ąĖ ą┐ąĄčĆąĄą╝ąĄąĮąĮčŗčģ). ąĢčüčéčī ą┤ą▓ą░ ąĖčüą┐ąŠą╗čīąĘčāąĄą╝čŗčģ ąŠą▒čŗčćąĮąŠ čāčüčéčĆąŠą╣čüčéą▓ą░ čüąĖą│ąĮą░ą╗ąĖąĘą░čåąĖąĖ (signaling devices): ąŠą▒čĆą░ą▒ąŠčéčćąĖą║ąĖ ąŠąČąĖą┤ą░ąĮąĖčÅ čüąŠą▒čŗčéąĖčÅ (event wait handles, čüą╝. ą┤ą░ą╗ąĄąĄ) ąĖ ą╝ąĄč鹊ą┤čŗ and Wait/Pulse ą║ą╗ą░čüčüą░ Monitor [5]. Framework 4.0 ą┐čĆąĄą┤čüčéą░ą▓ą╗čÅąĄčé ą║ą╗ą░čüčüčŗ CountdownEvent (čüą╝. ą┤ą░ą╗ąĄąĄ) ąĖ Barrier [6].

ąØąĄ ą▒ą╗ąŠą║ąĖčĆčāčÄčēąĖąĄ ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ. ą×ąĮąĖ ąĘą░čēąĖčēą░čÄčé ą┤ąŠčüčéčāą┐ ą║ ąŠą▒čēąĄą╝čā ą┐ąŠą╗čÄ ą┐čāč鹥ą╝ ą▓čŗąĘąŠą▓ą░ ą┐čĆąĖą╝ąĖčéąĖą▓ąŠą▓ ą┐čĆąŠčåąĄčüčüąŠčĆą░. ąæąĖą▒ą╗ąĖąŠč鹥ą║ą░ CLR ąĖ čÅąĘčŗą║ C# ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅčÄčé čüą╗ąĄą┤čāčÄčēąĖąĄ ąĮąĄ ą▒ą╗ąŠą║ąĖčĆčāčÄčēąĖąĄ ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ: Thread.MemoryBarrier, Thread.VolatileRead, Thread.VolatileWrite [7], ą║ą╗čÄč湥ą▓ąŠąĄ čüą╗ąŠą▓ąŠ volatile [8] ąĖ ą║ą╗ą░čüčü Interlocked [9].

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą▓ą░ąČąĮą░ ą┤ą╗čÅ ą▓čüąĄčģ ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĮčŗčģ ą║ą░č鹥ą│ąŠčĆąĖą╣, ą║čĆąŠą╝ąĄ ą┐ąŠčüą╗ąĄą┤ąĮąĄą╣. ąöą░ą▓ą░ą╣č鹥 ą║čĆą░čéą║ąŠ čĆą░čüčüą╝ąŠčéčĆąĖą╝ ą║ąŠąĮčåąĄą┐čåąĖčÄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ.

[ą¦č鹊 čéą░ą║ąŠąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░]

ą¤ąŠč鹊ą║ čüčćąĖčéą░ąĄčéčüčÅ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮąĮčŗą╝, ą║ąŠą│ą┤ą░ ąĄą│ąŠ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖąĄ ą┐čĆąĖąŠčüčéą░ąĮąŠą▓ą╗ąĄąĮąŠ ą┐ąŠ ą║ą░ą║ąŠą╣-č鹊 ą┐čĆąĖčćąĖąĮąĄ, čéą░ą║ąŠą╣ ą║ą░ą║ ąĘą░čüčŗą┐ą░ąĮąĖąĄ (Sleep) ąĖą╗ąĖ ąŠąČąĖą┤ą░ąĮąĖąĄ ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ ą┤čĆčāą│ąŠą│ąŠ ą┐ąŠč鹊ą║ą░ čü ą┐ąŠą╝ąŠčēčīčÄ Join ąĖą╗ąĖ EndInvoke. ąŚą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮąĮčŗą╣ ą┐ąŠč鹊ą║ ąĮąĄą╝ąĄą┤ą╗ąĄąĮąĮąŠ čāčüčéčāą┐ą░ąĄčé č鹥ą║čāčēąĖą╣ ą║ą▓ą░ąĮčé ą┐čĆąŠčåąĄčüčüąŠčĆąĮąŠą│ąŠ ą▓čĆąĄą╝ąĄąĮąĖ, ąĖ čü čŹč鹊ą│ąŠ ą╝ąŠą╝ąĄąĮčéą░ ąĮąĄ ąĖčüą┐ąŠą╗čīąĘčāąĄčé ą┐čĆąŠčåąĄčüčüąŠčĆ, ą┐ąŠą║ą░ ąĮąĄ ą▒čāą┤ąĄčé čāą┤ąŠą▓ą╗ąĄčéą▓ąŠčĆąĄąĮąŠ čāčüą╗ąŠą▓ąĖąĄ čüąĮčÅčéąĖčÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ (blocking condition). ąÆčŗ ą╝ąŠąČąĄč鹥 ą┐čĆąŠą▓ąĄčĆąĖčéčī, ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮ ą╗ąĖ ą┐ąŠč鹊ą║, čü ą┐ąŠą╝ąŠčēčīčÄ ąĄą│ąŠ čüą▓ąŠą╣čüčéą▓ą░ ThreadState:

bool blocked = (someThread.ThreadState & ThreadState.WaitSleepJoin) != 0;

ą¤čĆąĖą╝ąĄčćą░ąĮąĖąĄ: čüąŠčüč鹊čÅąĮąĖąĄ ą┐ąŠč鹊ą║ą░ ą╝ąŠąČąĄčé ąĖąĘą╝ąĄąĮąĖčéčīčüčÅ ą▓ ą╝ąŠą╝ąĄąĮčé ąĄą│ąŠ ąŠą┐čĆąŠčüą░, ąĖ čüą░ą╝ąĖ ą┤ąĄą╣čüčéą▓ąĖčÅ ą┐ąŠ ą┐ąŠčüč鹊čÅąĮąĮąŠą╝čā ąŠą┐čĆąŠčüčā ąĮąĄ čĆąĄą║ąŠą╝ąĄąĮą┤čāčÄčéčüčÅ ą║ą░ą║ ąĮąĄ čŹčäč乥ą║čéąĖą▓ąĮčŗąĄ. ą¤ąŠčŹč鹊ą╝čā ą┐čĆąĖą▓ąĄą┤ąĄąĮąĮčŗą╣ ą▓čŗčłąĄ ą║ąŠą┤ ą┐ąŠą╗ąĄąĘąĄąĮ č鹊ą╗čīą║ąŠ ą▓ čüčåąĄąĮą░čĆąĖčÅčģ ą┤ąĖą░ą│ąĮąŠčüčéąĖą║ąĖ.

ąÜąŠą│ą┤ą░ ą┐ąŠč鹊ą║ ą▒ą╗ąŠą║ąĖčĆčāąĄčéčüčÅ ąĖą╗ąĖ čĆą░ąĘą▒ą╗ąŠą║ąĖčĆčāąĄčéčüčÅ, ąŠą┐ąĄčĆą░čåąĖąŠąĮąĮą░čÅ čüąĖčüč鹥ą╝ą░ (č鹊čćąĮąĄąĄ - ąĄčæ ą┐ą╗ą░ąĮąĖčĆąŠą▓čēąĖą║, sheduler) ą▓čŗą┐ąŠą╗ąĮčÅąĄčé čéą░ą║ ąĮą░ąĘčŗą▓ą░ąĄą╝ąŠąĄ ą┐ąĄčĆąĄą║ą╗čÄč湥ąĮąĖąĄ ą║ąŠąĮč鹥ą║čüčéą░ (context switch). ąŁčéą░ ąŠą┐ąĄčĆą░čåąĖčÅ ą▓ą╗ąĄč湥čé čéčĆą░čéčā ą┐čĆąŠčåąĄčüčüąŠčĆąĮąŠą│ąŠ ą▓čĆąĄą╝ąĄąĮąĖ ą▓ ąĮąĄčüą║ąŠą╗čīą║ąŠ ą╝ąĖą║čĆąŠčüąĄą║čāąĮą┤.

ąĀą░ąĘą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ąŠą┤ąĮąĖą╝ ąĖąĘ 4 čüą┐ąŠčüąŠą▒ąŠą▓ (ą║ąĮąŠą┐ą║ą░ ą┐ąĖčéą░ąĮąĖčÅ ąĮą░ čüąĖčüč鹥ą╝ąĮąŠą╝ ą▒ą╗ąŠą║ąĄ ą║ąŠą╝ą┐čīčÄč鹥čĆą░ ąĮąĄ čüčćąĖčéą░ąĄčéčüčÅ!):

ŌĆó ąŻą┤ąŠą▓ą╗ąĄčéą▓ąŠčĆąĄąĮąŠ čāčüą╗ąŠą▓ąĖąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ

ŌĆó ąśčüč鹥ą║ čéą░ą╣ą╝ą░čāčé ąŠą┐ąĄčĆą░čåąĖąĖ (ąĄčüą╗ąĖ ą▒čŗą╗ čāą║ą░ąĘą░ąĮ čéą░ą╣ą╝ą░čāčé)

ŌĆó ąĀą░ą▒ąŠčéą░ ą┐ąŠč鹊ą║ą░ ą▒čŗą╗ą░ ą┐čĆąĄčĆą▓ą░ąĮą░ čü ą┐ąŠą╝ąŠčēčīčÄ Thread.Interrupt [10]

ŌĆó ąĀą░ą▒ąŠčéą░ ą┐ąŠč鹊ą║ą░ ą▒čŗą╗ą░ ąŠą▒ąŠčĆą▓ą░ąĮą░ čü ą┐ąŠą╝ąŠčēčīčÄ Thread.Abort [10]

ą¤ąŠč鹊ą║ ąĮąĄ čüčćąĖčéą░ąĄčéčüčÅ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮąĮčŗą╝, ąĄčüą╗ąĖ ąĄą│ąŠ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖąĄ ą┐čĆąĖąŠčüčéą░ąĮąŠą▓ą╗ąĄąĮąŠ č湥čĆąĄąĘ (čāčüčéą░čĆąĄą▓čłąĖą╣) ą╝ąĄč鹊ą┤ Suspend [11].

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐čĆąŠčéąĖą▓ čåąĖą║ą╗ąŠą▓ ąŠą┐čĆąŠčüą░. ąśąĮąŠą│ą┤ą░ ą┐ąŠč鹊ą║ ą┤ąŠą╗ąČąĄąĮ ą┐ąŠčüčéą░ą▓ąĖčéčī čüą▓ąŠąĖ ą┤ąĄą╣čüčéą▓ąĖčÅ ąĮą░ ą┐ą░čāąĘčā, ą┐ąŠą║ą░ ąĮąĄ ą▓čŗą┐ąŠą╗ąĮąĖčéčüčÅ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮąŠąĄ čāčüą╗ąŠą▓ąĖąĄ. ąÜąŠąĮčüčéčĆčāą║čåąĖąĖ čüąĖą│ąĮą░ą╗ąĖąĘą░čåąĖąĖ ąĖ ą║čĆąĖčéąĖč湥čüą║ąĖčģ čüąĄą║čåąĖą╣ čŹčäč乥ą║čéąĖą▓ąĮąŠ čĆąĄčłą░čÄčé čŹčéčā ą┐čĆąŠą▒ą╗ąĄą╝čā čü ą┐ąŠą╝ąŠčēčīčÄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą┐ąŠč鹊ą║ą░ ą┤ąŠ ą╝ąŠą╝ąĄąĮčéą░, ą┐ąŠą║ą░ ąĮąĄ ą▒čāą┤ąĄčé čāą┤ąŠą▓ą╗ąĄčéą▓ąŠčĆąĄąĮąŠ čāčüą╗ąŠą▓ąĖąĄ. ą×ą┤ąĮą░ą║ąŠ ąĄčüčéčī ą▒ąŠą╗ąĄąĄ ą┐čĆąŠčüčéą░čÅ ą░ą╗čīč鹥čĆąĮą░čéąĖą▓ą░: ą┐ąŠč鹊ą║ ą╝ąŠąČąĄčé ąČą┤ą░čéčī ą┐ąŠčÅą▓ą╗ąĄąĮąĖčÅ ąĮčāąČąĮąŠą│ąŠ čāčüą╗ąŠą▓ąĖčÅ ą▓ ą┐ąŠčüč鹊čÅąĮąĮąŠ ą┐čĆąŠą║čĆčāčćąĖą▓ą░čÄčēąĄą╝čüčÅ čåąĖą║ą╗ąĄ ąŠą┐čĆąŠčüą░. ą¤čĆąĖą╝ąĄčĆ:

ąĖą╗ąĖ:

while (DateTime.Now < nextStartTime);

ą× ąŠą▒čēąĄą╝ čŹč鹊 ąŠč湥ąĮčī ąĘą░čéčĆą░čéąĮčŗą╣ čüą┐ąŠčüąŠą▒, ą▒ąĄčüą┐ąŠą╗ąĄąĘąĮąŠ čéčĆą░čéčÅčēąĖą╣ čĆąĄčüčāčĆčü ą┐čĆąŠčåąĄčüčüąŠčĆą░: ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ą░ CLR ąĖ ąŠą┐ąĄčĆą░čåąĖąŠąĮąĮą░čÅ čüąĖčüč鹥ą╝ą░ ą▒čāą┤čāčé čüčćąĖčéą░čéčī, čćč鹊 ą┐ąŠč鹊ą║ ą▓čŗą┐ąŠą╗ąĮčÅąĄčé ą▓ą░ąČąĮąŠąĄ ą▓čŗčćąĖčüą╗ąĄąĮąĖąĄ, ąĖ ą┤ą░čüčé ąĄą╝čā ąĮą░ čŹč鹊 čüąŠąŠčéą▓ąĄčéčüčéą▓čāčÄčēąĖąĄ ą▓čŗą┤ąĄą╗ąĄąĮąĮčŗąĄ čĆąĄčüčāčĆčüčŗ!

ąśąĮąŠą│ą┤ą░ ą┐čĆąĖą╝ąĄąĮčÅąĄčéčüčÅ ą│ąĖą▒čĆąĖą┤ ą╝ąĄąČą┤čā ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąŠą╣ ąĖ ą┐čĆąŠą║čĆčāčéą║ąŠą╣ čü ąŠą┐čĆąŠčüąŠą╝:

while (!proceed) Thread.Sleep (10);

ąźąŠčéčÅ čéą░ą║ąŠą╣ ą▓ą░čĆąĖą░ąĮčé ąĮąĄ čüą╗ąĖčłą║ąŠą╝ 菹╗ąĄą│ą░ąĮč鹥ąĮ, ąŠąĮ ąŠą▒čŗčćąĮąŠ ąĮą░ą╝ąĮąŠą│ąŠ ą▒ąŠą╗ąĄąĄ čŹčäč乥ą║čéąĖą▓ąĄąĮ č湥ą╝ ą┐čĆčÅą╝ą░čÅ ą┐čĆąŠą║čĆčāčéą║ą░ čåąĖą║ą╗ą░ ą▒ąĄąĘ ą▓čŗąĘąŠą▓ą░ Sleep. ąźąŠčéčÅ čéčāčé ą┐čĆąŠą▒ą╗ąĄą╝čŗ ą╝ąŠą│čāčé ą▓ąŠąĘąĮąĖą║ąĮčāčéčī ąĖąĘ-ąĘą░ ą┐čĆąŠą▒ą╗ąĄą╝ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░ ą║ ąŠą┐čĆą░čłąĖą▓ą░ąĄą╝ąŠą╝čā čäą╗ą░ą│čā, ą┐ąŠ ą║ąŠč鹊čĆąŠą╝čā ą▒čāą┤ąĄčé ąĘą░ą┐čāčēąĄąĮąŠ ą┐čĆąŠą┤ąŠą╗ąČąĄąĮąĖąĄ ą┤ąĄą╣čüčéą▓ąĖą╣. ą¤čĆą░ą▓ąĖą╗čīąĮąŠąĄ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĖ ąĖ čüąĖą│ąĮą░ą╗ąŠą▓ ą┐ąŠą╝ąŠą│ą░ąĄčé ąĖąĘą▒ąĄąČą░čéčī čŹč鹊ą╣ ą┐čĆąŠą▒ą╗ąĄą╝čŗ.

ą¤čĆąŠą║čĆčāčéą║ą░ čü čåąĖą║ą╗ąŠą╝ ąŠą┐čĆąŠčüą░ ą╝ąŠąČąĄčé ą▒čŗčéčī čĆąĄą┤ą║ąŠ čŹčäč乥ą║čéąĖą▓ąĮąŠą╣ č鹊ą╗čīą║ąŠ ą▓ č鹥čģ čüą╗čāčćą░čÅčģ, ą║ąŠą│ą┤ą░ ąÆčŗ ąŠąČąĖą┤ą░ąĄč鹥 čāą┤ąŠą▓ą╗ąĄčéą▓ąŠčĆąĄąĮąĖčÅ čāčüą╗ąŠą▓ąĖčÅ ą▓ ąŠč湥ąĮčī ą║čĆą░čéą║ąĖą╣ ą┐čĆąŠą╝ąĄąČčāč鹊ą║ ą▓čĆąĄą╝ąĄąĮąĖ (ą▓ąŠąĘą╝ąŠąČąĮąŠ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ąĮąĄčüą║ąŠą╗čīą║ąĖčģ ą╝ąĖą║čĆąŠčüąĄą║čāąĮą┤) ą┐ąŠč鹊ą╝čā čćč鹊 čŹč鹊 ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąĖąĘą▒ąĄąČą░čéčī čćčĆąĄąĘą╝ąĄčĆąĮąŠą╣ ąĮą░ą│čĆčāąĘą║ąĖ ąĮą░ ą┐čĆąŠčåąĄčüčüąŠčĆ ąĖ ąĘą░ą┤ąĄčƹȹ║ąĖ ąĮą░ ą┐ąĄčĆąĄą║ą╗čÄč湥ąĮąĖąĄ ą║ąŠąĮč鹥ą║čüčéą░. ąĪčĆąĄą┤ą░ .NET Framework ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅčÄčé ą┤ą╗čÅ čŹč鹊ą│ąŠ čüą┐ąĄčåąĖą░ą╗čīąĮčŗąĄ ą╝ąĄč鹊ą┤čŗ ąĖ ą║ą╗ą░čüčüčŗ, čćč鹊 čĆą░čüčüą╝ą░čéčĆąĖą▓ą░ąĄčéčüčÅ ą▓ čĆą░ąĘą┤ąĄą╗ąĄ ąŠą┐ąĖčüą░ąĮąĖčÅ ą┐ą░čĆą░ą╗ą╗ąĄą╗čīąĮąŠą│ąŠ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčĆąŠą▓ą░ąĮąĖčÅ [3].

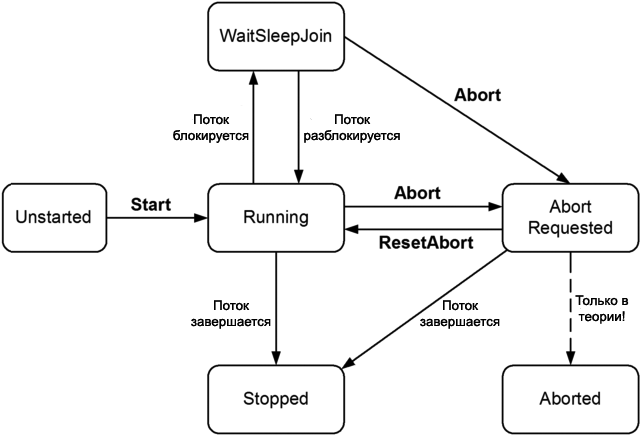

ąĪąŠčüč鹊čÅąĮąĖčÅ ą┐ąŠč鹊ą║ą░ (ThreadState). ąÆčŗ ą╝ąŠąČąĄč鹥 čāąĘąĮą░čéčī, ą▓ ą║ą░ą║ąŠą╝ ąĖąĘ čüąŠčüč鹊čÅąĮąĖą╣ ąĮą░čģąŠą┤ąĖčéčüčÅ ą┐ąŠč鹊ą║, ą┐čāč鹥ą╝ čćč鹥ąĮąĖčÅ čüą▓ąŠą╣čüčéą▓ą░ ThreadState. ąŁč鹊 ą▓ąĄčĆąĮąĄčé čäą╗ą░ą│ąĖ ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖčÅ čéąĖą┐ą░ ThreadState, ą║ąŠč鹊čĆčŗąĄ ą║ąŠą╝ą▒ąĖąĮąĖčĆčāčÄčé 3 "čüą╗ąŠčÅ" ą┤ą░ąĮąĮčŗčģ ą┐ąŠ ą┐čĆąĖąĮčåąĖą┐čā ą┐ąŠą▒ąĖčéąĮąŠą│ąŠ ą║ąŠą┤ąĖčĆąŠą▓ą░ąĮąĖčÅ ąĖąĮč乊čĆą╝ą░čåąĖąĖ. ą×ą┤ąĮą░ą║ąŠ ą▒ąŠą╗čīčłąĖąĮčüčéą▓ąŠ čŹčéąĖčģ ą▒ąĖčé ąĖąĘą▒čŗč鹊čćąĮčŗ, ąĮąĄ ąĖčüą┐ąŠą╗čīąĘčāčÄčéčüčÅ ąĖą╗ąĖ čāčüčéą░čĆąĄą╗ąĖ. ąØą░ ą┤ąĖą░ą│čĆą░ą╝ą╝ąĄ ąĮąĖąČąĄ ą┐ąŠą║ą░ąĘą░ąĮ ąŠą┤ąĖąĮ ąĖąĘ "čüą╗ąŠąĄą▓":

ąĪą╗ąĄą┤čāčÄčēąĖą╣ ą║ąŠą┤ ą┐čĆąĄąŠą▒čĆą░ąĘčāąĄčé ThreadState ą▓ ąŠą┤ąĮąŠ ąĖąĘ č湥čéčŗčĆąĄčģ ąĮą░ąĖą▒ąŠą╗ąĄąĄ ą┐ąŠą╗ąĄąĘąĮčŗčģ ąĘąĮą░č湥ąĮąĖą╣: Unstarted, Running, WaitSleepJoin ąĖ Stopped:

public static ThreadState SimpleThreadState (ThreadState ts)

{

return ts & (ThreadState.Unstarted |

ThreadState.WaitSleepJoin |

ThreadState.Stopped);

}

ąĪą▓ąŠą╣čüčéą▓ąŠ ThreadState ą┐ąŠą╗ąĄąĘąĮąŠ ą┤ą╗čÅ čåąĄą╗ąĄą╣ ą┤ąĖą░ą│ąĮąŠčüčéąĖą║ąĖ, ąĮąŠ ąĄą│ąŠ čćč鹥ąĮąĖąĄ ą▓ čåąĄą╗čÅčģ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ ą▒čāą┤ąĄčé čĆą░ą▒ąŠčéą░čéčī ąĮąĄčüčéą░ą▒ąĖą╗čīąĮąŠ, ą┐ąŠč鹊ą╝čā čćč鹊 čüąŠčüč鹊čÅąĮąĖąĄ ą┐ąŠč鹊ą║ą░ ą╝ąŠąČąĄčé ą┐ąŠą╝ąĄąĮčÅčéčīčüčÅ ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé, ą▓ č鹊ą╝ čćąĖčüą╗ąĄ ąĖ ą╝ąĄąČą┤čā ą┐čĆąŠą▓ąĄčĆą║ą░ą╝ąĖ ThreadState, ąĖ čŹč鹊 ą┐ąŠą▓ą╗ąĖčÅąĄčé ąĮą░ ą░ą║čéčāą░ą╗čīąĮąŠčüčéčī ą┐čĆąŠčćąĖčéą░ąĮąĮąŠą╣ ąĖąĘ ThreadState ąĖąĮč乊čĆą╝ą░čåąĖąĖ.

[ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░]

ąśčüą║ą╗čÄčćąĖč鹥ą╗čīąĮą░čÅ, ąĖą╗ąĖ ą╝ąŠąĮąŠą┐ąŠą╗čīąĮą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ (exclusive locking) ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ, čćč鹊ą▒čŗ ą│ą░čĆą░ąĮčéąĖčĆąŠą▓ą░čéčī, čćč鹊 č鹊ą╗čīą║ąŠ ąŠą┤ąĖąĮ ą┐ąŠč鹊ą║ ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ ą╝ąŠą│ ą▓ąŠą╣čéąĖ ą▓ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮčāčÄ čüąĄą║čåąĖčÄ ą║ąŠą┤ą░. ąĢčüčéčī ą┤ą▓ąĄ ąŠčüąĮąŠą▓ąĮčŗąĄ ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ ą┤ą╗čÅ exclusive locking, čŹč鹊 lock ąĖ Mutex. ąśąĘ čŹčéąĖčģ ą┤ą▓čāčģ ą║ąŠąĮčüčéčĆčāą║čåąĖčÅ lock čĆą░ą▒ąŠčéą░ąĄčé ą▒čŗčüčéčĆąĄąĄ ąĖ ą▒ąŠą╗ąĄąĄ čāą┤ąŠą▒ąĄąĮ. ą×ą┤ąĮą░ą║ąŠ čā Mutex ąĄčüčéčī ąĮąĖčłą░, ą▓ ą║ąŠč鹊čĆąŠą╣ ąĄčæ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą╝ąŠąČąĄčé ąŠčģą▓ą░čéąĖčéčī ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ ą▓ čĆą░ąĘą╗ąĖčćąĮčŗčģ ą┐čĆąŠčåąĄčüčüą░čģ, čĆą░ą▒ąŠčéą░čÄčēąĖčģ ąĮą░ ą║ąŠą╝ą┐čīčÄč鹥čĆąĄ (č湥ą╝ ąŠčéą╗ąĖčćą░ąĄčéčüčÅ ą┐čĆąŠčåąĄčüčü ąŠčé ą┐ąŠč鹊ą║ą░ čüą╝. [1]).

ąÆ čŹč鹊ą╣ čüąĄą║čåąĖąĖ ą╝čŗ ąĮą░čćąĮąĄą╝ ąŠą▒čüčāąČą┤ąĄąĮąĖčÅ čü ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ lock, ąĖ ąĘą░č鹥ą╝ ą┐ąĄčĆąĄą╣ą┤ąĄą╝ ą║ čĆą░čüčüą╝ąŠčéčĆąĄąĮąĖčÄ Mutex ąĖ čüąĄą╝ą░č乊čĆą░ą╝ (ą┤ą╗čÅ ąĮąĄ ąĖčüą║ą╗čÄčćąĖč鹥ą╗čīąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ, nonexclusive locking). ą¤ąŠąĘąČąĄ ą╝čŗ čĆą░čüčüą╝ąŠčéčĆąĖą╝ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ reader/writer [4].

ąØą░čćąĖąĮą░čÅ čü Framework 4.0 ąĄčüčéčī čéą░ą║ąČąĄ čüčéčĆčāą║čéčāčĆą░ SpinLock ą┤ą╗čÅ čüčåąĄąĮą░čĆąĖąĄą▓ ą║ąŠą┤ą░, ą▓čŗą┐ąŠą╗ąĮčÅčÄčēąĄą│ąŠčüčÅ ą▓ čāčüą╗ąŠą▓ąĖčÅčģ ą▓čŗčüąŠą║ąŠą╣ ą║ąŠąĮą║čāčĆąĄąĮčåąĖąĖ.

ąØą░čćąĮąĄą╝ čü ą┐čĆąĖą╝ąĄčĆą░ čüą╗ąĄą┤čāčÄčēąĄą│ąŠ ą║ą╗ą░čüčüą░:

class ThreadUnsafe

{

static int _val1 = 1, _val2 = 1;

static void Go()

{

if (_val2 != 0) Console.WriteLine (_val1 / _val2);

_val2 = 0;

}

}

ąŁč鹊čé ą║ą╗ą░čüčü ąĮąĄ ą▒čāą┤ąĄčé ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝: ąĄčüą╗ąĖ Go ą▒čŗą╗ ą▓čŗąĘą▓ą░ąĮ ą┤ą▓čāą╝čÅ ą┐ąŠč鹊ą║ą░ą╝ąĖ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ, č鹊 ąĄčüčéčī ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ą┐ąŠą╗čāč湥ąĮąĖčÅ ąŠčłąĖą▒ą║ąĖ ą┤ąĄą╗ąĄąĮąĖčÅ ąĮą░ 0, ą┐ąŠč鹊ą╝čā čćč鹊 _val2 čāčüčéą░ąĮąŠą▓ąĖą╗ą░čüčī ą▒čŗ ą▓ 0 ą▓ ąŠą┤ąĮąŠą╝ ą┐ąŠč鹊ą║ąĄ, ą▓ ąĖ ą▓ ą┤čĆčāą│ąŠą╝ ą┐ąŠč鹊ą║ąĄ ą▓ čŹč鹊 ąČąĄ ą▓čĆąĄą╝čÅ ą╝ąŠą│ ą▒čŗ ą▓čŗą┐ąŠą╗ąĮčÅčéčīčüčÅ ąŠą┐ąĄčĆą░č鹊čĆ ą▓ ą┐ą░čĆą░ą╝ąĄčéčĆąĄ ą▓čŗąĘąŠą▓ą░ Console.WriteLine.

ąÆąŠčé čéą░ą║ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ lock ą╝ąŠąČąĄčé ąĖčüą┐čĆą░ą▓ąĖčéčī čŹčéčā ą┐čĆąŠą▒ą╗ąĄą╝čā:

class ThreadSafe

{

static readonly object _locker = new object();

static int _val1, _val2;

static void Go()

{

lock (_locker)

{

// ąØą░čćą░ą╗ąŠ ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĖ ą║ąŠą┤ą░

if (_val2 != 0) Console.WriteLine (_val1 / _val2);

_val2 = 0;

// ąÜąŠąĮąĄčå ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĖ ą║ąŠą┤ą░

}

}

}

ąóąŠą╗čīą║ąŠ ąŠą┤ąĖąĮ ą┐ąŠč鹊ą║ ą╝ąŠąČąĄčé ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčī ąŠą▒čŖąĄą║čé čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ lock (ą▓ čŹč鹊ą╝ ą┐čĆąĖą╝ąĄčĆąĄ ąŠą▒čŖąĄą║čé čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ _locker). ąøčÄą▒čŗąĄ ą┐čĆąĄč鹥ąĮą┤čāčÄčēąĖąĄ ąĮą░ ą┤ąŠčüčéčāą┐ ą║ lock-čāčćą░čüčéą║čā ą║ąŠą┤ą░ ą▒čāą┤čāčé ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮčŗ, ą┐ąŠą║ą░ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĮąĄ ą▒čāą┤ąĄčé čüąĮčÅčéą░ (čé. ąĄ. ą┐ąŠą║ą░ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖąĄ ąĮąĄ ą▓čŗą╣ą┤ąĄčé ąĘą░ ą┐čĆąĄą┤ąĄą╗čŗ lock-čāčćą░čüčéą║ą░ ą║ąŠą┤ą░). ąóą░ą║ąŠą╣ čāčćą░čüč鹊ą║ ą║ąŠą┤ą░ čéą░ą║ąČąĄ ąĮą░ąĘčŗą▓ą░čÄčé ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĄą╣. ąĢčüą╗ąĖ ą▒ąŠą╗čīčłąĄ ąŠą┤ąĮąŠą│ąŠ ą┐ąŠč鹊ą║ą░ ą┐čĆąĄč鹥ąĮą┤čāčÄčé ąĮą░ ą┤ąŠčüčéčāą┐ ą║ čĆąĄą│ąĖąŠąĮčā ą║ąŠą┤ą░ lock, č鹊 ąŠąĮąĖ čüčéą░ą▓čÅčéčüčÅ ą▓ ąŠč湥čĆąĄą┤čī ą│ąŠč鹊ą▓ąĮąŠčüčéąĖ (ready queue), ąĖ ą┤ąŠčüčéčāą┐ ą║ ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĖ ą▒čāą┤ąĄčé ą┤ą░ą▓ą░čéčīčüčÅ ą┐ąŠ ą┐čĆąĖąĮčåąĖą┐čā FIFO, čé. ąĄ. ą┐ąĄčĆą▓čŗą╝ ąĘą░ą┐čĆąŠčüąĖą╗ ą┤ąŠčüčéčāą┐ - ą┐ąĄčĆą▓čŗą╝ ą┐ąŠą╗čāčćąĖčé ą┤ąŠčüčéčāą┐ (ąĮąĄą║ą░čÅ ą┐čĆąŠą▒ą╗ąĄą╝ą░ ąĘą┤ąĄčüčī ąĘą░ą║ą╗čÄčćą░ąĄčéčüčÅ ą▓ ąĮčÄą░ąĮčüą░čģ ą┐ąŠą▓ąĄą┤ąĄąĮąĖčÅ ą┐ą╗ą░ąĮąĖčĆąŠą▓čēąĖą║ą░ Windows ąĖ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ąĖ CLR, ą▓ čĆąĄąĘčāą╗čīčéą░č鹥 č湥ą│ąŠ čŹč鹊čé ą┐ąŠčĆčÅą┤ąŠą║ ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗ąĄąĮąĖčÅ ą┤ąŠčüčéčāą┐ą░ ąĖąĮąŠą│ą┤ą░ ąĮą░čĆčāčłą░ąĄčéčüčÅ). ąśčüą║ą╗čÄčćąĖč鹥ą╗čīąĮčŗąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ, ą║ą░ą║ ąĖąĮąŠą│ą┤ą░ ą│ąŠą▓ąŠčĆčÅčé, ą┐čĆąĖąĮčāąČą┤ą░ąĄčé ą║ ą┐čĆąĖą╝ąĄąĮąĄąĮąĖčÄ čüčéčĆąŠą│ąŠ ą┐ąŠčüą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░ (serialized access) ą║ čāčćą░čüčéą║čā ą║ąŠą┤ą░, ąĘą░čēąĖčēąĄąĮąĮąŠą╝čā lock, ą┐ąŠč鹊ą╝čā čćč鹊 ą┤ąŠčüčéčāą┐ čüąŠ čüč鹊čĆąŠąĮčŗ ąŠą┤ąĮąŠą│ąŠ ą┐ąŠč鹊ą║ą░ ąĮąĖą║ąŠą│ą┤ą░ ąĮąĄ ą╝ąŠąČąĄčé ą┐ąĄčĆąĄą║čĆčŗčéčī ą┤ąŠčüčéčāą┐ ą┤čĆčāą│ąŠą│ąŠ. ąÆ ąĮą░čłąĄą╝ ą┐čĆąĖą╝ąĄčĆąĄ ą╗ąŠą│ąĖą║ą░ ąĘą░čēąĖčéčŗ ą┐čĆąĖą╝ąĄąĮąĄąĮą░ ą▓ąĮčāčéčĆąĖ ą╝ąĄč鹊ą┤ą░ Go method, ą║ąŠą│ą┤ą░ ąŠčüčāčēąĄčüčéą▓ą╗čÅąĄčéčüčÅ ą┤ąŠčüčéčāą┐ ą║ ą┐ąŠą╗čÅą╝ _val1 ąĖ _val2.

ą¤ąŠč鹊ą║ ą▒ą╗ąŠą║ąĖčĆčāąĄčéčüčÅ, ą┐ąŠą║ą░ ąŠčüą┐ą░čĆąĖą▓ą░ąĄą╝čŗą╣ čāčćą░čüč鹊ą║ ą║čĆąĖčéąĖč湥čüą║ąŠą│ąŠ ą║ąŠą┤ą░ ąĮą░čģąŠą┤ąĖčéčüčÅ ą▓ čüąŠčüč鹊čÅąĮąĖąĖ ThreadState WaitSleepJoin. ą¤čĆąĖ čĆą░čüčüą╝ąŠčéčĆąĄąĮąĖąĖ Interrupt ąĖ Abort ą▒čāą┤ąĄčé ąŠą┐ąĖčüą░ąĮąŠ, ą║ą░ą║ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮąĮčŗą╣ ą┐ąŠč鹊ą║ ą╝ąŠąČąĄčé ą▒čŗčéčī ą┐čĆąĖąĮčāą┤ąĖč鹥ą╗čīąĮąŠ ąŠčüą▓ąŠą▒ąŠąČą┤ąĄąĮ ą┤čĆčāą│ąĖą╝ ą┐ąŠč鹊ą║ąŠą╝. ąŁč鹊 ą┤ąŠą▓ąŠą╗čīąĮąŠ ą╝ąŠčēąĮčŗą╣ ą╝ąĄč鹊ą┤, ą║ąŠč鹊čĆčŗą╣ ą╝ąŠąČąĄčé ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčīčüčÅ ą┤ą╗čÅ ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ ą┐ąŠč鹊ą║ą░.

| ąÜąŠąĮčüčéčĆčāą║čåąĖčÅ |

ąØą░ąĘąĮą░č湥ąĮąĖąĄ |

ąĀą░ą▒ąŠčéą░ąĄčé ą╝ąĄąČą┤čā ą┐čĆąŠčåąĄčüčüą░ą╝ąĖ? |

ąŚą░ą│čĆčāąĘą║ą░(*) |

| lock (Monitor.Enter / Monitor.Exit) |

ąōą░čĆą░ąĮčéąĖčĆčāąĄčé, čćč鹊 č鹊ą╗čīą║ąŠ ąŠą┤ąĖąĮ ą┐ąŠč鹊ą║ ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ ą╝ąŠąČąĄčé ą┐ąŠą╗čāčćąĖčéčī ą┤ąŠčüčéčāą┐ ą║ čĆąĄčüčāčĆčüčā ąĖą╗ąĖ čüąĄą║čåąĖąĖ ą║ąŠą┤ą░. |

- |

20 ąĮčü |

| Mutex |

ąöąÉ |

1000 ąĮčü |

| SemaphoreSlim (ą┤ąŠą▒ą░ą▓ą╗ąĄąĮąŠ ą▓ Framework 4.0) |

ąōą░čĆą░ąĮčéąĖčĆčāąĄčé, čćč鹊 ąĮąĄ ą▒ąŠą╗ąĄąĄ čāą║ą░ąĘą░ąĮąĮąŠą│ąŠ ą║ąŠą╗ąĖč湥čüčéą▓ą░ ą┐ąŠč鹊ą║ąŠą▓ ą╝ąŠą│čāčé ą┐ąŠą╗čāčćąĖčéčī ą┤ąŠčüčéčāą┐ ą║ čĆąĄčüčāčĆčüčā ąĖą╗ąĖ čüąĄą║čåąĖąĖ ą║ąŠą┤ą░. |

- |

200 ąĮčü |

| Semaphore |

ąöąÉ |

1000 ąĮčü |

| ReaderWriterLockSlim (ą┤ąŠą▒ą░ą▓ą╗ąĄąĮąŠ ą▓ Framework 3.5) |

ą¤ąŠąĘą▓ąŠą╗čÅąĄčé ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ čćąĖčéą░čÄčēąĖą╝ ą┐ąŠč鹊ą║ą░ą╝ čüčāčēąĄčüčéą▓ąŠą▓ą░čéčī ą▓ą╝ąĄčüč鹥 čü ąŠą┤ąĮąĖą╝ ąĘą░ą┐ąĖčüčŗą▓ą░čÄčēąĖą╝. |

- |

40 ąĮčü |

| ReaderWriterLock (čüąĖą╗čīąĮąŠ čāčüčéą░čĆąĄą╗ąŠ) |

- |

100 ąĮčü |

ą¤čĆąĖą╝ąĄčćą░ąĮąĖąĄ (*): ą▓čĆąĄą╝čÅ, ą║ąŠč鹊čĆąŠąĄ čéčĆą░čéąĖčéčüčÅ ąĮą░ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ąĖ čĆą░ąĘą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ ąĮą░ ąŠą┤ąĮąŠą╝ ąĖ č鹊ą╝ ąČąĄ ą┐ąŠč鹊ą║ąĄ (ą┐ąŠą┤čĆą░ąĘčāą╝ąĄą▓ą░čÅ, čćč鹊 ą┤čĆčāą│ąĖąĄ ą┐ąŠč鹊ą║ąĖ ąĮąĄ ą▒ą╗ąŠą║ąĖčĆčāčÄčéčüčÅ), ą║ą░ą║ čŹč鹊 ą▒čŗą╗ąŠ ąĖąĘą╝ąĄčĆąĄąĮąŠ ąĮą░ ą┐čĆąŠčåąĄčüčüąŠčĆąĄ Intel Core i7 860.

Monitor.Enter ąĖ Monitor.Exit. ą×ą┐ąĄčĆą░č鹊čĆ lock ąĮą░ C# čäą░ą║čéąĖč湥čüą║ąĖ čÅą▓ą╗čÅąĄčéčüčÅ "čüąĖąĮčéą░ą║čüąĖč湥čüą║ąĖą╝ čüą░čģą░čĆąŠą╝", čé. ąĄ. ąŠą▒ąĄčĆčéą║ą░ą╝ąĖ ąĮą░ą┤ ą▓čŗąĘąŠą▓ą░ą╝ąĖ ą╝ąĄč鹊ą┤ąŠą▓ Monitor.Enter ąĖ Monitor.Exit čü ą▒ą╗ąŠą║ąŠą╝ try/finally. ąŁč鹊 ą┐čĆąĄą┤čüčéą░ą▓ą╗čÅąĄčé ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčüčéčā čāą┐čĆąŠčēąĄąĮąĮčāčÄ ą▓ąĄčĆčüąĖčÄ č鹊ą│ąŠ, čćč鹊 čĆąĄą░ą╗čīąĮąŠ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ą▓ąĮčāčéčĆąĖ ą╝ąĄč鹊ą┤ą░ Go ą▓ ą┐čĆąĄą┤čŗą┤čāčēąĄą╝ ą┐čĆąĖą╝ąĄčĆąĄ:

Monitor.Enter (_locker);

try

{

if (_val2 != 0) Console.WriteLine (_val1 / _val2);

_val2 = 0;

}

finally { Monitor.Exit (_locker); }

ąÆčŗąĘąŠą▓ Monitor.Exit ą▒ąĄąĘ ą┐čĆąĄą┤čłąĄčüčéą▓čāčÄčēąĄą│ąŠ ą▓čŗąĘąŠą▓ą░ Monitor.Enter ąĮą░ ąŠą┤ąĮąŠą╝ ąĖ č鹊ą╝ ąČąĄ ąŠą▒čŖąĄą║č鹥 ą┐čĆąĖą▓ąĄą┤ąĄčé ą║ ą▓čŗą▒čĆą░čüčŗą▓ą░ąĮąĖčÄ ąĖčüą║ą╗čÄč湥ąĮąĖčÅ.

ą¤ąĄčĆąĄąĘą░ą│čĆčāąĘą║ąĖ lockTaken. ąÜąŠą┤, ą║ąŠč鹊čĆčŗą╣ ą╝čŗ č鹊ą╗čīą║ąŠ čćč鹊 ą┐čĆąŠą┤ąĄą╝ąŠąĮčüčéčĆąĖčĆąŠą▓ą░ą╗ąĖ, ąĮą░ ą║ąŠą╝ą┐ąĖą╗čÅč鹊čĆą░čģ C# ą▓ąĄčĆčüąĖčÅ 1.0, 2.0 ąĖ 3.0 ą▒čāą┤ąĄčé čéčĆą░ąĮčüą╗ąĖčĆąŠą▓ą░čéčīčüčÅ ąĖąĘ ąŠą┐ąĄčĆą░č鹊čĆą░ lock.

ą×ą┤ąĮą░ą║ąŠ ą▓ čŹč鹊ą╝ ą║ąŠą┤ąĄ ąĄčüčéčī č鹊ąĮą║ą░čÅ čāčÅąĘą▓ąĖą╝ąŠčüčéčī. ąĀą░čüčüą╝ąŠčéčĆąĖą╝ (ą╝ą░ą╗ąŠą▓ąĄčĆąŠčÅčéąĮąŠąĄ) čüąŠą▒čŗčéąĖąĄ ąĖčüą║ą╗čÄč湥ąĮąĖčÅ, ą║ąŠč鹊čĆąŠąĄ ą▓čŗą▒čĆą░čüčŗą▓ą░ąĄčéčüčÅ čü čĆąĄą░ą╗ąĖąĘą░čåąĖąĄą╣ Monitor.Enter ą╝ąĄąČą┤čā ą▓čŗąĘąŠą▓ąŠą╝ Monitor.Enter ąĖ ą▒ą╗ąŠą║ąŠą╝ try (ą┐čĆąĖ čŹč鹊ą╝ ą▓ąŠąĘą╝ąŠąČąĮąŠ ą▒čāą┤ąĄčé ą▓čŗąĘą▓ą░ąĮ Abort ąĮą░ čŹč鹊ą╝ ą┐ąŠč鹊ą║ąĄ, ą╗ąĖą▒ąŠ ą▓čŗą▒čĆą░čüčŗą▓ą░ąĮąĖąĄ ąĖčüą║ą╗čÄč湥ąĮąĖąĄ OutOfMemoryException). ąÆ čéą░ą║ąŠą╝ čüčåąĄąĮą░čĆąĖąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą╝ąŠąČąĄčé ąĮąĄ ą┐čĆąŠąĖąĘąŠą╣čéąĖ. ąĢčüą╗ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐čĆąŠąĖąĘąŠčłą╗ą░, č鹊 ąŠąĮą░ ąĮąĄ ą▒čāą┤ąĄčé ąŠčüą▓ąŠą▒ąŠąČą┤ąĄąĮą░ - ą┐ąŠč鹊ą╝čā čćč鹊 ą╝čŗ ąĮąĖą║ąŠą│ą┤ą░ ąĮąĄ ą▓ąŠą╣ą┤ąĄą╝ ą▓ ą▒ą╗ąŠą║ try/finally. ąŁč鹊 ą┐čĆąĖą▓ąĄą┤ąĄčé ą║ ą┐čĆąŠą┐čāčēąĄąĮąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ (leaked lock).

ąöą╗čÅ čāčüčéčĆą░ąĮąĄąĮąĖčÅ čŹč鹊ą╣ ąŠą┐ą░čüąĮąŠčüčéąĖ čĆą░ąĘčĆą░ą▒ąŠčéčćąĖą║ąĖ CLR 4.0 ą┤ąŠą▒ą░ą▓ąĖą╗ąĖ čüą╗ąĄą┤čāčÄčēčāčÄ ą┐ąĄčĆąĄąĘą░ą│čĆčāąĘą║čā ą┤ą╗čÅ Monitor.Enter:

public static void Enter (object obj, ref bool lockTaken);

ą¤ą░čĆą░ą╝ąĄčéčĆ lockTaken čĆą░ą▓ąĄąĮ false ą┐ąŠčüą╗ąĄ čŹč鹊ą│ąŠ ą╝ąĄč鹊ą┤ą░ ąĄčüą╗ąĖ (ąĖ č鹊ą╗čīą║ąŠ ąĄčüą╗ąĖ) ą╝ąĄč鹊ą┤ Enter ą▓čŗą▒čĆąŠčüąĖą╗ ąĖčüą║ą╗čÄč湥ąĮąĖąĄ ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ lock ąĮąĄ ą▒čŗą╗ą░ ą▓ąĘčÅčéą░.

ąÆąŠčé ą║ąŠčĆčĆąĄą║čéąĮčŗą╣ čłą░ą▒ą╗ąŠąĮ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ (ą▓ ą║ąŠč鹊čĆčŗą╣ C# 4.0 ą▒čāą┤ąĄčé čéčĆą░ąĮčüą╗ąĖčĆąŠą▓ą░čéčī ąŠą┐ąĄčĆą░č鹊čĆ lock):

bool lockTaken = false;

try

{

Monitor.Enter (_locker, ref lockTaken);

// ąóčāčé ą║ą░ą║ąŠą╣-č鹊 ąĮą░čł ą║ąŠą┤...

}

finally { if (lockTaken) Monitor.Exit (_locker); }

TryEnter. ąóą░ą║ąČąĄ ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅąĄčé ą╝ąĄč鹊ą┤ TryEnter, ą║ąŠč鹊čĆčŗą╣ ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąĘą░ą┤ą░čéčī čéą░ą╣ą╝ą░čāčé ą╗ąĖą▒ąŠ ą▓ ą╝ąĖą╗ą╗ąĖčüąĄą║čāąĮą┤ą░čģ, ą╗ąĖą▒ąŠ č湥čĆąĄąĘ TimeSpan. ąŁč鹊čé ą╝ąĄč鹊ą┤ ą▓ąĄčĆąĮąĄčé true, ąĄčüą╗ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą▒čŗą╗ą░ ą┐ąŠą╗čāč湥ąĮą░, ąĖą╗ąĖ false, ąĄčüą╗ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĮąĄ ą▒čŗą╗ą░ ą┐ąŠą╗čāč湥ąĮą░ ąĖąĘ-ąĘą░ čéą░ą╣ą╝ą░čāčéą░ ą╝ąĄč鹊ą┤ą░. TryEnter ą╝ąŠąČąĄčé ą▒čŗčéčī čéą░ą║ąČąĄ ą▓čŗąĘą▓ą░ąĮ ą▒ąĄąĘ ą░čĆą│čāą╝ąĄąĮčéą░, čćč鹊 "ą┐čĆąŠą▓ąĄčĆčÅąĄčé" ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā lock, čéą░ą╣ą╝ą░čāčé ą┐čĆąŠąĖąĘąŠą╣ą┤ąĄčé ąĮąĄą╝ąĄą┤ą╗ąĄąĮąĮąŠ, ąĄčüą╗ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĮąĄ ą╝ąŠąČąĄčé ą▒čŗčéčī ą┐ąŠą╗čāč湥ąĮą░ ąĮą░ą┤ą╗ąĄąČą░čēąĖą╝ čüą┐ąŠčüąŠą▒ąŠą╝.

ąÜą░ą║ ąĖ ą╝ąĄč鹊ą┤ Enter, ą╝ąĄč鹊ą┤ TryEnter ą┐ąĄčĆąĄąĘą░ą│čĆčāąČąĄąĮ ą▓ CLR 4.0, čćč鹊ą▒čŗ ą┐čĆąĖąĮčÅčéčī ą░čĆą│čāą╝ąĄąĮčé lockTaken.

ąÆčŗą▒ąŠčĆ ąŠą▒čŖąĄą║čéą░ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ. ąøčÄą▒ąŠą╣ ąŠą▒čŖąĄą║čé, ą▓ąĖą┤ąĖą╝čŗą╣ ą║ą░ąČą┤ąŠą╝čā ąĖąĘ čāčćą░čüčéą▓čāčÄčēąĖčģ ą▓ ąŠą▒čēąĄą╣ čĆą░ą▒ąŠč鹥 ą┐ąŠč鹊ą║ąŠą▓, ą╝ąŠąČąĄčé ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčīčüčÅ ą▓ ą║ą░č湥čüčéą▓ąĄ čüąĖąĮčģčĆąŠąĮąĖąĘąĖčĆčāčÄčēąĄą│ąŠ ąŠą▒čŖąĄą║čéą░ čüąŠą│ą╗ą░čüąĮąŠ ąŠą┤ąĮąŠą╝čā ąČąĄčüčéą║ąŠą╝čā ą┐čĆą░ą▓ąĖą╗čā: čŹč鹊 ą┤ąŠą╗ąČąĄąĮ ą▒čŗčéčī čüčüčŗą╗ąŠčćąĮčŗą╣ čéąĖą┐ (reference type). ąĪąĖąĮčģčĆąŠąĮąĖąĘąĖčĆčāčÄčēąĖą╣ ąŠą▒čŖąĄą║čé ąŠą▒čŗčćąĮąŠ ąĖą╝ąĄąĄčé ąŠą▒ą╗ą░čüčéčī ą┤ąŠčüčéčāą┐ą░ private (ą┐ąŠč鹊ą╝čā čćč鹊 čŹč鹊 ą┐ąŠą╝ąŠą│ą░ąĄčé ąĖąĮą║ą░ą┐čüčāą╗ąĖčĆąŠą▓ą░čéčī ą╗ąŠą│ąĖą║čā ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ) ąĖ ąŠą▒čŗčćąĮąŠ čŹč鹊 ą┐ąŠą╗ąĄ 菹║ąĘąĄą╝ą┐ą╗čÅčĆą░ ąĖą╗ąĖ čüčéą░čéąĖč湥čüą║ąŠąĄ ą┐ąŠą╗ąĄ. ąĪąĖąĮčģčĆąŠąĮąĖąĘąĖčĆčāčÄčēąĖą╣ ąŠą▒čŖąĄą║čé ą╝ąŠąČąĄčé ąĖą╝ąĄčéčī ą┤ą▓ąŠą╣ąĮąŠąĄ ąĮą░ąĘąĮą░č湥ąĮąĖąĄ, čé. ąĄ. ąŠąĮ ą╝ąŠąČąĄčé ą▒čŗčéčī ą▓čüčéčĆąŠąĄąĮ ą▓ ąĘą░čēąĖčēą░ąĄą╝čŗą╣ ąŠą▒čŖąĄą║čé, ą║ą░ą║ čŹč鹊 ą┤ąĄą╗ą░ąĄčé ą┐ąŠą╗ąĄ _list ą▓ čüą╗ąĄą┤čāčÄčēąĄą╝ ą┐čĆąĖą╝ąĄčĆąĄ:

class ThreadSafe

{

List < string> _list = new List < string>();

void Test()

{

lock (_list)

{

_list.Add ("Item 1");

...

ą¤ąŠą╗ąĄ, ą▓čŗą┤ąĄą╗ąĄąĮąĮąŠąĄ ą┤ą╗čÅ čŹč鹊ą╣ čåąĄą╗ąĖ (čéą░ą║ąŠąĄ ą║ą░ą║ _locker ą▓ ą┐čĆąĄą┤čŗą┤čāčēąĄą╝ ą┐čĆąĖą╝ąĄčĆąĄ), ą┐ąŠąĘą▓ąŠą╗čÅąĄčé č鹊čćąĮąŠąĄ čāą┐čĆą░ą▓ą╗ąĄąĮąĖąĄ ąŠą▒ą╗ą░čüčéčīčÄ ą┤ąĄą╣čüčéą▓ąĖčÅ ąĖ ą│čĆą░ąĮčāą╗čÅčĆąĮąŠčüčéčīčÄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ą×ą▒čŖąĄą║čé č鹥ą║čāčēąĄą│ąŠ čüąŠą┤ąĄčƹȹĖą╝ąŠą│ąŠ (containing object, this) - ąĖą╗ąĖ ą┤ą░ąČąĄ ąĄą│ąŠ čéąĖą┐ - čéą░ą║ąČąĄ ą╝ąŠąČąĄčé ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčīčüčÅ ą▓ ą║ą░č湥čüčéą▓ąĄ ąŠą▒čŖąĄą║čéą░ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ:

ąĖą╗ąĖ:

lock (typeof (Widget)) { ... } // ąöą╗čÅ ąĘą░čēąĖčéčŗ ą┤ąŠčüčéčāą┐ą░ ą║ static-ą┤ą░ąĮąĮčŗą╝

ąØąĄą┤ąŠčüčéą░č鹊ą║ čéą░ą║ąŠą│ąŠ čüą┐ąŠčüąŠą▒ą░ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▓ č鹊ą╝, čćč鹊 ąÆčŗ ąĮąĄ ąĖąĮą║ą░ą┐čüčāą╗ąĖčĆčāąĄč鹥 ąŠčéą┤ąĄą╗čīąĮąŠ ą╗ąŠą│ąĖą║čā ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ, ąĖ čüčéą░ąĮąŠą▓ąĖčéčüčÅ čüą╗ąŠąČąĮąĄąĄ ąĘą░čēąĖčéąĖčéčīčüčÅ ąŠčé ą│ą╗čāčģąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ (deadlocking, čüą╝. ąĮąĖąČąĄ) ąĖ ąĖąĘą╗ąĖčłąĮąĄą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ (excessive blocking). ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĮą░ čéąĖą┐ąĄ čéą░ą║ąČąĄ ą╝ąŠąČąĄčé ą┐čĆąŠčüąŠčćąĖčéčīčüčÅ č湥čĆąĄąĘ ą│čĆą░ąĮąĖčåčŗ ą┤ąŠą╝ąĄąĮą░ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ (ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ąŠą┤ąĮąŠą│ąŠ ąĖ č鹊ą│ąŠ ąČąĄ ą┐čĆąŠčåąĄčüčüą░).

ąóą░ą║ąČąĄ ąÆčŗ ą╝ąŠąČąĄč鹥 čĆąĄą░ą╗ąĖąĘąŠą▓ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā lock ąĮą░ ą╗ąŠą║ą░ą╗čīąĮčŗčģ ą┐ąĄčĆąĄą╝ąĄąĮąĮčŗčģ, ąĘą░čģą▓ą░č湥ąĮąĮčŗčģ lambda-ą▓čŗčĆą░ąČąĄąĮąĖčÅą╝ąĖ ąĖą╗ąĖ anonymous-ą╝ąĄč鹊ą┤ą░ą╝ąĖ.

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĮąĄ ąŠą│čĆą░ąĮąĖčćąĖą▓ą░ąĄčé ą║ą░ą║ąĖą╝-ą╗ąĖą▒ąŠ ąŠą▒čĆą░ąĘąŠą╝ ą┤ąŠčüčéčāą┐ ą║ čüą░ą╝ąŠą╝čā ąŠą▒čŖąĄą║čéčā. ąöčĆčāą│ąĖą╝ąĖ čüą╗ąŠą▓ą░ą╝ąĖ, x.ToString() ąĮąĄ ą▒čāą┤ąĄčé ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčīčüčÅ, ą┐ąŠč鹊ą╝čā čćč鹊 ą┤čĆčāą│ąŠą╣ ą┐ąŠč鹊ą║ ą▓čŗąĘą▓ą░ą╗ lock(x); ąŠą▒ą░ ą┐ąŠč鹊ą║ą░ ą┤ąŠą╗ąČąĮčŗ ą▓čŗąĘą▓ą░čéčī lock(x), čćč鹊ą▒čŗ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐čĆąŠąĖąĘąŠčłą╗ą░.

ąÜąŠą│ą┤ą░ ą┐čĆąĖą╝ąĄąĮčÅčéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā? ąÜą░ą║ ąŠčüąĮąŠą▓ąĮąŠąĄ ą┐čĆą░ą▓ąĖą╗ąŠ, ąÆą░ą╝ ąĮčāąČąĮą░ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą▓ąŠą║čĆčāą│ ą┤ąŠčüčéčāą┐ą░ ą║ ą╗čÄą▒ąŠą╣ ąĘą░ą┐ąĖčüčŗą▓ą░ąĄą╝ąŠą╣ ąŠą▒čēąĄą╣ ą┐ąĄčĆąĄą╝ąĄąĮąĮąŠą╣ (writable shared field). ąöą░ąČąĄ ą▓ ą┐čĆąŠčüč鹥ą╣čłąĄą╝ čüą╗čāčćą░ąĄ - ąŠą┐ąĄčĆą░čåąĖčÅ ą┐čĆąĖčüą▓ą░ąĖą▓ą░ąĮąĖčÅ ąŠą┤ąĖąĮąŠčćąĮąŠą│ąŠ ą┐ąŠą╗čÅ - ąĮčāąČąĮąŠ čāčćąĖčéčŗą▓ą░čéčī čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖčÄ. ąÆ čüą╗ąĄą┤čāčÄčēąĄą╝ ą║ą╗ą░čüčüąĄ ąĮąĖ ą╝ąĄč鹊ą┤ Increment, ąĮąĖ ą╝ąĄč鹊ą┤ Assign ąĮąĄ ą▒čāą┤čāčé ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ąĖ:

class ThreadUnsafe

{

static int _x;

static void Increment() { _x++; }

static void Assign() { _x = 123; }

}

ąØąĖąČąĄ ą┐ąŠą║ą░ąĘą░ąĮčŗ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗąĄ ą▓ąĄčĆčüąĖąĖ ą┤ą╗čÅ Increment ąĖ Assign:

class ThreadSafe

{

static readonly object _locker = new object();

static int _x;

static void Increment() { lock (_locker) _x++; }

static void Assign() { lock (_locker) _x = 123; }

}

ąÆ ąĮąĄ ą▒ą╗ąŠą║ąĖčĆčāčÄčēąĄą╣ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ [12] ą╝čŗ čĆą░čüčüą╝ąŠčéčĆąĖą╝ čüą╗čāčćą░ąĖ, ą║ąŠą│ą┤ą░ ą▓ąŠąĘąĮąĖą║ą░ąĄčé ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéčī ą▓ čéą░ą║ąŠą╣ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ, ąĖ ą║ą░ą║ ą▒ą░čĆčīąĄčĆčŗ ąĮą░ ą┐ą░ą╝čÅčéąĖ ąĖ ą║ą╗ą░čüčü Interlocked [9] ą╝ąŠąČąĄčé ą┐čĆąĄą┤ąŠčüčéą░ą▓ąĖčéčī ą░ą╗čīč鹥čĆąĮą░čéąĖą▓čā ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ ą▓ čŹčéąĖčģ čüąĖčéčāą░čåąĖčÅčģ.

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĖ ą░č鹊ą╝ą░čĆąĮąŠčüčéčī. ąĢčüą╗ąĖ ą│čĆčāą┐ą┐ą░ ą┐ąĄčĆąĄą╝ąĄąĮąĮčŗčģ ą▓čüąĄą│ą┤ą░ čćąĖčéą░ąĄčéčüčÅ ąĖ ąĘą░ą┐ąĖčüčŗą▓ą░ąĄčéčüčÅ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ąŠą┤ąĮąŠą╣ ąĖ č鹊ą╣ ąČąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ lock, ą╝ąŠąČąĮąŠ čüą║ą░ąĘą░čéčī, čćč鹊 čŹčéąĖ ą┐ąĄčĆąĄą╝ąĄąĮąĮčŗąĄ čćąĖčéą░čÄčéčüčÅ ąĖ ąĘą░ą┐ąĖčüčŗą▓ą░čÄčéčüčÅ ą░č鹊ą╝ą░čĆąĮąŠ. ą¤čĆąĄą┤ą┐ąŠą╗ąŠąČąĖą╝, čćč鹊 ą┐ąŠą╗čÅ x ąĖ y ą▓čüąĄą│ą┤ą░ čćąĖčéą░čÄčéčüčÅ ąĖ ąĮą░ąĘąĮą░čćą░čÄčéčüčÅ ą▓ąĮčāčéčĆąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąĮą░ ąŠą▒čŖąĄą║č鹥 locker:

lock (locker) { if (x != 0) y /= x; }

ą£ąŠąČąĮąŠ čüą║ą░ąĘą░čéčī, čćč鹊 ą║ x ąĖ y ąŠčüčāčēąĄčüčéą▓ą╗čÅąĄčéčüčÅ ą░č鹊ą╝ą░čĆąĮčŗą╣ ą┤ąŠčüčéčāą┐, ą┐ąŠč鹊ą╝čā ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖąĄ ą║ąŠą┤ą░ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąĮąĄ ą╝ąŠąČąĄčé ą▒čŗčéčī čĆą░ąĘą┤ąĄą╗ąĄąĮąŠ ąĖą╗ąĖ ą▓čŗč鹥čüąĮąĄąĮąŠ ą┤ąĄą╣čüčéą▓ąĖčÅą╝ąĖ ą▓ ą┤čĆčāą│ąŠą╝ ą┐ąŠč鹊ą║ąĄ, ą▓ čĆąĄąĘčāą╗čīčéą░č鹥 č湥ą│ąŠ ą┐ąŠčüč鹊čĆąŠąĮąĮąĖąĄ ą┤ąĄą╣čüčéą▓ąĖčÅ ąĮąĖą║ą░ą║ ąĮąĄ ą╝ąŠą│čāčé ąŠčéą┤ąĄą╗čīąĮąŠ ą┐ąŠą▓ą╗ąĖčÅčéčī ąĮą░ x ąĖą╗ąĖ y čéą░ą║, čćč鹊 čĆąĄąĘčāą╗čīčéą░čé ą▓čŗčćąĖčüą╗ąĄąĮąĖą╣ čüčéą░ąĮąĄčé ąĮąĄą┤ąŠčüč鹊ą▓ąĄčĆąĮčŗą╝. ąÆčŗ ąĮąĖą║ąŠą│ą┤ą░ ąĮąĄ ą┐ąŠą╗čāčćąĖč鹥 ąŠčłąĖą▒ą║čā ą┤ąĄą╗ąĄąĮąĖčÅ ąĮą░ 0, čéą░ą║ ą║ą░ą║ ą┤ąŠčüčéčāą┐ ą║ x ąĖ y čĆąĄą░ą╗ąĖąĘąŠą▓ą░ąĮ ą▓ ąŠą┤ąĮąŠą╣ ąĖčüą║ą╗čÄčćąĖč鹥ą╗čīąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ (exclusive lock).

ąÉč鹊ą╝ą░čĆąĮąŠčüčéčī, ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗ąĄąĮąĮą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąŠą╣ lock, ąĮą░čĆčāčłą░ąĄčéčüčÅ, ąĄčüą╗ąĖ ą┐čĆąŠąĖąĘąŠą╣ą┤ąĄčé ą▓čŗą▒čĆą░čüčŗą▓ą░ąĮąĖąĄ ąĖčüą║ą╗čÄč湥ąĮąĖčÅ ą▓ąĮčāčéčĆąĖ ą▒ą╗ąŠą║ą░ lock. ąØą░ą┐čĆąĖą╝ąĄčĆ:

decimal _savingsBalance, _checkBalance;

void Transfer (decimal amount)

{

lock (_locker)

{

_savingsBalance += amount;

_checkBalance -= amount + GetBankFee();

}

}

ąĢčüą╗ąĖ ąĖčüą║ą╗čÄč湥ąĮąĖąĄ čüčĆą░ą▒ąŠčéą░ą╗ąŠ ą▓ čĆąĄąĘčāą╗čīčéą░č鹥 ą▓čŗąĘąŠą▓ą░ GetBankFee(), č鹊 ą▒ą░ąĮą║ ą┐ąŠč鹥čĆčÅą╗ ą▒čŗ ą┤ąĄąĮčīą│ąĖ. ąÆ čŹč鹊ą╝ čüą╗čāčćą░ąĄ ąĮą░ą╝ ąĮčāąČąĮąŠ ąĖąĘą▒ąĄą│ą░čéčī ą┐čĆąŠą▒ą╗ąĄą╝ ą┐čāč鹥ą╝ ą▓čŗąĘąŠą▓ą░ GetBankFee ąĘą░čĆą░ąĮąĄąĄ. ąĀąĄčłąĄąĮąĖąĄ ą┐ąŠą┤ąŠą▒ąĮąŠą╣ ą┐čĆąŠą▒ą╗ąĄą╝čŗ ą┤ą╗čÅ ą▒ąŠą╗ąĄąĄ čüą╗ąŠąČąĮčŗčģ čüą╗čāčćą░ąĄą▓ - čĆąĄą░ą╗ąĖąĘą░čåąĖčÅ ą╗ąŠą│ąĖą║ąĖ ąŠčéą║ą░čéą░ (rollback) čü ą┐ąŠą╝ąŠčēčīčÄ ą▒ą╗ąŠą║ą░ catch ąĖą╗ąĖ finally.

ą¤ąŠąĮčÅčéąĖąĄ ą░č鹊ą╝ą░čĆąĮąŠčüčéąĖ ąĖąĮčüčéčĆčāą║čåąĖąĖ čŹč鹊 ą┤čĆčāą│ą░čÅ, čģąŠčéčÅ ą░ąĮą░ą╗ąŠą│ąĖčćąĮą░čÅ ą║ąŠąĮčåąĄą┐čåąĖčÅ: ąĖąĮčüčéčĆčāą║čåąĖčÅ čüčćąĖčéą░ąĄčéčüčÅ ą░č鹊ą╝ą░čĆąĮąŠą╣, ąĄčüą╗ąĖ ąŠąĮą░ ąĮąĄą┤ąĄą╗ąĖą╝ąŠ (ąĄčæ ąĮąĖą║ą░ą║ ąĮąĄą╗čīąĘčÅ ą┐čĆąĄčĆą▓ą░čéčī, ą┐ąŠą┤ąĄą╗ąĖčéčī ąĮą░ čćą░čüčéąĖ) ą▓čŗą┐ąŠą╗ąĮčÅąĄčéčüčÅ ąĮą░ ąĮąĖąČąĄą╗ąĄąČą░čēąĄą╝ ą┐čĆąŠčåąĄčüčüąŠčĆąĄ, čüą╝. ąŠą┐ąĖčüą░ąĮąĖąĄ ąĮąĄ ą▒ą╗ąŠą║ąĖčĆčāčÄčēąĄą╣ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ [12].

ąÆą╗ąŠąČąĄąĮąĮčŗąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ą¤ąŠč鹊ą║ ą╝ąŠąČąĮąŠ ą┐ąŠą▓č鹊čĆąĮąŠ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčī ąĮą░ ąŠą┤ąĮąŠą╝ ąĖ č鹊ą╝ ąČąĄ ąŠą▒čŖąĄą║č鹥 ą▓ą╗ąŠąČąĄąĮąĮčŗą╝ (čĆąĄąĄąĮčéčĆą░ąĮčéąĮčŗą╝) čüą┐ąŠčüąŠą▒ąŠą╝:

lock (locker)

lock (locker)

lock (locker)

{

// ąóčāčé ą║ą░ą║ąĖąĄ-č鹊 ą┤ąĄą╣čüčéą▓ąĖčÅ...

}

ąĖą╗ąĖ čéą░ą║:

Monitor.Enter (locker); Monitor.Enter (locker); Monitor.Enter (locker);

// ąóčāčé ą║ą░ą║ąĖąĄ-č鹊 ą┤ąĄą╣čüčéą▓ąĖčÅ...

Monitor.Exit (locker); Monitor.Exit (locker); Monitor.Exit (locker);

ąÆ čŹčéąĖčģ čüčåąĄąĮą░čĆąĖčÅčģ ąŠą▒čŖąĄą║čé čĆą░ąĘą▒ą╗ąŠą║ąĖčĆčāąĄčéčüčÅ č鹊ą╗čīą║ąŠ ą║ąŠą│ą┤ą░ ą┐čĆąŠąĖąĘąŠą╣ą┤ąĄčé ą▓čŗčģąŠą┤ ąĖąĘ čüą░ą╝ąŠą│ąŠ ą▓ąĮąĄčłąĮąĄą│ąŠ ąŠą┐ąĄčĆą░č鹊čĆą░ lock, ąĖą╗ąĖ ą▒čāą┤ąĄčé ą▓čŗą┐ąŠą╗ąĮąĄąĮąŠ čüąŠąŠčéą▓ąĄčéčüčéą▓čāčÄčēąĄąĄ ą║ąŠą╗ąĖč湥čüčéą▓ąŠ ąŠą┐ąĄčĆą░č鹊čĆąŠą▓ Monitor.Exit.

ąÆą╗ąŠąČąĄąĮąĮą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐ąŠą╗ąĄąĘąĮą░, ą║ąŠą│ą┤ą░ ąŠą┤ąĖąĮ ą╝ąĄč鹊ą┤ ą▓čŗąĘčŗą▓ą░ąĄčé ą┤čĆčāą│ąŠą╣ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĖ lock:

static readonly object _locker = new object();

static void Main()

{

lock (_locker)

{

AnotherMethod();

// ąŻ ąĮą░čü ą▓čüąĄ ąĄčēąĄ ąĄčüčéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ - ą┐ąŠč鹊ą╝čā čćč鹊 ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ lock čĆąĄąĄąĮčéčĆą░ąĮčéąĮčŗ.

}

}

static void AnotherMethod()

{

lock (_locker) { Console.WriteLine ("ą£ąĄč鹊ą┤ AnotherMethod"); }

}

ą¤ąŠč鹊ą║ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮ č鹊ą╗čīą║ąŠ ąĮą░ ą┐ąĄčĆą▓ąŠą╝ (čüą░ą╝čŗą╝ ą▓ąĮąĄčłąĮąĖą╝) ąŠą┐ąĄčĆą░č鹊čĆąĄ lock.

ąōą╗čāčģąĖąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ (deadlock). ąōą╗čāčģą░čÅ, ąĖą╗ąĖ "ą╝ąĄčĆčéą▓ą░čÅ" ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ deadlock ą┐čĆąŠąĖąĘąŠą╣ą┤ąĄčé, ą║ąŠą│ą┤ą░ ą┤ą▓ą░ ą┐ąŠč鹊ą║ą░ ą▓ąĘą░ąĖą╝ąĮąŠ ąČą┤čāčé ąŠčüą▓ąŠą▒ąŠąČą┤ąĄąĮąĖčÅ čĆąĄčüčāčĆčüą░, ąĘą░čģą▓ą░č湥ąĮąĮąŠą│ąŠ ą┤čĆčāą│ąĖą╝ ą┐ąŠč鹊ą║ąŠą╝, ą▓ čĆąĄąĘčāą╗čīčéą░č鹥 ąĮąĖč湥ą│ąŠ ąĮąĄ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé. ąØąĖąČąĄ ą┐čĆąĖą▓ąĄą┤ąĄąĮą░ čüą░ą╝ą░čÅ ą┐čĆąŠčüčéą░čÅ ąĖą╗ą╗čÄčüčéčĆą░čåąĖčÅ čŹč鹊ą╣ čüąĖčéčāą░čåąĖąĖ čü ą┤ą▓čāą╝čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ą╝ąĖ lock:

object locker1 = new object();

object locker2 = new object();

new Thread (() => {

lock (locker1)

{

Thread.Sleep (1000);

lock (locker2); // Deadlock

}

}).Start();

lock (locker2)

{

Thread.Sleep (1000);

lock (locker1); // Deadlock

}

ą¤čĆąŠą│čĆą░ą╝ą╝ąĖčüčé ą╝ąŠąČąĄčé "ąĮą░ą║ąŠą╗ą▒ą░čüąĖčéčī" ąĖ ą▒ąŠą╗ąĄąĄ čüą╗ąŠąČąĮčŗąĄ čåąĄą┐ąŠčćą║ąĖ ą│ą╗čāčģąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ čü čāčćą░čüčéąĖąĄą╝ čéčĆąĄčģ ąĖ ą▒ąŠą╗čīčłąĄą│ąŠ ą║ąŠą╗ąĖč湥čüčéą▓ą░ ą┐ąŠč鹊ą║ąŠą▓.

ąæąĖą▒ą╗ąĖąŠč鹥ą║ą░ CLR ą▓ čüčéą░ąĮą┤ą░čĆčéąĮąŠą╝ ąŠą║čĆčāąČąĄąĮąĖąĖ čģąŠčüčéą░ ąĮąĄ čĆą░ą▒ąŠčéą░ąĄčé ąĮą░ą┐ąŠą┤ąŠą▒ąĖąĄ čüąĄčĆą▓ąĄčĆą░ SQL Server, ąĮąĄ ąŠą┐čĆąĄą┤ąĄą╗čÅąĄčé ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąĖ ą│ą╗čāčģąĖąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąĖ ąĮąĄ ą┐čĆąĄą┤čüčéą░ą▓ą╗čÅąĄčé ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąŠąĄ čüčĆąĄą┤čüčéą▓ąŠ ąĖčüą┐čĆą░ą▓ą╗ąĄąĮąĖčÅ čéą░ą║ąĖčģ ą▒ą╗ąŠą║ąĖčĆąŠą▓ąŠą║ ą┐čāč鹥ą╝ ąŠčüčéą░ąĮąŠą▓ą░ ąŠą┤ąĮąŠą│ąŠ ąĖąĘ čāčćą░čüčéąĮąĖą║ąŠą▓ ą│ą╗čāčģąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąōą╗čāčģą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐ąŠč鹊ą║ąŠą▓ ąĘą░čüčéą░ą▓ą╗čÅąĄčé ąĖčģ ąĮą░ ąĮąĄąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮąŠąĄ ą▓čĆąĄą╝čÅ ą┐čĆąĄčĆą▓ą░čéčī čüą▓ąŠąĄ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖąĄ, ąĄčüą╗ąĖ ą║ąŠąĮąĄčćąĮąŠ ąÆčŗ ąĮąĄ ą┐čĆąĄą┤čāčüą╝ąŠčéčĆąĄą╗ąĖ čéą░ą╣ą╝ą░čāčé ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąÆ ąĖč鹥čĆą░čåąĖąĖ čģąŠčüčéą░ SQL CLR, ąŠą┤ąĮą░ą║ąŠ, deadlock-ąĖ ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąĖ ąŠą┐čĆąĄą┤ąĄą╗čÅčÄčéčüčÅ ąĖ ą▓čŗą▒čĆą░čüčŗą▓ą░ąĄčéčüčÅ (ą┐ąĄčĆąĄčģą▓ą░čéčŗą▓ą░ąĄą╝ąŠąĄ catch) ąĖčüą║ą╗čÄč湥ąĮąĖąĄ ą▓ ąŠą┤ąĮąŠą╝ ąĖąĘ ą┐ąŠč鹊ą║ąŠą▓, čāčćą░čüčéą▓čāčÄčēąĖčģ ą▓ ą│ą╗čāčģąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ.

Deadlock ąŠą┤ąĮą░ ąĖąĘ čüą░ą╝čŗčģ ąČąĄčüčéą║ąĖčģ ą┐čĆąŠą▒ą╗ąĄą╝ ą▓ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ, ąŠčüąŠą▒ąĄąĮąĮąŠ ą║ąŠą│ą┤ą░ ąĄčüčéčī ą╝ąĮąŠąČąĄčüčéą▓ąŠ ą▓ąĘą░ąĖą╝ąŠčüą▓čÅąĘą░ąĮąĮčŗčģ ąŠą▒čŖąĄą║č鹊ą▓. ążčāąĮą┤ą░ą╝ąĄąĮčéą░ą╗čīąĮą░čÅ čüą╗ąŠąČąĮąŠčüčéčī čüąŠčüč鹊ąĖčé ą▓ č鹊ą╝, čćč鹊 ąÆčŗ ąĮąĄ ą╝ąŠąČąĄč鹥 ą▒čŗčéčī čāą▓ąĄčĆąĄąĮčŗ, čćč鹊 ąĘą░ą▓ąĄčĆčłąĖą╗ą░čüčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą║ąŠą┤ą░, ą║ąŠč鹊čĆčŗą╣ čüą░ą╝ ą▓čŗąĘą▓ą░ą╗ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā.

ąØą░ą┐čĆąĖą╝ąĄčĆ, ąÆčŗ ą╝ąŠąČąĄč鹥 ąĮąĄčćą░čÅąĮąĮąŠ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčī private-ą┐ąŠą╗ąĄ ą▓ čüą▓ąŠąĄą╝ ą║ą╗ą░čüčüąĄ x, ąĮąĄ ąĘąĮą░čÅ, čćč鹊 ąÆą░čł ą▓čŗąĘčŗą▓ą░čÄčēąĖą╣ ą║ąŠą┤ (ąĖą╗ąĖ ą║ąŠą┤, ą▓čŗąĘą▓ą░ą▓čłąĖą╣ ą▓čŗąĘčŗą▓ą░čÄčēąĄą│ąŠ) čāąČąĄ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮ ąĮą░ ą┐ąŠą╗ąĄ b ą▓ ą║ą╗ą░čüčüąĄ y. ą£ąĄąČą┤čā č鹥ą╝ ą┤čĆčāą│ąŠą╣ ą┐ąŠč鹊ą║ ą┤ąĄą╗ą░ąĄčé ąŠą▒čĆą░čéąĮąŠąĄ, čüąŠąĘą┤ą░ą▓ą░čÅ deadlock. ąśčĆąŠąĮąĖčÅ čéčāčé ą▓ č鹊ą╝, čćč鹊 ą┐čĆąŠą▒ą╗ąĄą╝ą░ čāčüąĖą╗ąĖą▓ą░ąĄčéčüčÅ "čģąŠčĆąŠčłąĖą╝ąĖ" (ąĖąĘąĮą░čćą░ą╗čīąĮąŠ ą┐ąŠą┤čĆą░ąĘčāą╝ąĄą▓ą░ąĄą╝čŗą╝ąĖ) čłą░ą▒ą╗ąŠąĮą░ą╝ąĖ ąŠą▒čŖąĄą║čéąĮąŠ-ąŠčĆąĖąĄąĮčéąĖčĆąŠą▓ą░ąĮąĮąŠą│ąŠ čüčéąĖą╗čÅ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčĆąŠą▓ą░ąĮąĖčÅ, ą┐ąŠč鹊ą╝čā čćč鹊 ą┐čĆąĖąĮčåąĖą┐ "čüą║čĆčŗą▓ą░ą╣ ą┤ąĄčéą░ą╗ąĖ ą║ąŠą┤ą░ ą▓ąĮčāčéčĆąĖ ąŠą▒čŖąĄą║č鹊ą▓" čüąŠąĘą┤ą░ąĄčé čåąĄą┐ąŠčćą║ąĖ ą▓ąĘą░ąĖą╝ąŠčüą▓čÅąĘąĄą╣, ą║ąŠč鹊čĆčŗąĄ ąĮąĄ ąŠč湥ą▓ąĖą┤ąĮčŗ ą┤ą╗čÅ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčüčéą░, ą┐ąŠą║ą░ ą║ąŠą┤ ąĮąĄ ąĮą░čćąĮąĄčé ą▓čŗą┐ąŠą╗ąĮčÅčéčīčüčÅ ą▓ čĆąĄą░ą╗čīąĮąŠą╝ ą▓čĆąĄą╝ąĄąĮąĖ.

ą¤ąŠą┐čāą╗čÅčĆąĮčŗąĄ čüąŠą▓ąĄčéčŗ ąĖąĘą▒ąĄąČą░čéčī ą╝ąĄčĆčéą▓čŗčģ ą▒ą╗ąŠą║ąĖčĆąŠą▓ąŠą║ čéąĖą┐ą░ "ą▒ą╗ąŠą║ąĖčĆčāą╣č鹥 ąŠą▒čŖąĄą║čéčŗ ą▓ ą┐čĆą░ą▓ąĖą╗čīąĮąŠą╝ ą┐ąŠčĆčÅą┤ą║ąĄ" čéčÅąČąĄą╗ąŠ ą┐čĆąĖą╝ąĄąĮąĖčéčī ąĮą░ ą┐čĆą░ą║čéąĖą║ąĄ, čģąŠčéčÅ ąŠąĮąĖ ą╝ąŠą│čāčé ą┐ąŠą╝ąŠčćčī ą▓ ą┐čĆąŠčüčéčŗčģ čüą╗čāčćą░čÅčģ, ą┐čĆąĖą╝ąĄčĆčŗ ą║ąŠč鹊čĆčŗčģ ą╝čŗ ąŠą┐ąĖčüčŗą▓ą░ą╗ąĖ. ąøčāčćčłą░čÅ čüčéčĆą░č鹥ą│ąĖčÅ - ąŠčüąŠą▒ąĄąĮąĮąŠ ą▓ąĮąĖą╝ą░č鹥ą╗čīąĮąŠ ą┐čĆąĖą╝ąĄąĮčÅčéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▓ąŠą║čĆčāą│ ą▓čŗąĘąŠą▓ą░ ą╝ąĄč鹊ą┤ąŠą▓ ą▓ ąŠą▒čŖąĄą║čéą░čģ, ą║ąŠč鹊čĆčŗąĄ ą╝ąŠą│čāčé čüčüčŗą╗ą░čéčīčüčÅ ąŠą▒čĆą░čéąĮąŠ ąĮą░ ąÆą░čł čüąŠą▒čüčéą▓ąĄąĮąĮčŗą╣ ąŠą▒čŖąĄą║čé. ąóčēą░č鹥ą╗čīąĮąŠ ą▓ąĘą▓ąĄčüčīč鹥 ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▓ąŠą║čĆčāą│ ą▓čŗąĘąŠą▓ą░ ą╝ąĄč鹊ą┤ąŠą▓ ą▓ ą┤čĆčāą│ąĖčģ ą║ą╗ą░čüčüą░čģ, čćą░čüč鹊 čŹč鹊 ą┤ąĄą╗ą░ąĄčéčüčÅ, ąŠą┤ąĮą░ą║ąŠ ąĖąĮąŠą│ą┤ą░ - čćč鹊 ą╝čŗ čĆą░čüčüą╝ąŠčéčĆąĖą╝ ą┐ąŠąĘąČąĄ - ąĄčüčéčī ąĖ ą┤čĆčāą│ąĖąĄ ąŠą┐čåąĖąĖ čĆąĄą░ą╗ąĖąĘą░čåąĖąĖ. ąæąŠą╗čīčłąĄ ą┐ąŠą╗ą░ą│ą░čÅčüčī ąĮą░ ą┤ąĄą║ą╗ą░čĆą░čéąĖą▓ąĮąŠčüčéčī [13] ąĖ ą┐ą░čĆą░ą╗ą╗ąĄą╗ąĖąĘą╝ ąŠą▒čĆą░ą▒ąŠčéą║ąĖ ą┤ą░ąĮąĮčŗčģ [14], ąĮąĄ ąĖąĘą╝ąĄąĮčÅąĄą╝čŗąĄ čéąĖą┐čŗ (immutable types, čüą╝. ą┤ą░ą╗ąĄąĄ) ąĖ ąĮąĄ ą▒ą╗ąŠą║ąĖčĆčāčÄčēąĖąĄ ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ čüąĖąĮčģčĆąŠąĮąĖąĘą░čåąĖąĖ [12], ą╝ąŠąČąĮąŠ čüąĮąĖąĘąĖčéčī ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéčī ą▓ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░čģ.

ąĢčüčéčī ąĄčēąĄ ąŠą┤ąĖąĮ čüą┐ąŠčüąŠą▒ ą┐ąŠčćčāą▓čüčéą▓ąŠą▓ą░čéčī ą┐čĆąŠą▒ą╗ąĄą╝čā: ą║ąŠą│ą┤ą░ ąÆčŗ ą▓čŗąĘčŗą▓ą░ąĄč鹥 ą┤čĆčāą│ąŠą╣ ą║ąŠą┤, čüąŠą┤ąĄčƹȹ░čēąĖą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā, ą┐čĆąŠąĖčüčģąŠą┤ąĖčé čüą║čĆčŗčéą░čÅ ąĖąĮą║ą░ą┐čüčāą╗čÅčåąĖčÅ čŹč鹊ą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąŁč鹊 ąĮąĄ ą┐čĆąĖą▓ąĄą┤ąĄčé ą║ ąŠčłąĖą▒ą║ąĄ ą▓ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ąĄ CLR ąĖą╗ąĖ .NET Framework, ąĮąŠ čÅą▓ą╗čÅąĄčéčüčÅ čäčāąĮą┤ą░ą╝ąĄąĮčéą░ą╗čīąĮčŗą╝ ąŠą│čĆą░ąĮąĖč湥ąĮąĖąĄą╝ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▓ čåąĄą╗ąŠą╝. ą¤čĆąŠą▒ą╗ąĄą╝ą░ą╝ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą┐ąŠčüą▓čÅčēąĄąĮčŗ ą╝ąĮąŠą│ąĖąĄ ąĖčüčüą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīčüą║ąĖąĄ ą┐čĆąŠąĄą║čéčŗ, ą▓ą║ą╗čÄčćą░čÅ Software Transactional Memory.

ąöčĆčāą│ąŠą╣ čüčåąĄąĮą░čĆąĖą╣ ą╝ąĄčĆčéą▓ąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▓ąŠąĘąĮąĖą║ąĮąĄčé, ą║ąŠą│ą┤ą░ ą▓čŗąĘčŗą▓ą░ąĄčéčüčÅ Dispatcher.Invoke (ą▓ ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĖ WPF) ąĖą╗ąĖ Control.Invoke (ą▓ ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĖ Windows Forms) ą▓ąŠ ą▓čĆąĄą╝čÅ ą░ą║čéąĖą▓ąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąĢčüą╗ąĖ čüą╗čāčćąĖą╗ąŠčüčī čéą░ą║, čćč鹊 UI ąĘą░ą┐čāčüčéąĖą╗ ą┤čĆčāą│ąŠą╣ ą╝ąĄč鹊ą┤, ą║ąŠč鹊čĆčŗą╣ ąČą┤ąĄčé ąĮą░ č鹊ą╣ ąČąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ, č鹊 ą┐čĆąŠąĖąĘąŠą╣ą┤ąĄčé deadlock. ąŁč鹊 čćą░čüč鹊 ą╝ąŠąČąĮąŠ ąĖčüą┐čĆą░ą▓ąĖčéčī ą┐čĆąŠčüčéčŗą╝ ą▓čŗąĘąŠą▓ąŠą╝ BeginInvoke ą▓ą╝ąĄčüč鹊 Invoke. ąÉą╗čīč鹥čĆąĮą░čéąĖą▓ąĮąŠ ąÆčŗ ą╝ąŠąČąĄč鹥 ąŠčüą▓ąŠą▒ąŠą┤ąĖčéčī čüą▓ąŠčÄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą┐ąĄčĆąĄą┤ ą▓čŗąĘąŠą▓ąŠą╝ Invoke, čģąŠčéčÅ čŹč鹊 ąĮąĄ ą▒čāą┤ąĄčé čĆą░ą▒ąŠčéą░čéčī, ąĄčüą╗ąĖ ą▓čŗąĘčŗą▓ą░čÄčēąĖą╣ ą║ąŠą┤ ąĘą░ą┐čāčüčéąĖą╗ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā. Invoke ąĖ BeginInvoke ą▒čāą┤čāčé čĆą░čüčüą╝ą░čéčĆąĖą▓ą░čéčīčüčÅ ą┤ą░ą╗ąĄąĄ ą▓ čüąĄą║čåąĖąĖ "Rich Client Applications ąĖ Thread Affinity".

ą¤čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī. ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ čĆą░ą▒ąŠčéą░ąĄčé ą▒čŗčüčéčĆąŠ: ąÆčŗ ą╝ąŠąČąĄč鹥 ąŠąČąĖą┤ą░čéčī, čćč鹊 ąĘą░čģą▓ą░čé ąĖ ąŠčüą▓ąŠą▒ąŠąČą┤ąĄąĮąĖąĄ ą║čĆąĖčéąĖč湥čüą║ąŠą╣ čüąĄą║čåąĖąĖ lock ąĘą░ą╣ą╝ąĄčé ą╝ąĄąĮčīčłąĄ 20 ąĮą░ąĮąŠčüąĄą║čāąĮą┤ ąĮą░ ą┐ąŠą║ąŠą╗ąĄąĮąĖąĖ ą║ąŠą╝ą┐čīčÄč鹥čĆąŠą▓ 2010 ą│ąŠą┤ą░, ąĄčüą╗ąĖ ą║ čŹč鹊ą╣ čüąĄą║čåąĖąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąĮąĄ ą▒čŗą╗ąŠ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░. ąĢčüą╗ąĖ ąČąĄ ą▒čŗą╗ čüą╗čāčćą░ą╣ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░, č鹊 ą┐ąŠčüą╗ąĄą┤čāčÄčēąĖąĄ ąĘą░čéčĆą░čéčŗ ąĮą░ ą┐ąĄčĆąĄą║ą╗čÄč湥ąĮąĖąĄ ą║ąŠąĮč鹥ą║čüčéą░ ą▓ą▓ąĄą┤čāčé čéčĆą░čéčā ą┐čĆąŠčåąĄčüčüąŠčĆąĮąŠą│ąŠ ą▓čĆąĄą╝ąĄąĮąĖ ą┐čĆąĖą╝ąĄčĆąĮąŠ ąŠą║ąŠą╗ąŠ ą╝ąĖą║čĆąŠčüąĄą║čāąĮą┤čŗ, čģąŠčéčÅ čŹč鹊čé ąĖąĮč鹥čĆą▓ą░ą╗ ą╝ąŠąČąĄčé ą▒čŗčéčī ą▒ąŠą╗čīčłąĄ, ąĄčüą╗ąĖ čāč湥čüčéčī ą▓čĆąĄą╝čÅ, ąĘą░ ą║ąŠč鹊čĆąŠąĄ čüą╝ąĄąĮą░ čüąŠčüč鹊čÅąĮąĖčÅ ą┐ąŠč鹊ą║ą░ ą▒čāą┤ąĄčé čĆąĄą░ą╗čīąĮąŠ ąŠą▒čĆą░ą▒ąŠčéą░ąĮą░ ą┐ą╗ą░ąĮąĖčĆąŠą▓čēąĖą║ąŠą╝. ąÆčŗ ą╝ąŠąČąĄč鹥 ąĖąĘą▒ąĄąČą░čéčī čéčĆą░čé ąĮą░ ą┐ąĄčĆąĄą║ą╗čÄč湥ąĮąĖąĄ ą║ąŠąĮč鹥ą║čüčéą░ čü ą┐ąŠą╝ąŠčēčīčÄ ą║ą╗ą░čüčüą░ SpinLock [3] - ąĄčüą╗ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ąŠč湥ąĮčī ą║ąŠčĆąŠčéą║ąŠ.

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą╝ąŠąČąĄčé čüąĮąĖąĘąĖčéčī ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠčüčéčī, ąĄčüą╗ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ čāą┤ąĄčƹȹĖą▓ą░ąĄčéčüčÅ čüą╗ąĖčłą║ąŠą╝ ą┤ąŠą╗ą│ąŠ. ąŁč鹊 čéą░ą║ąČąĄ ą╝ąŠąČąĄčé ą┐ąŠą▓čŗčüąĖčéčī čłą░ąĮčüčŗ ą▓ąŠąĘąĮąĖą║ąĮąŠą▓ąĄąĮąĖčÅ deadlock.

Mutex. ą£čīčÄč鹥ą║čü ą┐ąŠą┤ąŠą▒ąĄąĮ C# lock, ąĮąŠ ąŠąĮ ą╝ąŠąČąĄčé čĆą░ą▒ąŠčéą░čéčī ą╝ąĄąČą┤čā ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ąĖ ą┐čĆąŠčåąĄčüčüą░ą╝ąĖ. ąöčĆčāą│ąĖą╝ąĖ čüą╗ąŠą▓ą░ą╝ąĖ, Mutex ą╝ąŠąČąĄčé ą┤ąĄą╣čüčéą▓ąŠą▓ą░čéčī ą║ą░ą║ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ą║ąŠą╝ą┐čīčÄč鹥čĆą░, čéą░ą║ ąĖ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ.

ąŚą░čģą▓ą░čé ąĖ ąŠčüą▓ąŠą▒ąŠąČą┤ąĄąĮąĖąĄ Mutex ą▓ čüą╗čāčćą░ąĄ ąŠčéčüčāčéčüčéą▓ąĖčÅ ą║ąŠąĮą║čāčĆąĄąĮčéąĮčŗčģ ą┐ąŠą┐čŗč鹊ą║ ą┤ąŠčüčéčāą┐ą░ ąĘą░ąĮąĖą╝ą░ąĄčé ąĮąĄčüą║ąŠą╗čīą║ąŠ ą╝ąĖą║čĆąŠčüąĄą║čāąĮą┤ - ą┐čĆąĖą╝ąĄčĆąĮąŠ ą▓ 50 čĆą░ąĘ ą╝ąĄą┤ą╗ąĄąĮąĮąĄąĄ, č湥ą╝ čĆą░ą▒ąŠčéą░ąĄčé ą║čĆąĖčéąĖč湥čüą║ą░čÅ čüąĄą║čåąĖčÅ lock.

ąĪ ą║ą╗ą░čüčüąŠą╝ Mutex ą╝ąŠąČąĮąŠ ą▓čŗąĘą▓ą░čéčī ą╝ąĄč鹊ą┤ WaitOne ą┤ą╗čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąĖ ReleaseMutex ą┤ą╗čÅ čĆą░ąĘą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąŚą░ą║čĆčŗčéąĖąĄ ąĖą╗ąĖ ąĖąĘą▒ą░ą▓ą╗ąĄąĮąĖąĄ ąŠčé (disposing) Mutex ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąĖ ąŠčüą▓ąŠą▒ąŠą┤ąĖčé ąĄą│ąŠ. ąóą░ą║ ąČąĄ, ą║ą░ą║ ąĖ čü ąŠą┐ąĄčĆą░č鹊čĆąŠą╝ lock, Mutex ą╝ąŠąČąĄčé ą▒čŗčéčī ąŠčüą▓ąŠą▒ąŠąČą┤ąĄąĮ č鹊ą╗čīą║ąŠ ą▓ č鹊ą╝ ą┐ąŠč鹊ą║ąĄ, ą║ąŠč鹊čĆčŗą╣ ą┐ąŠą╗čāčćąĖą╗ čŹč鹊čé Mutex.

ą×ą▒čēąĄąĄ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą┤ą╗čÅ ą╝ąĄąČą┐čĆąŠčåąĄčüčüąĮąŠą│ąŠ Mutex ą┐čĆąĖą╝ąĄąĮčÅąĄčéčüčÅ ą┤ą╗čÅ ą│ą░čĆą░ąĮčéąĖąĖ, čćč鹊 č鹊ą╗čīą║ąŠ ąŠą┤ąĖąĮ 菹║ąĘąĄą╝ą┐ą╗čÅčĆ ą┐čĆąŠą│čĆą░ą╝ą╝čŗ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĘą░ą┐čāčēąĄąĮ ą▓ ą╗čÄą▒ąŠą╣ ą╝ąŠą╝ąĄąĮčé ą▓čĆąĄą╝ąĄąĮąĖ. ąÆąŠčé ą║ą░ą║ čŹč鹊 ą┤ąĄą╗ą░ąĄčéčüčÅ:

class OneAtATimePlease

{

static void Main()

{

// ą¤čĆąĖčüą▓ąŠąĄąĮąĖąĄ ą╝čīčÄč鹥ą║čüčā ąĖą╝ąĄąĮąĖ ą┤ąĄą╗ą░ąĄčé ąĄą│ąŠ ą┤ąŠčüčéčāą┐ąĮčŗą╝ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ

// ą▓čüąĄą│ąŠ ą║ąŠą╝ą┐čīčÄč鹥čĆą░. ąśčüą┐ąŠą╗čīąĘčāą╣č鹥 ąĖą╝čÅ, ą║ąŠč鹊čĆąŠąĄ čāąĮąĖą║ą░ą╗čīąĮąŠ ą┤ą╗čÅ

// ąÆą░čłąĄą╣ ą║ąŠą╝ą┐ą░ąĮąĖąĖ, ąĮą░ą┐čĆąĖą╝ąĄčĆ ąĖą╝čÅ, ą▓ą║ą╗čÄčćą░čÄčēąĄąĄ URL čüą░ą╣čéą░.

using (var mutex = new Mutex (false, "oreilly.com OneAtATimeDemo"))

{

// ą×ąČąĖą┤ą░ąĮąĖąĄ ą▓ č鹥č湥ąĮąĖąĄ ąĮąĄčüą║ąŠą╗čīą║ąĖčģ čüąĄą║čāąĮą┤, ąĄčüą╗ąĖ ą┐čĆąŠąĖąĘąŠčłą╗ą░ ą┐ąŠą┐čŗčéą║ą░

// ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ąĘą░ą┐čāčüą║ą░ ą▓ čüą╗čāčćą░ąĄ, ą║ąŠą│ą┤ą░ ą┤čĆčāą│ąŠą╣ 菹║ąĘąĄą╝ą┐ą╗čÅčĆ

// ą┐čĆąŠą│čĆą░ą╝ą╝čŗ ą▓čüąĄ ąĄčēąĄ ąĮą░čģąŠą┤ąĖčéčüčÅ ą▓ ą┐čĆąŠčåąĄčüčüąĄ ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ.

if (!mutex.WaitOne (TimeSpan.FromSeconds (3), false))

{

Console.WriteLine ("Another app instance is running. Bye!");

return;

}

RunProgram();

}

}

static void RunProgram()

{

Console.WriteLine ("ą¤čĆąŠą│čĆą░ą╝ą╝ą░ čāąČąĄ čĆą░ą▒ąŠčéą░ąĄčé. ąØą░ąČą╝ąĖč鹥 Enter ą┤ą╗čÅ ą▓čŗčģąŠą┤ą░");

Console.ReadLine();

}

}

ąĢčüą╗ąĖ ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĄ ąĘą░ą┐čāčēąĄąĮąŠ ą┐ąŠ čāą┐čĆą░ą▓ą╗ąĄąĮąĖąĄą╝ čüą╗čāąČą▒čŗ č鹥čĆą╝ąĖąĮą░ą╗ą░ (Terminal Services) ąŠčé ąĖą╝ąĄąĮąĖ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮąŠą│ąŠ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ, č鹊 ą▓ąĖą┤ąĖą╝čŗą╣ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ą▓čüąĄą│ąŠ ą║ąŠą╝ą┐čīčÄč鹥čĆą░ Mutex ąŠą▒čŗčćąĮąŠ ą▓ąĖą┤ąĄąĮ č鹊ą╗čīą║ąŠ ą┤ą╗čÅ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ąŠą┤ąĮąŠą╣ č鹥čĆą╝ąĖąĮą░ą╗čīąĮąŠą╣ čüąĄčüčüąĖąĖ (čé. ąĄ. č鹊ą╗čīą║ąŠ ą▓ čüąĄčüčüąĖąĖ čŹč鹊ą│ąŠ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ č鹥čĆą╝ąĖąĮą░ą╗ą░). ą¦č鹊ą▒čŗ čüą┤ąĄą╗ą░čéčī ą╝čīčÄč鹥ą║čü ą▓ąĖą┤ąĖą╝čŗą╝ ą┤ą╗čÅ ą▓čüąĄčģ čüąĄčüčüąĖą╣ č鹥čĆą╝ąĖąĮą░ą╗ą░, čüąĮą░ą▒ą┤ąĖč鹥 ąĄą│ąŠ ąĖą╝čÅ ą┐čĆąĄčäąĖą║čüąŠą╝ Global\.

ąĪąĄą╝ą░č乊čĆ. ąŁč鹊 ąŠą▒čŖąĄą║čé, ą║ąŠč鹊čĆčŗą╣ ą┐ąŠčģąŠąČ ąĮą░ ąĮąŠčćąĮąŠą╣ ą║ą╗čāą▒: čā ąĮąĄą│ąŠ ąĄčüčéčī ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮą░čÅ ąĄą╝ą║ąŠčüčéčī, ą┐čĆąĖąĮčāą┤ąĖč鹥ą╗čīąĮąŠ ąŠčéčüą╗ąĄąČąĖą▓ą░ąĄą╝ą░čÅ ą▓čŗčłąĖą▒ą░ą╗ąŠą╣ ąĮą░ ą▓čģąŠą┤ąĄ. ąæčāą┤čāčćąĖ ąĘą░ą┐ąŠą╗ąĮąĄąĮąĮčŗą╝, ą║ą╗čāą▒ ą▒ąŠą╗čīčłąĄ ąĮąĄ ą╝ąŠąČąĄčé ą┐čĆąĖąĮčÅčéčī ą┐ąŠčüąĄčéąĖč鹥ą╗ąĄą╣, čćč鹊 čüąŠąĘą┤ą░ąĄčé ąŠč湥čĆąĄą┤čī čüąĮą░čĆčāąČąĖ. ąóąŠą│ą┤ą░ ą┤ą╗čÅ ą║ą░ąČą┤ąŠą╣ čāčģąŠą┤čÅčēąĄą╣ ą┐ąĄčĆčüąŠąĮčŗ ąĘą░ą╣ą┤ąĄčé ąŠą┤ąĮą░ ą┐ąĄčĆčüąŠąĮą░ ąĖąĘ ą│ąŠą╗ąŠą▓čŗ ąŠč湥čĆąĄą┤ąĖ. ąÜąŠąĮčüčéčĆčāą║č鹊čĆ čüąĄą╝ą░č乊čĆą░ čéčĆąĄą▒čāąĄčé ą╝ąĖąĮąĖą╝čāą╝ 2 ą░čĆą│čāą╝ąĄąĮč鹊ą▓: ą║ąŠą╗ąĖč湥čüčéą▓ąŠ ą┤ąŠčüčéčāą┐ąĮčŗčģ ą▓ ąĮą░čüč鹊čÅčēąĖą╣ ą╝ąŠą╝ąĄąĮčé ą╝ąĄčüčé ąĖ ąŠą▒čēą░čÅ ąĄą╝ą║ąŠčüčéčī čüąĄą╝ą░č乊čĆą░.

ąĪąĄą╝ą░č乊čĆ čü ąĄą╝ą║ąŠčüčéčīčÄ, čĆą░ą▓ąĮąŠą╣ 1, čĆą░ą▒ąŠčéą░ąĄčé ą┐ąŠą┤ąŠą▒ąĮąŠ Mutex ąĖą╗ąĖ lock, ąĘą░ ąĖčüą║ą╗čÄč湥ąĮąĖąĄą╝ č鹊ą│ąŠ, čćč鹊 čā čüąĄą╝ą░č乊čĆą░ ąĮąĄčé "ą▓ą╗ą░ą┤ąĄą╗čīčåą░" - ąŠąĮ ąĮąĄ ąŠą▒čĆą░čēą░ąĄčé ą▓ąĮąĖą╝ą░ąĮąĖčÅ ąĮą░ ą┐ąŠč鹊ą║ąĖ (thread-agnostic). ąøčÄą▒ąŠą╣ ą┐ąŠč鹊ą║ ą╝ąŠąČąĄčé ą▓čŗąĘą▓ą░čéčī Release ąĮą░ Semaphore, ą▓ č鹊 ą▓čĆąĄą╝čÅ ą║ą░ą║ čü Mutex ąĖą╗ąĖ lock, č鹊ą╗čīą║ąŠ ąŠą┤ąĖąĮ ą┐ąŠč鹊ą║ ą╝ąŠąČąĄčé ą┐ąŠą╗čāčćąĖčéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ąĖ ąŠčüą▓ąŠą▒ąŠą┤ąĖčéčī ąĄčæ.

ąĢčüčéčī ą┤ą▓ąĄ ą┐ąŠą┤ąŠą▒ąĮčŗčģ ą┐ąŠ čäčāąĮą║čåąĖąŠąĮą░ą╗čā ą▓ąĄčĆčüąĖąĖ čŹč鹊ą│ąŠ ą║ą╗ą░čüčüą░: Semaphore ąĖ SemaphoreSlim. ą¤ąŠčüą╗ąĄą┤ąĮąĖą╣ ą▒čŗą╗ ą┐čĆąĄą┤čüčéą░ą▓ą╗ąĄąĮ ą▓ Framework 4.0, ąĖ ąŠąĮ ąŠą┐čéąĖą╝ąĖąĘąĖčĆąŠą▓ą░ąĮ ą┤ą╗čÅ čāą┤ąŠą▓ą╗ąĄčéą▓ąŠčĆąĄąĮąĖčÅ ą┐ąŠą▓čŗčłąĄąĮąĮčŗčģ čéčĆąĄą▒ąŠą▓ą░ąĮąĖą╣ ąĮą░ ą╝ą░ą╗čŗąĄ ąĘą░ą┤ąĄčƹȹ║ąĖ ą▓ ą┐ą░čĆą░ą╗ą╗ąĄą╗čīąĮąŠą╝ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčĆąŠą▓ą░ąĮąĖąĖ [14]. ąóą░ą║ąČąĄ ąŠąĮ ą┐ąŠą╗ąĄąĘąĄąĮ ą▓ čéčĆą░ą┤ąĖčåąĖąŠąĮąĮąŠą╣ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ, ą┐ąŠč鹊ą╝čā čćč鹊 ą┐ąŠąĘą▓ąŠą╗čÅąĄčé čāą║ą░ąĘą░čéčī ą▒ąĖą╗ąĄčé ąŠčéą╝ąĄąĮčŗ (cancellation token [15]) ą┤ą╗čÅ ąŠąČąĖą┤ą░ąĮąĖčÅ. ą×ą┤ąĮą░ą║ąŠ čŹč鹊 ąĮąĄą╗čīąĘčÅ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ą┤ą╗čÅ čüąĖą│ąĮą░ą╗ąĖąĘą░čåąĖąĖ ą╝ąĄąČą┤čā ą┐čĆąŠčåąĄčüčüą░ą╝ąĖ.

Semaphore ą▓ą▓ąŠą┤ąĖčé čéčĆą░čéčā ą▓čĆąĄą╝ąĄąĮąĖ ą┐čĆąŠčåąĄčüčüąŠčĆą░ ąŠą║ąŠą╗ąŠ 1 ą╝ąĖą║čĆąŠčüąĄą║čāąĮą┤čŗ ą▓ ą▓čŗąĘąŠą▓ąĄ WaitOne ąĖą╗ąĖ Release; SemaphoreSlim čéčĆą░čéąĖčé ąĮą░ čŹč鹊 ąŠą║ąŠą╗ąŠ č湥čéą▓ąĄčĆčéąĖ ą╝ąĖą║čĆąŠčüąĄą║čāąĮą┤čŗ.

ąĪąĄą╝ą░č乊čĆčŗ ą╝ąŠą│čāčé ą▒čŗčéčī ą┐ąŠą╗ąĄąĘąĮčŗąĄ ą▓ ą┐čĆąĄą┤ąĄą╗ą░čģ ąŠą│čĆą░ąĮąĖč湥ąĮąĮąŠą╣ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ - ąŠąĮąĖ ą┐čĆąĄą┤ąŠčéą▓čĆą░čēą░čÄčé čüąĖčéčāą░čåąĖąĖ, ą║ąŠą│ą┤ą░ ąŠą┤ąĮčā ąĖ čéčā ąČąĄ čüąĄą║čåąĖčÄ ą║ąŠą┤ą░ ą▓čŗą┐ąŠą╗ąĮčÅčÄčé čüą╗ąĖčłą║ąŠą╝ ą╝ąĮąŠą│ąŠ ą┐ąŠč鹊ą║ąŠą▓. ąÆ čüą╗ąĄą┤čāčÄčēąĄą╝ ą┐čĆąĖą╝ąĄčĆąĄ 5 ą┐ąŠč鹊ą║ąŠą▓ ą┐čŗčéą░čÄčéčüčÅ ą▓ąŠą╣čéąĖ ą▓ ąĮąŠčćąĮąŠą╣ ą║ą╗čāą▒, ą▓ ą║ąŠč鹊čĆčŗą╣ čĆą░ąĘčĆąĄčłąĄąĮąŠ ą▓ąŠą╣čéąĖ ąĘą░ ąŠą┤ąĖąĮ čĆą░ąĘ č鹊ą╗čīą║ąŠ čéčĆąŠąĖą╝ ą┐ąŠč鹊ą║ą░ą╝:

class TheClub

{

static SemaphoreSlim _sem = new SemaphoreSlim (3); // ąĢą╝ą║ąŠčüčéčī == 3

static void Main()

{

for (int i = 1; i <= 5; i++) new Thread (Enter).Start (i);

}

static void Enter (object id)

{

Console.WriteLine (id + " čģąŠč湥čé ąĘą░ą╣čéąĖ");

_sem.Wait();

Console.WriteLine (id + " ą▓ąŠčłąĄą╗!"); // ąóąŠą╗čīą║ąŠ 3 ą┐ąŠč鹊ą║ą░

Thread.Sleep (1000 * (int) id); // ą╝ąŠą│čāčé ąĮą░čģąŠą┤ąĖčéčīčüčÅ čéčāčé

Console.WriteLine (id + " ą▓čŗčģąŠą┤ąĖčé");// ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ.

_sem.Release();

}

}

ąĀąĄąĘčāą╗čīčéą░čé čĆą░ą▒ąŠčéčŗ čŹč鹊ą│ąŠ ą┐čĆąĖą╝ąĄčĆą░:

1 čģąŠč湥čé ąĘą░ą╣čéąĖ

1 ą▓ąŠčłąĄą╗!

2 čģąŠč湥čé ąĘą░ą╣čéąĖ

2 ą▓ąŠčłąĄą╗!

3 čģąŠč湥čé ąĘą░ą╣čéąĖ

3 ą▓ąŠčłąĄą╗!

4 čģąŠč湥čé ąĘą░ą╣čéąĖ

5 čģąŠč湥čé ąĘą░ą╣čéąĖ

1 ą▓čŗčģąŠą┤ąĖčé

4 ą▓ąŠčłąĄą╗!

2 ą▓čŗčģąŠą┤ąĖčé

5 ą▓ąŠčłąĄą╗!

ąĢčüą╗ąĖ ą▓ą╝ąĄčüč鹊 ąŠą┐ąĄčĆą░č鹊čĆą░ Sleep ą▓čŗą┐ąŠą╗ąĮčÅąĄčéčüčÅ ąĖąĮč鹥ąĮčüąĖą▓ąĮčŗą╣ ą┤ąĖčüą║ąŠą▓čŗą╣ ą▓ą▓ąŠą┤/ą▓čŗą▓ąŠą┤, č鹊 čŹč鹊čé čüąĄą╝ą░č乊čĆ čāą╗čāčćčłąĖčé ąŠą▒čēčāčÄ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī ą┐čĆąŠą│čĆą░ą╝ą╝čŗ ą┐čāč鹥ą╝ ąŠą│čĆą░ąĮąĖč湥ąĮąĖčÅ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą╣ ą░ą║čéąĖą▓ąĮąŠčüčéąĖ čü ąČąĄčüčéą║ąĖą╝ ą┤ąĖčüą║ąŠą╝.

Semaphore, ąĄčüą╗ąĖ ąŠąĮ ąĖą╝ąĄąĮąŠą▓ą░ąĮ, ą╝ąŠąČąĄčé čĆą░ą▒ąŠčéą░čéčī ą╝ąĄąČą┤čā ą┐čĆąŠčåąĄčüčüą░ą╝ąĖ č鹊čćąĮąŠ čéą░ą║ ąČąĄ, ą║ą░ą║ ąĖ Mutex.

[ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓ (Thread Safety)]

ą¤čĆąŠą│čĆą░ą╝ą╝ą░ ąĖą╗ąĖ ą╝ąĄč鹊ą┤ čüčćąĖčéą░ąĄčéčüčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ (thread-safe) ąĄčüą╗ąĖ ąŠąĮ ąĮąĄ ą▓ą▓ąŠą┤ąĖčé ąĮąĖą║ą░ą║ąŠą╣ ąĮąĄąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮąŠčüčéąĖ ą▓ čĆą░ą▒ąŠč鹥 ą║ąŠą┤ą░ ą┐čĆąĖ ąĮą░ą╗ąĖčćąĖąĖ čüčåąĄąĮą░čĆąĖčÅ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ. ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓ ą┤ąŠčüčéąĖą│ą░ąĄčéčüčÅ ą│ą╗ą░ą▓ąĮčŗą╝ ąŠą▒čĆą░ąĘąŠą╝ ą┐čāč鹥ą╝ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąĖ čāą╝ąĄąĮčīčłąĄąĮąĖčÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéąĖ ą┐ąŠ ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖčÄ ą╝ąĄąČą┤čā ą┐ąŠč鹊ą║ą░ą╝ąĖ.

ąóąĖą┐čŗ ąŠą▒čēąĄą│ąŠ ąĮą░ąĘąĮą░č湥ąĮąĖčÅ (general-purpose types) čĆąĄą┤ą║ąŠ ąŠčĆąĖąĄąĮčéąĖčĆąŠą▓ą░ąĮčŗ ąĮą░ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéčī ą┐ąŠ čüą╗ąĄą┤čāčÄčēąĖą╝ ą┐čĆąĖčćąĖąĮą░ą╝:

ŌĆó ą”ąĄąĮą░ čĆą░ąĘčĆą░ą▒ąŠčéą║ąĖ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠą│ąŠ ą║ąŠą┤ą░ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĘąĮą░čćąĖč鹥ą╗čīąĮąŠą╣, ą▓ čćą░čüčéąĮąŠčüčéąĖ ąĄčüą╗ąĖ čĆą░ąĘčĆą░ą▒ą░čéčŗą▓ą░ąĄą╝čŗą╣ čéąĖą┐ ąĖą╝ąĄąĄčé ą╝ąĮąŠąČąĄčüčéą▓ąŠ ą┐ąŠą╗ąĄą╣ (ą║ą░ąČą┤ąŠąĄ ą┐ąŠą╗ąĄ ą┐ąŠč鹥ąĮčåąĖą░ą╗čīąĮąŠ ą╝ąŠąČąĄčé ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąŠą▓ą░čéčī ą▓ ą┐čĆąŠąĖąĘą▓ąŠą╗čīąĮąŠą╝ ą║ąŠąĮč鹥ą║čüč鹥 ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ).

ŌĆó ą×ą▒ąĄčüą┐ąĄč湥ąĮąĖąĄ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ ą╝ąŠąČąĄčé ą┐ąŠą▓ą╗ąĄčćčī ą┤ąŠą┐ąŠą╗ąĮąĖč鹥ą╗čīąĮčŗąĄ ąĘą░čéčĆą░čéčŗ ą┐čĆąŠčåąĄčüčüąŠčĆąĮąŠą│ąŠ ą▓čĆąĄą╝ąĄąĮąĖ, čćč鹊 čüąĮąĖąĘąĖčé ąŠą▒čēčāčÄ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī ą║ąŠą┤ą░ (ą▓ čćą░čüčéąĮąŠčüčéąĖ ąĘą░čéčĆą░čéčŗ ą╝ąŠą│čāčé ąĘą░ą▓ąĖčüąĄčéčī ąŠčé č鹊ą│ąŠ, ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ ą╗ąĖ ą▓ ą┤ąĄą╣čüčéą▓ąĖč鹥ą╗čīąĮąŠčüčéąĖ čŹč鹊čé čéąĖą┐ ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ąĖ ą┐ąŠč鹊ą║ą░ą╝ąĖ).

ŌĆó ą¤ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╣ čéąĖą┐ ą▓ąŠą▓čüąĄ ąĮąĄ ąŠą▒čÅąĘą░č鹥ą╗čīąĮąŠ ą┐čĆąĖą▓ąĄą┤ąĄčé ą║ ą▒ąĄąĘąŠą┐ą░čüąĮąŠą╝čā ąĄą│ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÄ ą▓ ą┐čĆąŠą│čĆą░ą╝ą╝ąĄ. ąóą░ą║ąČąĄ čćą░čüč鹊 ą║ąŠąĮąĄčćąĮčŗą╣ ą║ąŠą┤, ą▓ą║ą╗čÄčćą░čÄčēąĖą╣ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠą│ąŠ čéąĖą┐ą░, ą┤ąĄą╗ą░ąĄčé ąĄą│ąŠ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ąĖąĘą▒čŗč鹊čćąĮąŠą╣.

ąĪą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīąĮąŠ, čĆą░čåąĖąŠąĮą░ą╗čīąĮąŠ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéčī čĆąĄą░ą╗ąĖąĘąŠą▓ą░čéčī č鹊ą╗čīą║ąŠ ą▓ č鹊ą╝ ą╝ąĄčüč鹥, ą│ą┤ąĄ ąŠąĮą░ ą┤ąĄą╣čüčéą▓ąĖč鹥ą╗čīąĮąŠ ą┤ąŠą╗ąČąĮą░ ą▒čŗčéčī, čćč鹊ą▒čŗ ą┐čĆą░ą▓ąĖą╗čīąĮąŠ ąŠą▒čĆą░ą▒ąŠčéą░čéčī ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮčŗą╣ čüčåąĄąĮą░čĆąĖą╣ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ.

ą×ą┤ąĮą░ą║ąŠ ąĘą┤ąĄčüčī ąĄčüčéčī ąĮąĄčüą║ąŠą╗čīą║ąŠ čüą┐ąŠčüąŠą▒ąŠą▓ "ąŠą▒ą╝ą░ąĮą░", čćč鹊ą▒čŗ ą▒ąĄąĘąŠą┐ą░čüąĮąŠ ąĘą░ą┐čāčüčéąĖčéčī ą▒ąŠą╗čīčłąĖąĄ ąĖ čüą╗ąŠąČąĮčŗąĄ ą║ą╗ą░čüčüčŗ ą▓ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠą╝ ąŠą║čĆčāąČąĄąĮąĖąĖ. ą×ą┤ąĖąĮ ąĖąĘ ąĮąĖčģ - ąČąĄčĆčéą▓ąŠą▓ą░čéčī ą│čĆą░ąĮčāą╗čÅčĆąĮąŠčüčéčīčÄ ą┐čāč鹥ą╝ ąŠą▒ąĄčĆčéą║ąĖ ąŠą┤ąĮąŠą╣ ą╝ąŠąĮąŠą┐ąŠą╗čīąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąŠą╣ ą▒ąŠą╗čīčłąĖčģ čüąĄą║čåąĖą╣ ą║ąŠą┤ą░ - ą┤ą░ąČąĄ ą┤ąŠčüčéčāą┐ ą║ąŠ ą▓čüąĄą╝ ąŠą▒čŖąĄą║čéčā - ą┐čĆąĖąĮčāąČą┤ą░čÅ ą┐čĆąĖą╝ąĄąĮąĖčéčī ą┐ąŠčüą╗ąĄą┤ąŠą▓ą░č鹥ą╗čīąĮčŗą╣ ą┤ąŠčüčéčāą┐ ą║ ąŠą▒čŖąĄą║čéčā ąĮą░ ą▓ąĄčĆčģąĮąĄą╝ čāčĆąŠą▓ąĮąĄ. ąóą░ą║ą░čÅ čéą░ą║čéąĖą║ą░ čäą░ą║čéąĖč湥čüą║ąĖ ą▓ą░ąČąĮą░, ąĄčüą╗ąĖ ąÆčŗ čģąŠčéąĖč鹥 ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ąĮąĄ ą▒ąĄąĘąŠą┐ą░čüąĮčŗą╣ ą┐ąŠ ąŠčéąĮąŠčłąĄąĮąĖčÄ ą║ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ čüč鹊čĆąŠąĮąĮąĖą╣ ą║ąŠą┤ (ąĖą╗ąĖ ą▒ąŠą╗čīčłąĖąĮčüčéą▓ąŠ Framework-čéąĖą┐ąŠą▓) ą▓ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠą╝ ą║ąŠąĮč鹥ą║čüč鹥. ą¤čĆąĖąĄą╝ ą┤ąŠą╗ąČąĄąĮ ą┐čĆąŠčüč鹊 ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ąŠą┤ąĖąĮą░ą║ąŠą▓čāčÄ ą╝ąŠąĮąŠą┐ąŠą╗čīąĮčāčÄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā (exclusive lock), čćč鹊ą▒čŗ ąĘą░čēąĖčéąĖčéčī ą┤ąŠčüčéčāą┐ ą║ąŠ ą▓čüąĄą╝ čüą▓ąŠą╣čüčéą▓ą░ą╝, ą╝ąĄč鹊ą┤ą░ą╝ ąĖ ą┐ąŠą╗čÅą╝ ąĮą░ ąĮąĄ ą▒ąĄąĘąŠą┐ą░čüąĮąŠą╝ ą┐ąŠ ąŠčéąĮąŠčłąĄąĮąĖčÄ ą║ ą┐ąŠč鹊ą║ą░ą╝ ąŠą▒čŖąĄą║č鹥. ąŁč鹊 čĆąĄčłąĄąĮąĖąĄ čģąŠčĆąŠčłąŠ čĆą░ą▒ąŠčéą░ąĄčé, ąĄčüą╗ąĖ ą▓čüąĄ ą╝ąĄč鹊ą┤čŗ ąŠą▒čŖąĄą║čéą░ ą▓čŗą┐ąŠą╗ąĮčÅčÄčéčüčÅ ą▒čŗčüčéčĆąŠ (ąĖąĮą░č湥 ą▒čāą┤čāčé ąĖą╝ąĄčéčī ą╝ąĄčüč鹊 ą▒ąŠą╗čīčłąĖąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ).

ą¤čĆąĖą╝ąĖčéąĖą▓ąĮčŗąĄ čéąĖą┐čŗ, ą║ ą║ąŠč鹊čĆčŗą╝ ąŠčéąĮąŠčüčÅčéčüčÅ ąĮąĄą║ąŠč鹊čĆčŗąĄ čéąĖą┐čŗ .NET Framework, ą▒čāą┤čāčćąĖ ąĖąĮčüčéą░ąĮčåąĖčĆąŠą▓ą░ąĮąĮčŗą╝ąĖ, čÅą▓ą╗čÅčÄčéčüčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ąĖ č鹊ą╗čīą║ąŠ ą┐čĆąĖ ą┤ąŠčüčéčāą┐ąĄ read-only. ą×čéą▓ąĄčéčüčéą▓ąĄąĮąĮąŠčüčéčī ąĘą░ ą┐čĆą░ą▓ąĖą╗čīąĮąŠąĄ ąĖčģ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄ ą┤ą╗čÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ ą╗ąĄąČąĖčé ąĮą░ čĆą░ąĘčĆą░ą▒ąŠčéčćąĖą║ąĄ, ąŠą▒čŗčćąĮąŠ čŹč鹊 ą▓ąĄčĆąĮąŠ ą┤ą╗čÅ ą╝ąŠąĮąŠą┐ąŠą╗čīąĮčŗčģ ą▒ą╗ąŠą║ąĖčĆąŠą▓ąŠą║ (ąĖčüą║ą╗čÄč湥ąĮąĖąĄ čüąŠčüčéą░ą▓ą╗čÅčÄčé čüą▒ąŠčĆą║ąĖ ą▓ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ąĄ System.Collections.Concurrent).

ąöčĆčāą│ąŠą╣ čüą┐ąŠčüąŠą▒ ąŠą▒ą╝ą░ąĮą░ - ą╝ąĖąĮąĖą╝ąĖąĘą░čåąĖčÅ ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖčÅ ą┐ąŠč鹊ą║ąŠą▓ ą┐čāč鹥ą╝ ą╝ąĖąĮąĖą╝ąĖąĘą░čåąĖąĖ ą║ąŠą╗ąĖč湥čüčéą▓ą░ ąŠą▒čēąĖčģ ą┤ą░ąĮąĮčŗčģ. ąŁč鹊 ąŠčéą╗ąĖčćąĮčŗą╣ ą┐ąŠą┤čģąŠą┤, ąĮąĄčÅą▓ąĮąŠ ąĖčüą┐ąŠą╗čīąĘčāąĄą╝čŗą╣ ą▓ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅčģ čüčĆąĄą┤ąĮąĄą│ąŠ čāčĆąŠą▓ąĮčÅ, ąĮąĄ čüąŠčģčĆą░ąĮčÅčÄčēąĖčģ čüą▓ąŠąĄ čüąŠčüč鹊čÅąĮąĖąĄ, ąĖ čüąĄčĆą▓ąĄčĆą░čģ ą▓ąĄą▒-čüčéčĆą░ąĮąĖčå. ą¤ąŠčüą║ąŠą╗čīą║čā ą╝ąŠą│čāčé ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ ą┐ąŠčüčéčāą┐ąĖčéčī ąĮąĄčüą║ąŠą╗čīą║ąŠ ą║ą╗ąĖąĄąĮčéčüą║ąĖčģ ąĘą░ą┐čĆąŠčüąŠą▓, ą▓čŗąĘčŗą▓ą░ąĄą╝čŗąĄ ą╝ąĄč鹊ą┤čŗ čüąĄčĆą▓ąĄčĆą░ ą┤ąŠą╗ąČąĮčŗ ą▒čŗčéčī ą┐ąŠč鹊ą║ąŠąĘą░čēąĖčēąĄąĮąĮčŗą╝ąĖ. ąöąĖąĘą░ą╣ąĮ ą▒ąĄąĘ čüąŠčģčĆą░ąĮąĄąĮąĖčÅ čüąŠčüč鹊čÅąĮąĖčÅ (stateless, ą┐ąŠą┐čāą╗čÅčĆąĮčŗą╣ ą┐ąŠ ą┐čĆąĖčćąĖąĮąĄ čģąŠčĆąŠčłąĄą╣ ą╝ą░čüčłčéą░ą▒ąĖčĆčāąĄą╝ąŠčüčéąĖ) ąĖąĘąĮą░čćą░ą╗čīąĮąŠ ąŠą│čĆą░ąĮąĖčćąĖą▓ą░ąĄčé ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖčÅ ą╝ąĄąČą┤čā ą┐ąŠč鹊ą║ą░ą╝ąĖ, ą┐ąŠčüą║ąŠą╗čīą║čā ą║ą╗ą░čüčüčŗ ąĮąĄ čüąŠčģčĆą░ąĮčÅčÄčé ą┤ą░ąĮąĮčŗąĄ ą╝ąĄąČą┤čā ąĘą░ą┐čĆąŠčüą░ą╝ąĖ. ąóąŠą│ą┤ą░ ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖąĄ ą┐ąŠč鹊ą║ąŠą▓ ąŠą│čĆą░ąĮąĖčćąĖą▓ą░ąĄčéčüčÅ č鹊ą╗čīą║ąŠ čüčéą░čéąĖč湥čüą║ąĖą╝ąĖ ą┐ąŠą╗čÅą╝ąĖ, čĆąĄčłąĄąĮąĖąĄ čüąŠąĘą┤ą░čéčī ą║ąŠč鹊čĆčŗąĄ ą╝ąŠąČąĮąŠ ą┐čĆąĖąĮčÅčéčī č鹊ą╗čīą║ąŠ ą▓ čåąĄą╗čÅčģ ą║čŹčłąĖčĆąŠą▓ą░ąĮąĖčÅ ą▓ ą┐ą░ą╝čÅčéąĖ ąŠą▒čēąĖčģ ąĖčüą┐ąŠą╗čīąĘčāąĄą╝čŗčģ ą┤ą░ąĮąĮčŗčģ, ąĖ ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗ąĄąĮąĖčÅ ąĖąĮčäčĆą░čüčéčĆčāą║čéčāčĆčŗ čüą╗čāąČą▒ ą░čāč鹥ąĮčéąĖčäąĖą║ą░čåąĖąĖ ąĖ ą░čāą┤ąĖčéą░.

ąÜąŠąĮąĄčćąĮčŗą╣ čŹčéą░ą┐ čĆąĄą░ą╗ąĖąĘą░čåąĖąĖ ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ ą┐ąŠč鹊ą║ąŠą▓ čüąŠčüč鹊ąĖčé ą▓ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĖ čĆąĄąČąĖą╝ą░ ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąæąĖą▒ą╗ąĖąŠč鹥ą║ą░ .NET Framework čŹč鹊 č鹊čćąĮąŠ ą┤ąĄą╗ą░ąĄčé, ąĄčüą╗ąĖ ą▓čŗ čĆą░ąĘą┤ąĄą╗čÅąĄč鹥 ContextBoundObject ąĮą░ ą┐ąŠą┤ą║ą╗ą░čüčüčŗ ąĖ ą┐čĆąĖą╝ąĄąĮčÅąĄč鹥 ą░čéčĆąĖą▒čāčé Synchronization ą┤ą╗čÅ čŹč鹊ą│ąŠ ą║ą╗ą░čüčüą░. ąóąŠą│ą┤ą░ ą║ą░ąČą┤čŗą╣ čĆą░ąĘ, ą║ąŠą│ą┤ą░ ą▓čŗąĘčŗą▓ą░ąĄčéčüčÅ ą╝ąĄč鹊ą┤ ąĖą╗ąĖ ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ąŠą▒čĆą░čēąĄąĮąĖąĄ ą║ čüą▓ąŠą╣čüčéą▓čā čéą░ą║ąŠą│ąŠ ąŠą▒čŖąĄą║čéą░, ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąĖ ą▒ąĄčĆąĄčéčüčÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĮą░ ą▓ąĄčüčī ąŠą▒čŖąĄą║čé, ą┐ąŠą║ą░ ąĮąĄ ą▓čŗą┐ąŠą╗ąĮąĖčéčüčÅ ą┐ąŠą╗ąĮąŠčüčéčīčÄ ą╝ąĄč鹊ą┤ ąĖą╗ąĖ ąĮąĄ ąĘą░ą▓ąĄčĆčłąĖčéčüčÅ ą┤ąŠčüčéčāą┐ ą║ čüą▓ąŠą╣čüčéą▓čā. ąźąŠčéčÅ čŹč鹊 čāą┐čĆąŠčēą░ąĄčé ąŠą▒ąĄčüą┐ąĄč湥ąĮąĖąĄ ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ ą┐ąŠč鹊ą║ąŠą▓, ą▓ąŠąĘąĮąĖą║ą░čÄčé čüąŠą▒čüčéą▓ąĄąĮąĮčŗąĄ ą┐čĆąŠą▒ą╗ąĄą╝čŗ: ą╝ąĄčĆčéą▓čŗąĄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ (deadlock), ą║ąŠč鹊čĆčŗąĄ ąĖąĮą░č湥 ąĮąĄ ą┐čĆąŠąĖąĘąŠčłą╗ąĖ ą▒čŗ, čāčģčāą┤čłąĄąĮąĖąĄ ą┐ą░čĆą░ą╗ą╗ąĄą╗ąĖąĘą╝ą░ ąĖ ąĮąĄą┐čĆąĄą┤ąĮą░ą╝ąĄčĆąĄąĮąĮą░čÅ čĆąĄąĄąĮčéčĆą░ąĮčéąĮąŠčüčéčī. ą¤ąŠ čŹčéąĖą╝ ą┐čĆąĖčćąĖąĮą░ą╝ čĆčāčćąĮą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąŠą▒čŗčćąĮąŠ ą╗čāčćčłąĖą╣ ą▓čŗą▒ąŠčĆ - ą┐ąŠ ą║čĆą░ą╣ąĮąĄą╣ ą╝ąĄčĆąĄ ą┐ąŠą║ą░ ąĮąĄ čüčéą░ąĮąĄčé ą┤ąŠčüčéčāą┐ąĮčŗą╝ čāą┐čĆąŠčēąĄąĮąĮčŗą╣ čĆąĄąČąĖą╝ ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ.

ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓ ąĖ čéąĖą┐čŗ .NET Framework. ąæą╗ąŠą║ąĖčĆąŠą▓ą║čā ą╝ąŠąČąĮąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī, čćč鹊ą▒čŗ ą┐čĆąĄą▓čĆą░čéąĖčéčī ąĮąĄ ą▒ąĄąĘąŠą┐ą░čüąĮčŗą╣ ą┐ąŠ ąŠčéąĮąŠčłąĄąĮąĖčÄ ą║ ą┐ąŠč鹊ą║ą░ą╝ ą║ąŠą┤ ą▓ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╣. ąźąŠčĆąŠčłąĄąĄ ą┐čĆąĖą╝ąĄąĮąĄąĮąĖąĄ ą┤ą╗čÅ čŹč鹊ą│ąŠ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ą░ .NET Framework: ą┐ąŠčćčéąĖ ą▓čüąĄ ąĄčæ ąĮąĄ ą┐čĆąĖą╝ąĖčéąĖą▓ąĮčŗąĄ čéąĖą┐čŗ, ą▒čāą┤čāčćąĖ ąĖąĮčüčéą░ąĮčåąĖčĆąŠą▓ą░ąĮąĮčŗą╝ąĖ, ąĮąĄ čÅą▓ą╗čÅčÄčéčüčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ąĖ (ą┤ą╗čÅ č湥ą│ąŠ-č鹊 ą▒ąŠą╗čīčłąĄą│ąŠ, č湥ą╝ ą┤ąŠčüčéčāą┐ č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ). ąś ą▓čüąĄ ąČąĄ ąŠąĮąĖ ą╝ąŠą│čāčé ą▒čŗčéčī ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮčŗ ą▓ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠą╝ ą║ąŠą┤ąĄ, ąĄčüą╗ąĖ ą╗čÄą▒ąŠą╣ ą┤ąŠčüčéčāą┐ ą║ ą╗čÄą▒ąŠą╝čā ąĖą╝ąĄčÄčēąĄą╝čāčüčÅ ąŠą▒čŖąĄą║čéčā ąŠčüčāčēąĄčüčéą▓ą╗čÅąĄčéčüčÅ č湥čĆąĄąĘ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā lock. ąØąĖąČąĄ ą┐čĆąĖą▓ąĄą┤ąĄąĮ ą┐čĆąĖą╝ąĄčĆ, ą│ą┤ąĄ ą┤ą▓ą░ ą┐ąŠč鹊ą║ą░ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ ą┤ąŠą▒ą░ą▓ą╗čÅčÄčé 菹╗ąĄą╝ąĄąĮčé ą▓ ąŠą┤ąĮčā ąĖ čéčā ąČąĄ ą║ąŠą╗ą╗ąĄą║čåąĖčÄ List, ąĖ ąĘą░č鹥ą╝ ą┤ąĄą╗ą░čÄčé ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖąĄ čüą┐ąĖčüą║ą░ ą▓ čåąĖą║ą╗ąĄ:

class ThreadSafe

{

static List < string> _list = new List < string>();

static void Main()

{

new Thread (AddItem).Start();

new Thread (AddItem).Start();

}

static void AddItem()

{

lock (_list) _list.Add ("Item " + _list.Count);

string[] items;

lock (_list) items = _list.ToArray();

foreach (string s in items) Console.WriteLine (s);

}

}

ąÆ čŹč鹊ą╝ ą┐čĆąĖą╝ąĄčĆąĄ ą╝čŗ ąŠčüčāčēąĄčüčéą▓ą╗čÅąĄą╝ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ąĮą░ čüą░ą╝ąŠą╝ ąŠą▒čŖąĄą║č鹥 _list. ąĢčüą╗ąĖ ą▒čŗ čā ąĮą░čü ą▒čŗą╗ąŠ 2 ą▓ąĘą░ąĖą╝ąŠčüą▓čÅąĘą░ąĮąĮčŗčģ čüą┐ąĖčüą║ą░, ą╝čŗ ą┤ąŠą╗ąČąĮčŗ ą▒čŗą╗ąĖ ą▒čŗ ą▓čŗą▒čĆą░čéčī ąŠą▒čēąĖą╣ ąŠą▒čŖąĄą║čé, ąĮą░ ą║ąŠč鹊čĆąŠą╝ ą╝ąŠąČąĮąŠ ą▒čŗą╗ąŠ ą▒čŗ ąŠčüčāčēąĄčüčéą▓ąĖčéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā (ą╝čŗ ą╝ąŠą│ą╗ąĖ ą▒čŗ ą▓čŗą▒čĆą░čéčī ą┤ą╗čÅ čŹč鹊ą│ąŠ ąŠą┤ąĖąĮ ąĖąĘ čŹčéąĖčģ čüą┐ąĖčüą║ąŠą▓, ąĮąŠ ą╗čāčćčłąĄ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ą┤ą╗čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ąŠčéą┤ąĄą╗čīąĮąŠąĄ, ąĮąĄąĘą░ą▓ąĖčüąĖą╝ąŠąĄ ą┐ąŠą╗ąĄ).

ą¤ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖąĄ ą║ąŠą╗ą╗ąĄą║čåąĖą╣ .NET čéą░ą║ąČąĄ ąĮąĄ čÅą▓ą╗čÅąĄčéčüčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ ą▓ č鹊ą╝ čüą╝čŗčüą╗ąĄ, čćč鹊 ą▒čāą┤ąĄčé ą▓čŗą▒čĆąŠčłąĄąĮąŠ ąĖčüą║ą╗čÄč湥ąĮąĖąĄ, ąĄčüą╗ąĖ čüą┐ąĖčüąŠą║ ą╝ąŠą┤ąĖčäąĖčåąĖčĆčāąĄčéčüčÅ ą▓ąŠ ą▓čĆąĄą╝čÅ ą┐čĆąŠčåąĄčüčüą░ ąĄą│ąŠ ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖčÅ. ąÆą╝ąĄčüč鹊 č鹊ą│ąŠ, čćč鹊ą▒čŗ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčīčüčÅ ąĮą░ ą▓čĆąĄą╝čÅ ą┤ąŠ ąĘą░ą▓ąĄčĆčłąĄąĮąĖčÅ ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖčÅ, ą▓ čŹč鹊ą╝ ą┐čĆąĖą╝ąĄčĆąĄ ą╝čŗ ą┐čĆąŠčüč鹊 čüąĮą░čćą░ą╗ą░ ą┤ąĄą╗ą░ąĄą╝ ą║ąŠą┐ąĖčÄ čŹą╗ąĄą╝ąĄąĮč鹊ą▓ ą▓ ą╝ą░čüčüąĖą▓. ąŁč鹊 ą┤ą░ąĄčé ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ąĖąĘą▒ąĄąČą░čéčī čćčĆąĄąĘą╝ąĄčĆąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ, ąĄčüą╗ąĖ ą┐čĆąŠčåąĄčüčü ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖčÅ čüą┐ąĖčüą║ą░ ą╝ąŠąČąĄčé ąĘą░ąĮčÅčéčī ą╝ąĮąŠą│ąŠ ą▓čĆąĄą╝ąĄąĮąĖ (ą┤čĆčāą│ąŠąĄ čĆąĄčłąĄąĮąĖąĄ - ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā reader/writer [4]).

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▓ąŠą║čĆčāą│ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗčģ ąŠą▒čŖąĄą║č鹊ą▓. ąśąĮąŠą│ą┤ą░ čéą░ą║ąČąĄ ąĮčāąČąĮąŠ ą┤ąĄą╗ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą┐čĆąĖ ą┤ąŠčüčéčāą┐ąĄ ą║ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ ąŠą▒čŖąĄą║čéą░ą╝. ąöą╗čÅ ąĖą╗ą╗čÄčüčéčĆą░čåąĖąĖ ą┐čĆąĄą┤čüčéą░ą▓ąĖą╝, čćč鹊 Framework-ą║ą╗ą░čüčü List ą▒čŗą╗ ą┤ąĄą╣čüčéą▓ąĖč鹥ą╗čīąĮąŠ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝, ąĖ ą╝čŗ čģąŠčéąĖą╝ ą┤ąŠą▒ą░ą▓ąĖčéčī 菹╗ąĄą╝ąĄąĮčé ą▓ ąĄą│ąŠ čüą┐ąĖčüąŠą║:

if (!_list.Contains (newItem)) _list.Add (newItem);

ąØąĄąĘą░ą▓ąĖčüąĖą╝ąŠ ąŠčé č鹊ą│ąŠ, čÅą▓ą╗čÅąĄčéčüčÅ čüą┐ąĖčüąŠą║ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ ąĖą╗ąĖ ąĮąĄčé, čŹč鹊čé ąŠą┐ąĄčĆą░č鹊čĆ ąŠą┐čĆąĄą┤ąĄą╗ąĄąĮąĮąŠ ąĮąĄ čÅą▓ą╗čÅąĄčéčüčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝! ąöą╗čÅ ąŠą▒ąĄčüą┐ąĄč湥ąĮąĖčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ ą▓ąĄčüčī ąŠą┐ąĄčĆą░č鹊čĆ if ą┤ąŠą╗ąČąĄąĮ ą▒čŗčéčī ąŠą▒ąĄčĆąĮčāčé ą▓ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā, čćč鹊ą▒čŗ ą┐čĆąĄą┤ąŠčéą▓čĆą░čéąĖčéčī ą▓čŗč鹥čüąĮąĄąĮąĖąĄ ą▓ ą┐čĆąŠą╝ąĄąČčāčéą║ąĄ ą╝ąĄąČą┤čā ą┐čĆąŠą▓ąĄčĆą║ąŠą╣ ąĖ ą┤ąŠą▒ą░ą▓ą╗ąĄąĮąĖąĄą╝ ąĮąŠą▓ąŠą│ąŠ 菹╗ąĄą╝ąĄąĮčéą░. ąóą░ ąČąĄ čüą░ą╝ą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ąĘą░č鹥ą╝ ąĮčāąČąĮą░ ą▓ ą╗čÄą▒ąŠą╝ ą╝ąĄčüč鹥, ą│ą┤ąĄ ą╝čŗ ą╝ąŠą┤ąĖčäąĖčåąĖčĆčāąĄą╝ čŹč鹊čé čüą┐ąĖčüąŠą║. ąØą░ą┐čĆąĖą╝ąĄčĆ, čüą╗ąĄą┤čāčÄčēąĖą╣ ąŠą┐ąĄčĆą░č鹊čĆ čéą░ą║ąČąĄ ąĮčāąČą┤ą░ąĄčéčüčÅ ą▓ ąŠą▒ąĄčĆčéą║ąĄ ąĖą┤ąĄąĮčéąĖčćąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąŠą╣ (čćč鹊ą▒čŗ ą│ą░čĆą░ąĮčéąĖčĆąŠą▓ą░čéčī, čćč鹊 ą┐čĆąŠčåąĄčüčü ą╝ąŠą┤ąĖčäąĖą║ą░čåąĖąĖ ąĮąĄ ą▓čŗč鹥čüąĮąĖčé ą┐čĆąĄą┤čŗą┤čāčēąĖą╣ ąŠą┐ąĄčĆą░č鹊čĆ):

ąöčĆčāą│ąĖą╝ąĖ čüą╗ąŠą▓ą░ą╝ąĖ, ą╝čŗ ą┤ąŠą╗ąČąĮčŗ ą▒čŗą╗ąĖ ą▒čŗ čĆąĄą░ą╗ąĖąĘąŠą▓ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā č鹊čćąĮąŠ čéą░ą║ ąČąĄ, ą║ą░ą║ čŹč鹊 ą┤ąĄą╗ą░ą╗ąĖ čü ąĮąĄ ą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ąĖ ą┤ą╗čÅ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠą│ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ą║ą╗ą░čüčüą░ą╝ąĖ.

ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą▓ąŠą║čĆčāą│ ą┤ąŠčüčéčāą┐ą░ ą║ ą║ąŠą╗ą╗ąĄą║čåąĖąĖ ą╝ąŠąČąĄčé ą┐čĆąĖą▓ąĄčüčéąĖ ą║ čćčĆąĄąĘą╝ąĄčĆąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ ą▓ čüčĆąĄą┤ąĄ ą▓čŗčüąŠą║ąŠą╣ ą║ąŠąĮą║čāčĆąĄąĮčåąĖąĖ ą┐ąŠč鹊ą║ąŠą▓. ąöą╗čÅ čŹč鹊ą│ąŠ Framework 4.0 ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅąĄčé ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗąĄ ąŠč湥čĆąĄą┤čī (queue), čüč鹥ą║ (stack) ąĖ čüą╗ąŠą▓ą░čĆčī (dictionary).

ąĪčéą░čéąĖč湥čüą║ąĖąĄ čćą╗ąĄąĮčŗ ą║ą╗ą░čüčüą░. ą×ą▒ąĄčĆčéčŗą▓ą░ąĮąĖąĄ ą┤ąŠčüčéčāą┐ą░ ą║ ąŠą▒čŖąĄą║čéčā ą▓ąŠą║čĆčāą│ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čīčüą║ąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ čĆą░ą▒ąŠčéą░ąĄčé č鹊ą╗čīą║ąŠ ąĄčüą╗ąĖ ą▓čüąĄ ą║ąŠąĮą║čāčĆąĄąĮčéąĮčŗąĄ ą┐ąŠč鹊ą║ąĖ čāčćąĖčéčŗą▓ą░čÄčé ąĖ ąĖčüą┐ąŠą╗čīąĘčāčÄčé ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ąŁč鹊 ą╝ąŠąČąĄčé ąĮąĄ ąĖą╝ąĄčéčī ą╝ąĄčüč鹊, ąĄčüą╗ąĖ ąŠą▒čŖąĄą║čé čłąĖčĆąŠą║ąŠ ą┤ąŠčüčéčāą┐ąĄąĮ. ąĪą░ą╝čŗą╣ čģčāą┤čłąĖą╣ čüą╗čāčćą░ą╣ - čüčéą░čéąĖč湥čüą║ąĖą╣ (ąŠą▒čŖčÅą▓ą╗ąĄąĮąĮčŗą╣ čü ą║ą╗čÄč湥ą▓čŗą╝ čüą╗ąŠą▓ąŠą╝ static) čćą╗ąĄąĮ ą║ą╗ą░čüčüą░ čüąŠ čüąĮčÅčéčŗą╝ ąŠą│čĆą░ąĮąĖč湥ąĮąĖąĄą╝ ąĮą░ ą┤ąŠčüčéčāą┐ (ąŠą▒čŖčÅą▓ą╗ąĄąĮ čü čéąĖą┐ąŠą╝ ą┤ąŠčüčéčāą┐ą░ public). ąöą╗čÅ ą┐čĆąĖą╝ąĄčĆą░ ą┐čĆąĄą┤čüčéą░ą▓ąĖą╝: ąĄčüą╗ąĖ čüčéą░čéąĖč湥čüą║ąŠąĄ čüą▓ąŠą╣čüčéą▓ąŠ DateTime.Now čüčéčĆčāą║čéčāčĆčŗ DateTime, ą▒čŗą╗ąŠ ą▒čŗ ąĮąĄ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝, č鹊 ą┤ą▓ą░ ą║ąŠąĮą║čāčĆąĄąĮčéąĮčŗčģ ą┤ąŠčüčéčāą┐ą░ ą║ ąĮąĄą╝čā ą┤ą░ą┤čāčé ąŠčłąĖą▒ąŠčćąĮčŗą╣ čĆąĄąĘčāą╗čīčéą░čé ąĖą╗ąĖ ą▓čŗą▒čĆą░čüčŗą▓ą░ąĮąĖąĄ ąĖčüą║ą╗čÄč湥ąĮąĖčÅ. ąĢą┤ąĖąĮčüčéą▓ąĄąĮąĮčŗą╣ čüą┐ąŠčüąŠą▒ ą▒ąŠčĆąŠčéčīčüčÅ čü čŹčéąĖą╝ č湥čĆąĄąĘ ą▓ąĮąĄčłąĮčÄčÄ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą╝ąŠą│ ą▒čŗ čüąŠčüč鹊čÅčéčī ą▓ č鹊ą╝, čćč鹊ą▒čŗ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčī ą┤ąŠčüčéčāą┐ ą║ čüą░ą╝ąŠą╝čā čéąĖą┐čā - lock(typeof(DateTime)) - ą┐ąĄčĆąĄą┤ ą▓čŗąĘąŠą▓ąŠą╝ DateTime.Now. ąŁč鹊 čĆą░ą▒ąŠčéą░ą╗ąŠ ą▒čŗ, č鹊ą╗čīą║ąŠ ąĄčüą╗ąĖ ą▓čüąĄ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčüčéčŗ čüąŠą│ą╗ą░čüąĖą╗ąĖčüčī ą▒čŗ ą┐ąŠčüčéčāą┐ą░čéčī ą┐ąŠą┤ąŠą▒ąĮčŗą╝ ąŠą▒čĆą░ąĘąŠą╝ (čćč鹊 ą╝ą░ą╗ąŠą▓ąĄčĆąŠčÅčéąĮąŠ). ąÜčĆąŠą╝ąĄ č鹊ą│ąŠ, ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░ čéąĖą┐ą░ čüąŠąĘą┤ą░ąĄčé čüąŠą▒čüčéą▓ąĄąĮąĮčŗąĄ ą┐čĆąŠą▒ą╗ąĄą╝čŗ.

ą¤ąŠ čŹč鹊ą╣ ą┐čĆąĖčćąĖąĮąĄ čüčéą░čéąĖč湥čüą║ąĖąĄ čćą╗ąĄąĮčŗ čüčéčĆčāą║čéčāčĆčŗ DateTime (čüčéčĆčāą║čéčāčĆą░ ąĖ ą║ą╗ą░čüčü ąĮą░ C# čŹč鹊 ą┐ąŠ čüčāčéąĖ ąŠą┤ąĮąŠ ąĖ č鹊 ąČąĄ) ą┤ąŠą╗ąČąĮčŗ ą▒čŗčéčī čéčēą░č鹥ą╗čīąĮąŠ čĆąĄą░ą╗ąĖąĘąŠą▓ą░ąĮčŗ ą┤ą╗čÅ ąŠą▒ąĄčüą┐ąĄč湥ąĮąĖčÅ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ. ą×č鹊 ąŠą▒čēąĖą╣ čłą░ą▒ą╗ąŠąĮ ą┐ąŠą▓ąĄą┤ąĄąĮąĖčÅ ą║ąŠą┤ą░ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ąĖ .NET Framework: static-čćą╗ąĄąĮčŗ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗ; čćą╗ąĄąĮčŗ 菹║ąĘąĄą╝ą┐ą╗čÅčĆąŠą▓ (instance members) ąĮąĄ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗ. ąĪą╗ąĄą┤ąŠą▓ą░ąĮąĖąĄ čŹč鹊ą╝čā čłą░ą▒ą╗ąŠąĮčā čéą░ą║ąČąĄ čåąĄą╗ąĄčüąŠąŠą▒čĆą░ąĘąĮąŠ ą┐čĆąĖ ąĮą░ą┐ąĖčüą░ąĮąĖąĖ čéąĖą┐ąŠą▓ ą┤ą╗čÅ ą┐čāą▒ą╗ąĖčćąĮąŠą│ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ, čćč鹊ą▒čŗ ąĮąĄ čüąŠąĘą┤ą░ą▓ą░čéčī ąĮąĄą▓ąŠąĘą╝ąŠąČąĮčŗąĄ ą┐čĆąŠą▒ą╗ąĄą╝čŗ čü ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéčīčÄ ą┐ąŠč鹊ą║ąŠą▓. ąöčĆčāą│ąĖą╝ąĖ čüą╗ąŠą▓ą░ą╝ąĖ, ą┐čāč鹥ą╝ čĆąĄą░ą╗ąĖąĘą░čåąĖąĖ čüčéą░čéąĖč湥čüą║ąĖčģ ą╝ąĄč鹊ą┤ąŠą▓ ą┐ąŠč鹊ą║ąŠąĘą░čēąĖčēąĄąĮąĮčŗą╝ąĖ ąÆčŗ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčĆčāąĄč鹥 ą║ąŠą┤ čéąĖą┐ą░, čćč鹊ą▒čŗ ąĮąĄ ąĖčüą║ą╗čÄčćą░čéčī ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓ ą┤ą╗čÅ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĄą╣ čŹč鹊ą│ąŠ čéąĖą┐ą░.

ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┤ą╗čÅ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ą▓ ą┐ąŠč鹊ą║ą░čģ čüčéą░čéąĖč湥čüą║ąĖčģ ą╝ąĄč鹊ą┤ąŠą▓ čŹč鹊 č鹊, čćč鹊 ąÆčŗ ą┤ąŠą╗ąČąĮčŗ ą║ąŠą┤ąĖčĆąŠą▓ą░čéčī čüą┐ąĄčåąĖą░ą╗čīąĮąŠ: ąŠąĮąŠ ąĮąĄ ą┐čĆąŠąĖąĘąŠą╣ą┤ąĄčé čüą░ą╝ąŠ čüąŠą▒ąŠą╣, ąĮą░ ąŠčüąĮąŠą▓ą░ąĮąĖąĖ ąŠą▒čŖčÅą▓ą╗ąĄąĮąĖčÅ ą╝ąĄč鹊ą┤ą░ čüčéą░čéąĖč湥čüą║ąĖą╝!

ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┤ą╗čÅ ą┐ąŠč鹊ą║ąŠą▓ ą┐čĆąĖ ą┤ąŠčüčéčāą┐ąĄ č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ. ąĀąĄą░ą╗ąĖąĘą░čåąĖčÅ čéąĖą┐ąŠą▓ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ąĖ ą┤ą╗čÅ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░ č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ (ą│ą┤ąĄ čŹč鹊 ą▓ąŠąĘą╝ąŠąČąĮąŠ) ą▓čŗą│ąŠą┤ąĮą░, ą┐ąŠčüą║ąŠą╗čīą║čā čŹč鹊 ąŠąĘąĮą░čćą░ąĄčé, čćč鹊 ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĖ ą╝ąŠą│čāčé ąĖąĘą▒ąĄąČą░čéčī čćčĆąĄąĘą╝ąĄčĆąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ. ą£ąĮąŠą│ąĖąĄ čéąĖą┐čŗ ąĖąĘ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ąĖ .NET Framework čüą╗ąĄą┤čāčÄčé čŹč鹊ą╝čā ą┐čĆąĖąĮčåąĖą┐čā: ą║ąŠą╗ą╗ąĄą║čåąĖąĖ (collections), ąĮą░ą┐čĆąĖą╝ąĄčĆ, ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗ ą┤ą╗čÅ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░ ą┐ąŠč鹊ą║ąŠą▓ ąĮą░ čćč鹥ąĮąĖąĄ.

ąĪą╗ąĄą┤ąŠą▓ą░ąĮąĖąĄ čŹč鹊ą╝čā ą┐čĆąĖąĮčåąĖą┐čā ą┐čĆąŠčüč鹊ąĄ: ąĄčüą╗ąĖ ąÆčŗ ą┤ąŠą║čāą╝ąĄąĮčéąĖčĆčāąĄč鹥 čéąĖą┐ ą║ą░ą║ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╣ ą┤ą╗čÅ ą║ąŠąĮą║čāčĆąĄąĮčéąĮąŠą│ąŠ ą┤ąŠčüčéčāą┐ą░ č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ, ąĮąĄ ąĘą░ą┐ąĖčüčŗą▓ą░ą╣č鹥 ą▓ ą┐ąŠą╗čÅ ą▓ ą╝ąĄč鹊ą┤ą░čģ, ą║ąŠč鹊čĆčŗąĄ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čī ąŠąČąĖą┤ą░ąĄčé čĆą░ą▒ąŠčéą░čÄčēąĖą╝ąĖ č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ (ąĖą╗ąĖ ą┤ąĄą╗ą░ą╣č鹥 ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą▓ąŠą║čĆčāą│ ąĘą░ą┐ąĖčüąĖ). ąØą░ą┐čĆąĖą╝ąĄčĆ, ą▓ čĆąĄą░ą╗ąĖąĘą░čåąĖąĖ ą╝ąĄč鹊ą┤ą░ ToArray() ą▓ ą║ąŠą╗ą╗ąĄą║čåąĖąĖ ąÆčŗ ą╝ąŠąČąĄč鹥 ąĮą░čćą░čéčī čüąŠ čüąČą░čéąĖčÅ ą▓ąĮčāčéčĆąĄąĮąĮąĄą╣ čüčéčĆčāą║čéčāčĆčŗ ą║ąŠą╗ą╗ąĄą║čåąĖąĖ. ą×ą┤ąĮą░ą║ąŠ čŹč鹊 čüą┤ąĄą╗ą░ą╗ąŠ ą▒čŗ ą╝ąĄč鹊ą┤ ąĮąĄ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗą╝ ą┤ą╗čÅ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗ąĄą╣, ą║ąŠč鹊čĆčŗąĄ ąŠąČąĖą┤ą░čÄčé ą┤ąŠčüčéčāą┐ą░ č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ.

ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓ ą┤ą╗čÅ č鹊ą╗čīą║ąŠ čćč鹥ąĮąĖčÅ ąŠą┤ąĮą░ ąĖąĘ ą┐čĆąĖčćąĖąĮ, ą┐ąŠ ą║ąŠč鹊čĆąŠą╣ ą┐ąĄčĆąĄčćąĖčüą╗ąĖč鹥ą╗ąĖ (enumerators) ąŠčéą┤ąĄą╗ąĄąĮčŗ ąŠčé ą┐ąĄčĆąĄčćąĖčüą╗ąĄąĮąĖą╣ (enumerables): ą┤ą▓ą░ ą┐ąŠč鹊ą║ą░ ą╝ąŠą│čāčé ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ ą┐ąĄčĆąĄčćąĖčüą╗čÅčéčī 菹╗ąĄą╝ąĄąĮčéčŗ ą║ąŠą╗ą╗ąĄą║čåąĖąĖ, ą┐ąŠč鹊ą╝čā čćč鹊 ą║ą░ąČą┤čŗą╣ ą┐ąŠą╗čāčćą░ąĄčé ąŠčéą┤ąĄą╗čīąĮčŗą╣ ąŠą▒čŖąĄą║čé ą┐ąĄčĆąĄčćąĖčüą╗ąĖč鹥ą╗čÅ.

ą¤čĆąĖ ąŠčéčüčāčéčüčéą▓ąĖąĖ ą┤ąŠą║čāą╝ąĄąĮčéą░čåąĖąĖ ą┐čĆąĖčģąŠą┤ąĖčéčüčÅ ą┐ą╗ą░čéąĖčéčī ą┐čĆąĄą┤ą┐ąŠą╗ąŠąČąĄąĮąĖąĄą╝, čćč鹊 ą┐ąŠ čüą▓ąŠąĄą╣ ą┐čĆąĖčĆąŠą┤ąĄ ą╗čÄą▒ąŠą╣ ą╝ąĄč鹊ą┤ čĆą░ą▒ąŠčéą░ąĄčé č鹊ą╗čīą║ąŠ ąĮą░ čćč鹥ąĮąĖąĄ. ąźąŠčĆąŠčłąĖą╣ ą┐čĆąĖą╝ąĄčĆ čŹč鹊 ą║ą╗ą░čüčü Random: ą║ąŠą│ą┤ą░ ąÆčŗ ą▓čŗąĘčŗą▓ą░ąĄč鹥 Random.Next(), ąĄą│ąŠ ą▓ąĮčāčéčĆąĄąĮąĮčÅčÅ čĆąĄą░ą╗ąĖąĘą░čåąĖčÅ čéčĆąĄą▒čāąĄčé, čćč鹊ą▒čŗ čŹč鹊 ą┤ąĄą╣čüčéą▓ąĖąĄ ąŠą▒ąĮąŠą▓ąĖą╗ąŠ ą▓ąĮčāčéčĆąĄąĮąĮąĄąĄ ą┐čĆąĖą▓ą░čéąĮąŠąĄ ąĘąĮą░č湥ąĮąĖąĄ seed. ąóą░ą║ąĖą╝ ąŠą▒čĆą░ąĘąŠą╝, ąÆčŗ ą┤ąŠą╗ąČąĮčŗ ą╗ąĖą▒ąŠ ą┤ąĄą╗ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą▓ąŠą║čĆčāą│ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ą║ą╗ą░čüčüą░ Random, ąĖą╗ąĖ ą┐ąŠą┤ą┤ąĄčƹȹĖą▓ą░čéčī čĆą░ąĘą┤ąĄą╗čīąĮčŗąĄ 菹║ąĘąĄą╝ą┐ą╗čÅčĆčŗ čŹč鹊ą│ąŠ ą║ą╗ą░čüčüą░ ą┤ą╗čÅ ą║ą░ąČą┤ąŠą│ąŠ ą┐ąŠč鹊ą║ą░.

ąæąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓ ą▓ čüąĄčĆą▓ąĄčĆą░čģ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ (Application Servers). ąĪąĄčĆą▓ąĄčĆčŗ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ čéčĆąĄą▒čāčÄčé ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ ą┤ą╗čÅ ąŠą▒čĆą░ą▒ąŠčéą║ąĖ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮčŗčģ ąĘą░ą┐čĆąŠčüąŠą▓ ąŠčé ą║ą╗ąĖąĄąĮč鹊ą▓. ą¤čĆąĖą╗ąŠąČąĄąĮąĖčÅ WCF, ASP.NET ąĖ Web Services ąĮąĄčÅą▓ąĮąŠ ąĖčüą┐ąŠą╗čīąĘčāčÄčé ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéčī; č鹊 ąČąĄ čüą░ą╝ąŠąĄ ą▓ąĄčĆąĮąŠ ą┤ą╗čÅ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ čüąĄčĆą▓ąĄčĆą░ Remoting, ą║ąŠč鹊čĆčŗąĄ ąĖčüą┐ąŠą╗čīąĘčāčÄčé čüąĄč鹥ą▓ąŠą╣ ą║ą░ąĮą░ą╗, čéą░ą║ąŠą╣ ą║ą░ą║ TCP ąĖą╗ąĖ HTTP. ąŁč鹊 ąŠąĘąĮą░čćą░ąĄčé, čćč鹊 ą║ąŠą│ą┤ą░ ąÆčŗ ą┐ąĖčłąĄč鹥 ą║ąŠą┤ ąĮą░ čüč鹊čĆąŠąĮąĄ čüąĄčĆą▓ąĄčĆą░, č鹊 ą┤ąŠą╗ąČąĮčŗ čāčćąĖčéčŗą▓ą░čéčī ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓, ąĄčüą╗ąĖ ąĄčüčéčī ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī ą▓ąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖčÅ čüčĆąĄą┤ąĖ ą┐ąŠč鹊ą║ąŠą▓ ą┐čĆąĖ ąŠą▒čĆą░ą▒ąŠčéą║ąĄ ąĘą░ą┐čĆąŠčüąŠą▓ ą║ą╗ąĖąĄąĮč鹊ą▓. ąÜ čüčćą░čüčéčīčÄ, čéą░ą║ą░čÅ ą▓ąŠąĘą╝ąŠąČąĮąŠčüčéčī čĆąĄą┤ą║ą░; čéąĖą┐ąĖčćąĮčŗą╣ ą║ą╗ą░čüčü čüąĄčĆą▓ąĄčĆą░ ą╗ąĖą▒ąŠ ąĮąĄ čüąŠčģčĆą░ąĮčÅąĄčé čüąŠčüč鹊čÅąĮąĖčÅ (stateless, ąĮąĄ ąĖą╝ąĄąĄčé ą┐ąŠą╗ąĄą╣), ą╗ąĖą▒ąŠ čüąŠą┤ąĄčƹȹĖčé ą╝ąŠą┤ąĄą╗čī ą░ą║čéąĖą▓ą░čåąĖąĖ, ą║ąŠč鹊čĆą░čÅ čüąŠąĘą┤ą░ąĄčé ąŠčéą┤ąĄą╗čīąĮčŗą╣ 菹║ąĘąĄą╝ą┐ą╗čÅčĆ ąŠą▒čŖąĄą║čéą░ ąĮą░ ą║ą░ąČą┤čŗą╣ ą┐ąŠčéčāą┐ąĖą▓čłąĖą╣ ąĘą░ą┐čĆąŠčü ąŠčé ą║ą╗ąĖąĄąĮčéą░. ąÆąĘą░ąĖą╝ąŠą┤ąĄą╣čüčéą▓ąĖąĄ ąŠą▒čŗčćąĮąŠ ą▓ąŠąĘąĮąĖą║ą░ąĄčé č鹊ą╗čīą║ąŠ č湥čĆąĄąĘ čüčéą░čéąĖč湥čüą║ąĖąĄ ą┐ąŠą╗čÅ, ąĖąĮąŠą│ą┤ą░ ąĖčüą┐ąŠą╗čīąĘčāąĄą╝čŗąĄ ą┤ą╗čÅ ą║čŹčłąĖčĆąŠą▓ą░ąĮąĖčÅ ą▓ ą┐ą░ą╝čÅčéąĖ čćą░čüč鹥ą╣ ą▒ą░ąĘčŗ ą┤ą░ąĮąĮčŗčģ ą▓ čåąĄą╗čÅčģ čāą╗čāčćčłąĄąĮąĖčÅ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéąĖ.

ąØą░ą┐čĆąĖą╝ąĄčĆ, ą┐čĆąĄą┤ą┐ąŠą╗ąŠąČąĖą╝, čćč鹊 čā ąÆą░čü ąĄčüčéčī ą╝ąĄč鹊ą┤ RetrieveUser, ą║ąŠč鹊čĆčŗą╣ ą┤ąĄą╗ą░ąĄčé ąĘą░ą┐čĆąŠčü ą║ ą▒ą░ąĘąĄ ą┤ą░ąĮąĮčŗčģ:

// User čŹč鹊 ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čīčüą║ąĖą╣ ą║ą╗ą░čüčü čü ą┐ąŠą╗čÅą╝ąĖ ą┤ą╗čÅ ą┤ą░ąĮąĮčŗčģ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ.

internal User RetrieveUser (int id) { ... }

ąĢčüą╗ąĖ čŹč鹊čé ą╝ąĄč鹊ą┤ ą▓čŗąĘčŗą▓ą░ą╗čüčÅ čćą░čüč鹊, č鹊 ąÆą░ą╝ čüą╗ąĄą┤čāąĄčé čāą╗čāčćčłąĖčéčī ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčī ą┐čāč鹥ą╝ ą║čŹčłąĖčĆąŠą▓ą░ąĮąĖčÅ čĆąĄąĘčāą╗čīčéą░č鹊ą▓ ą▓ čüčéą░čéąĖč湥čüą║ąŠą╝ čüą╗ąŠą▓ą░čĆąĄ (static Dictionary). ąÆąŠčé čĆąĄčłąĄąĮąĖąĄ, čāčćąĖčéčŗą▓ą░čÄčēąĄąĄ ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓:

static class UserCache

{

static Dictionary < int, User> _users = new Dictionary < int, User>();

internal static User GetUser (int id)

{

User u = null;

lock (_users)

if (_users.TryGetValue (id, out u))

return u;

u = RetrieveUser (id); // ą£ąĄč鹊ą┤ ą┤ą╗čÅ ą┐ąŠą╗čāč湥ąĮąĖčÅ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ ąĖąĘ ą▒ą░ąĘčŗ ą┤ą░ąĮąĮčŗčģ

lock (_users) _users [id] = u;

return u;

}

}

ą£čŗ ą┤ąŠą╗ąČąĮčŗ, ą║ą░ą║ ą╝ąĖąĮąĖą╝čāą╝, ą┤ąĄą╗ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą▓ąŠą║čĆčāą│ čćč鹥ąĮąĖčÅ ąĖ ąŠą▒ąĮąŠą▓ą╗ąĄąĮąĖčÅ čüą╗ąŠą▓ą░čĆčÅ ą┤ą╗čÅ ą│ą░čĆą░ąĮčéąĖąĖ ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ ą┐ąŠč鹊ą║ąŠą▓. ąÆ čŹč鹊ą╝ ą┐čĆąĖą╝ąĄčĆąĄ ą╝čŗ ą▓čŗą▒čĆą░ą╗ąĖ ą┐čĆą░ą║čéąĖč湥čüą║ąĖą╣ ą║ąŠą╝ą┐čĆąŠą╝ąĖčüčü ą▓ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ ą╝ąĄąČą┤čā ą┐čĆąŠčüč鹊č鹊ą╣ ąĖ ą┐čĆąŠąĖąĘą▓ąŠą┤ąĖč鹥ą╗čīąĮąŠčüčéčīčÄ. ąØą░čł ą┤ąĖąĘą░ą╣ąĮ ą┐ąŠč鹥ąĮčåąĖą░ą╗čīąĮąŠ čüąŠąĘą┤ą░ąĄčé ąŠč湥ąĮčī ą╝ą░ą╗čāčÄ ą┐ąŠč鹥ąĮčåąĖą░ą╗čīąĮčāčÄ ąĮąĄ čŹčäč乥ą║čéąĖą▓ąĮąŠčüčéčī: ąĄčüą╗ąĖ 2 ą┐ąŠč鹊ą║ą░ ąŠą┤ąĮąŠą▓čĆąĄą╝ąĄąĮąĮąŠ ą▓čŗąĘąŠą▓čāčé čŹč鹊čé ą╝ąĄč鹊ą┤ čü ąŠą┤ąĮąĖą╝ ąĖ č鹥ą╝ ąČąĄ čĆą░ąĮąĄąĄ ąĮąĄ ąĘą░ą┐čĆą░čłąĖą▓ą░ąĄą╝čŗą╝ id, č鹊 ą╝ąĄč鹊ą┤ RetrieveUser ą▒čŗą╗ ą▒čŗ ą▓čŗąĘą▓ą░ąĮ ą┤ą▓ą░ąČą┤čŗ - ąĖ čüą╗ąŠą▓ą░čĆčī ą┐ąŠą╗čāčćąĖą╗ ą▒čŗ ąĮąĄąĮčāąČąĮąŠąĄ ąŠą▒ąĮąŠą▓ą╗ąĄąĮąĖąĄ. ąæą╗ąŠą║ąĖčĆąŠą▓ą║ą░ ą▓ąŠą║čĆčāą│ ą▓čüąĄą│ąŠ ą╝ąĄč鹊ą┤ą░ ą┐čĆąĄą┤ąŠčéą▓čĆą░čéąĖą╗ą░ ą▒čŗ čŹč鹊, ąĮąŠ čüąŠąĘą┤ą░ą╗ą░ ą▒čŗ ąĄčēąĄ ą╝ąĄąĮčīčłčāčÄ čŹčäč乥ą║čéąĖą▓ąĮąŠčüčéčī: ą▓ąĄčüčī ą║čŹčł ą▒čŗą╗ ą▒čŗ ąĘą░ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ąĮ ąĮą░ ą▓čĆąĄą╝čÅ ą▓čŗąĘąŠą▓ą░ RetrieveUser, ą▓ č鹥č湥ąĮąĖąĄ čŹč鹊ą│ąŠ ą▓čĆąĄą╝ąĄąĮąĖ ą┤čĆčāą│ąĖąĄ ą┐ąŠč鹊ą║ąĖ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą░ą╗ąĖčüčī ą▒čŗ ą┐čĆąĖ ąĘą░ą┐čĆąŠčüąĄ ą╗čÄą▒ąŠą│ąŠ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ.

Rich Client Applications ąĖ Thread Affinity. ą×ą▒ąĄ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ąĖ Windows Presentation Foundation (WPF) ąĖ Windows Forms čüą╗ąĄą┤čāčÄčé ą╝ąŠą┤ąĄą╗čÅą╝ ąĮą░ ąŠčüąĮąŠą▓ąĄ čĆąŠą┤čüčéą▓ąĄąĮąĮąŠčüčéąĖ ą┐ąŠč鹊ą║ąŠą▓ (thread affinity). ąźąŠčéčÅ ą║ą░ąČą┤ą░čÅ ąĖąĘ ą▒ąĖą▒ą╗ąĖąŠč鹥ą║ ąĖą╝ąĄąĄčé ąŠčéą┤ąĄą╗čīąĮčāčÄ čĆąĄą░ą╗ąĖąĘą░čåąĖčÄ, ąŠą▒ąĄ ąŠč湥ąĮčī ą┐ąŠčģąŠąČąĖ ą┐ąŠ čüą▓ąŠąĖą╝ čäčāąĮą║čåąĖčÅą╝.

ą×ą▒čŖąĄą║čéčŗ, ą║ąŠč鹊čĆčŗąĄ čüąŠąĘą┤ą░čÄčé rich client, ąŠčüąĮąŠą▓ą░ąĮčŗ ą│ą╗ą░ą▓ąĮčŗą╝ ąŠą▒čĆą░ąĘąŠą╝ ąĮą░ DependencyObject ą▓ čüą╗čāčćą░ąĄ ą┐čĆąĖą╝ąĄąĮąĄąĮąĖčÅ WPF, ąĖą╗ąĖ ąĮą░ Control ą▓ čüą╗čāčćą░ąĄ Windows Forms. ąŁčéąĖ ąŠą▒čŖąĄą║čéčŗ ąĖą╝ąĄčÄčé čĆąŠą┤čüčéą▓ąĄąĮąĮąŠčüčéčī ą┐ąŠč鹊ą║ąŠą▓. ąŁč鹊 ąŠąĘąĮą░čćą░ąĄčé, čćč鹊 č鹊ą╗čīą║ąŠ ą┐ąŠč鹊ą║, ą║ąŠč鹊čĆčŗą╣ ą║ąŠč鹊čĆčŗą╣ ąŠą▒čŖąĄą║čé ąĖąĮčüčéą░ąĮčåąĖčĆčāąĄčé, ą╝ąŠąČąĄčé ą▓ą┐ąŠčüą╗ąĄą┤čüčéą▓ąĖąĖ ą┐ąŠą╗čāčćąĖčéčī ą┤ąŠčüčéčāą┐ ą║ ąĄą│ąŠ čćą╗ąĄąĮą░ą╝. ąØą░čĆčāčłąĄąĮąĖąĄ ą┐čĆą░ą▓ąĖą╗ą░ ą┐čĆąĖą▓ąĄą┤ąĄčé ą╗ąĖą▒ąŠ ą║ ąĮąĄ ą┐čĆąĄą┤čüą║ą░ąĘčāąĄą╝ąŠą╝čā ą┐ąŠą▓ąĄą┤ąĄąĮąĖčÄ, ą╗ąĖą▒ąŠ ą║ ą▓čŗą▒čĆąŠčüčā ąĖčüą║ą╗čÄč湥ąĮąĖčÅ.

ą¤ąŠą╗ąŠąČąĖč鹥ą╗čīąĮąŠ č鹊, čćč鹊 ąÆą░ą╝ ąĮąĄ ąĮčāąČąĮąŠ ą┤ąĄą╗ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą▓ąŠą║čĆčāą│ ą┤ąŠčüčéčāą┐ą░ ą║ ąŠą▒čŖąĄą║čéčā UI. ąØąĄą┤ąŠčüčéą░č鹊ą║ ąČąĄ ą▓ č鹊ą╝, čćč鹊 ąĄčüą╗ąĖ ąĮčāąČąĮąŠ ą▓čŗąĘą▓ą░čéčī čćą╗ąĄąĮ ąŠą▒čŖąĄą║čéą░ X, ą║ąŠč鹊čĆčŗą╣ ą▒čŗą╗ čüąŠąĘą┤ą░ąĮ ą┤čĆčāą│ąĖą╝ ą┐ąŠč鹊ą║ąŠą╝ Y, č鹊 ąÆčŗ ą┤ąŠą╗ąČąĮčŗ ą┐ąĄčĆąĄąĮą░ą┐čĆą░ą▓ąĖčéčī (marshal) ąĘą░ą┐čĆąŠčü ąĮą░ ą▓čŗąĘąŠą▓ ąŠą▒čŖąĄą║čéčā Y. ąÆčŗ čÅą▓ąĮąŠ ą╝ąŠąČąĄč鹥 ą┤ąĄą╗ą░čéčī čŹč鹊 čüą╗ąĄą┤čāčÄčēąĖą╝ ąŠą▒čĆą░ąĘąŠą╝:

ŌĆó ąÆ WPF ą▓čŗąĘąŠą▓ąĖč鹥 Invoke ąĖą╗ąĖ BeginInvoke ąĮą░ 菹╗ąĄą╝ąĄąĮč鹥 ąŠą▒čŖąĄą║čéą░ Dispatcher.

ŌĆó ąÆ Windows Forms ą▓čŗąĘąŠą▓ąĖč鹥 Invoke ąĖą╗ąĖ BeginInvoke ąĮą░ 菹╗ąĄą╝ąĄąĮč鹥 čāą┐čĆą░ą▓ą╗ąĄąĮąĖčÅ (control).

Invoke ąĖ BeginInvoke ąŠą▒ą░ ą┐čĆąĖąĮąĖą╝ą░čÄčé ą┤ąĄą╗ąĄą│ą░čéą░, ą║ąŠč鹊čĆčŗą╣ ąŠą▒čĆą░čēą░ąĄčéčüčÅ ą║ ą╝ąĄč鹊ą┤čā ąĮą░ čåąĄą╗ąĄą▓ąŠą╝ 菹╗ąĄą╝ąĄąĮč鹥 čāą┐čĆą░ą▓ą╗ąĄąĮąĖčÅ, ą║ąŠč鹊čĆčŗą╣ ąÆčŗ čģąŠčéąĖč鹥 ąĘą░ą┐čāčüčéąĖčéčī. Invoke čĆą░ą▒ąŠčéą░ąĄčé čüąĖąĮčģčĆąŠąĮąĮąŠ: ą▓čŗąĘčŗą▓ą░čÄčēąĖą╣ ą║ąŠą┤ ą▒ą╗ąŠą║ąĖčĆčāąĄčéčüčÅ, ą┐ąŠą║ą░ ą┐ąĄčĆąĄąĮą░ą┐čĆą░ą▓ą╗ąĄąĮąĖąĄ (marshal) ąĮąĄ ąĘą░ą▓ąĄčĆčłąĖčéčüčÅ. BeginInvoke čĆą░ą▒ąŠčéą░ąĄčé ą░čüąĖąĮčģčĆąŠąĮąĮąŠ: ą▓čŗąĘą▓ą░ą▓čłąĖą╣ ąĄą│ąŠ ą║ąŠą┤ ąĮąĄą╝ąĄą┤ą╗ąĄąĮąĮąŠ ą┐ąŠą╗čāčćą░ąĄčé ąŠą▒čĆą░čéąĮąŠ čāą┐čĆą░ą▓ą╗ąĄąĮąĖąĄ, ąĖ ą╝ą░čĆčłą░ą╗ąĖčĆąŠą▓ą░ąĮąĮčŗą╣ ąĘą░ą┐čĆąŠčü čüčéą░ą▓ąĖčéčüčÅ ą▓ ąŠč湥čĆąĄą┤čī (čü ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄą╝ č鹊ą╣ ąČąĄ čüą░ą╝ąŠą╣ ąŠč湥čĆąĄą┤ąĖ čüąŠąŠą▒čēąĄąĮąĖą╣, ą║ąŠč鹊čĆą░čÅ ą┐ąŠą┤ą┤ąĄčƹȹĖą▓ą░ąĄčé čüąŠą▒čŗčéąĖčÅ ą║ą╗ą░ą▓ąĖą░čéčāčĆčŗ, ą╝čŗčłąĖ ąĖ čéą░ą╣ą╝ąĄčĆą░).

ą¤čĆąĄą┤ą┐ąŠą╗ąŠąČąĖą╝, čćč鹊 čā ąĮą░čü ąĄčüčéčī ąŠą║ąĮąŠ, ą║ąŠč鹊čĆąŠąĄ čüąŠą┤ąĄčƹȹĖčé č鹥ą║čüč鹊ą▓ąŠąĄ ą┐ąŠą╗ąĄ ą▓ą▓ąŠą┤ą░ (text box) čü ąĖą╝ąĄąĮąĄą╝ txtMessage, čüąŠą┤ąĄčƹȹĖą╝ąŠąĄ ą║ąŠč鹊čĆąŠą│ąŠ ą╝čŗ čģąŠčéąĖą╝ ąŠą▒ąĮąŠą▓ą╗čÅčéčī čĆą░ą▒ąŠčćąĖą╝ ą┐ąŠč鹊ą║ąŠą╝. ąÆąŠčé ą┐čĆąĖą╝ąĄčĆ ą┤ą╗čÅ WPF:

public partial class MyWindow : Window

{

public MyWindow()

{

InitializeComponent();

new Thread (Work).Start();

}

void Work()

{

Thread.Sleep (5000); // ąĪąĖą╝čāą╗čÅčåąĖčÅ ąĖąĮč鹥ąĮčüąĖą▓ąĮčŗčģ ą▓čŗčćąĖčüą╗ąĄąĮąĖą╣

UpdateMessage ("The answer");

}

void UpdateMessage (string message)

{

Action action = () => txtMessage.Text = message;

Dispatcher.Invoke (action);

}

}

ą¤ąŠą┤ąŠą▒ąĮčŗą╣ ą║ąŠą┤ ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ ą┤ą╗čÅ Windows Forms, ąĘą░ ąĖčüą║ą╗čÄč湥ąĮąĖąĄą╝ čćč鹊 ą╝čŗ ą▓ą╝ąĄčüč鹊 Dispatcher.Invoke ą▓čŗąĘąŠą▓ąĄą╝ ą╝ąĄč鹊ą┤ Invoke (ą┐čĆąĖąĮą░ą┤ą╗ąĄąČą░čēąĖą╣ ą║ą╗ą░čüčüčā č乊čĆą╝čŗ Form):

void UpdateMessage (string message)

{

Action action = () => txtMessage.Text = message;

this.Invoke (action);

}

Framework ą┐čĆąĄą┤ąŠčüčéą░ą▓ą╗čÅąĄčé ą┤ą▓ąĄ ą║ąŠąĮčüčéčĆčāą║čåąĖąĖ ą┤ą╗čÅ čāą┐čĆąŠčēąĄąĮąĖčÅ čŹč鹊ą│ąŠ ą┐čĆąŠčåąĄčüčüą░:

ŌĆó BackgroundWorker [16]

ŌĆó ą¤čĆąŠą┤ąŠą╗ąČąĄąĮąĖčÅ ą┤ą╗čÅ Task [17]

ąĀą░ą▒ąŠčćąĖąĄ ą┐ąŠč鹊ą║ąĖ ą┐čĆąŠčéąĖą▓ ą┐ąŠč鹊ą║ąŠą▓ UI. ą¤ąŠą╗ąĄąĘąĮąŠ ą┤čāą╝ą░čéčī ąŠ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅčģ rich client, čćč鹊 ąŠąĮąĖ ąĖą╝ąĄčÄčé ą┤ą▓ąĄ ą║ą░č鹥ą│ąŠčĆąĖąĖ ą┐ąŠč鹊ą║ąŠą▓: ą┐ąŠč鹊ą║ąĖ ą│čĆą░čäąĖč湥čüą║ąŠą│ąŠ ąĖąĮč鹥čĆč乥ą╣čüą░ ą┐ąŠą╗čīąĘąŠą▓ą░č鹥ą╗čÅ (UI threads) ąĖ čĆą░ą▒ąŠčćąĖąĄ ą┐ąŠč鹊ą║ąĖ (worker threads). ą¤ąŠč鹊ą║ąĖ UI ąĖąĮčüčéą░ąĮčåąĖčĆčāčÄčé (ąĖ ą▓ą┐ąŠčüą╗ąĄą┤čüčéą▓ąĖąĖ "ą▓ą╗ą░ą┤ąĄčÄčé") 菹╗ąĄą╝ąĄąĮčéą░ą╝ąĖ ą│čĆą░čäąĖč湥čüą║ąŠą│ąŠ ąĖąĮč鹥čĆč乥ą╣čüą░ UI; čĆą░ą▒ąŠčćąĖąĄ ą┐ąŠč鹊ą║ąĖ ąĮąĄ ąĖąĮčüčéą░ąĮčåąĖčĆčāčÄčé ąĖ ąĮąĄ ą▓ą╗ą░ą┤ąĄčÄčé 菹╗ąĄą╝ąĄąĮčéą░ą╝ąĖ UI. Worker-ą┐ąŠč鹊ą║ąĖ ąŠą▒čŗčćąĮąŠ ą▓čŗą┐ąŠą╗ąĮčÅčÄčé ą┤ą╗ąĖąĮąĮčŗąĄ ą▓čŗčćąĖčüą╗ąĄąĮąĖčÅ, čéą░ą║ąĖąĄ ą║ą░ą║ ą▓čŗą▒ąŠčĆą║ą░/ą┐ąŠą╗čāč湥ąĮąĖąĄ ą┤ą░ąĮąĮčŗčģ (ąĄčüą╗ąĖ ą▒čŗ čŹčéąĖ ą▓čŗčćąĖčüą╗ąĄąĮąĖčÅ ą▒čŗą╗ąĖ ą║ąŠčĆąŠčéą║ąĖą╝ąĖ, č鹊 ąĮą░ą┤ąŠą▒ąĮąŠčüčéąĖ ą▓ čĆą░ą▒ąŠčćąĖčģ ą┐ąŠč鹊ą║ą░čģ ąĮąĄ ą▒čŗą╗ąŠ ą▒čŗ).

ąæąŠą╗čīčłąĖąĮčüčéą▓ąŠ ą┐čĆąĖą╗ąŠąČąĄąĮąĖą╣ rich client ąĖą╝ąĄčÄčé ąŠą┤ąĖąĮ ą┐ąŠč鹊ą║ UI (ą║ąŠč鹊čĆčŗą╣ čéą░ą║ąČąĄ čÅą▓ą╗čÅąĄčéčüčÅ ą│ą╗ą░ą▓ąĮčŗą╝ ą┐ąŠč鹊ą║ąŠą╝ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ) ąĖ čŹč鹊čé ą┐ąŠč鹊ą║ ą┐ąĄčĆąĖąŠą┤ąĖč湥čüą║ąĖ ą┐ąŠčĆąŠąČą┤ą░ąĄčé čĆą░ą▒ąŠčćąĖąĄ ą┐ąŠč鹊ą║ąĖ - ą╗ąĖą▒ąŠ ąĮą░ą┐čĆčÅą╝čāčÄ, ą╗ąĖą▒ąŠ čü ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖąĄą╝ ą║ą╗ą░čüčüą░ BackgroundWorker [16]. ąŁčéąĖ čĆą░ą▒ąŠčćąĖąĄ ą┐ąŠč鹊ą║ąĖ ą╝ą░čĆčłą░ą╗ąĖčĆčāčÄčé čüą▓ąŠąĖ ąŠą▒čĆą░čēąĄąĮąĖčÅ ąŠą▒čĆą░čéąĮąŠ ą▓ ą│ą╗ą░ą▓ąĮčŗą╣ ą┐ąŠč鹊ą║ UI, čćč鹊ą▒čŗ ąŠą▒ąĮąŠą▓ą╗čÅčéčī čüąŠčüč鹊čÅąĮąĖąĄ ąŠčĆą│ą░ąĮąŠą▓ čāą┐čĆą░ą▓ą╗ąĄąĮąĖčÅ ąĖą╗ąĖ čćč鹊ą▒čŗ čüąŠąŠą▒čēą░čéčī ąŠ ą┐čĆąŠą│čĆąĄčüčüąĄ ą▓čŗą┐ąŠą╗ąĮąĄąĮąĖčÅ ąŠą┐ąĄčĆą░čåąĖąĖ.

ąśčéą░ą║, ą║ąŠą│ą┤ą░ čā ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĮąĄčüą║ąŠą╗čīą║ąŠ ą┐ąŠč鹊ą║ąŠą▓ UI? ą×čüąĮąŠą▓ąĮąŠą╣ čéą░ą║ąŠą╣ čüčåąĄąĮą░čĆąĖą╣ ą▓ąŠąĘąĮąĖą║ą░ąĄčé, ą║ąŠą│ą┤ą░ čā ąÆą░čü ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĄ čü ąĮąĄčüą║ąŠą╗čīą║ąĖą╝ąĖ ąŠą║ąĮą░ą╝ąĖ ą▓ąĄčĆčģąĮąĄą│ąŠ čāčĆąŠą▓ąĮčÅ, čćč鹊 čćą░čüč鹊 ąĮą░ąĘčŗą▓ą░čÄčé ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĄą╝ Single Document Interface (SDI); ą┐čĆąĖą╝ąĄčĆ čéą░ą║ąŠą│ąŠ ą┐čĆąĖą╗ąŠąČąĄąĮąĖčÅ Microsoft Word. ąÜą░ąČą┤ąŠąĄ ąŠą║ąĮąŠ SDI ąŠą▒čŗčćąĮąŠ ą┐ąŠą║ą░ąĘčŗą▓ą░ąĄčé čüą░ą╝ąŠ čüąĄą▒čÅ ą║ą░ą║ ąŠčéą┤ąĄą╗čīąĮąŠąĄ "ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĄ" ąĮą░ ą┐ą░ąĮąĄą╗ąĖ ąĘą░ą┤ą░čć, ąĖ čćą░čüč鹊 čĆą░ą▒ąŠčéą░ąĄčé čäčāąĮą║čåąĖąŠąĮą░ą╗čīąĮąŠ ąĖąĘąŠą╗ąĖčĆąŠą▓ą░ąĮąĮąŠ ąŠčé ą┤čĆčāą│ąĖčģ ąŠą║ąŠąĮ SDI. ą¤čāč鹥ą╝ ąĮą░ąĘąĮą░č湥ąĮąĖčÅ ą║ą░ąČą┤ąŠą╝čā čéą░ą║ąŠą╝čā ąŠą║ąĮčā čüą▓ąŠąĄą│ąŠ čüąŠą▒čüčéą▓ąĄąĮąĮąŠą│ąŠ ą┐ąŠč鹊ą║ą░ UI, ą┐čĆąĖą╗ąŠąČąĄąĮąĖąĄ ą╝ąŠąČąĄčé ą▒ąŠą╗ąĄąĄ ąŠčéąĘčŗą▓čćąĖą▓čŗą╝.

Immutable-ąŠą▒čŖąĄą║čéčŗ. ąØąĄ ą╝čāčéąĖčĆčāąĄą╝čŗą╣ (immutable) ąŠą▒čŖąĄą║čé čŹč鹊 čéą░ą║ąŠą╣ ąŠą▒čŖąĄą║čé, ą║ąŠč鹊čĆčŗą╣ ąĮąĄą╗čīąĘčÅ ąĖąĘą╝ąĄąĮąĖčéčī - čüąĮą░čĆčāąČąĖ ąĖą╗ąĖ ą▓ąĮčāčéčĆąĖ. ą¤ąŠą╗čÅ immutable-ąŠą▒čŖąĄą║čéą░ ąŠą▒čŗčćąĮąŠ ą┤ąĄą║ą╗ą░čĆąĖčĆčāčÄčéčüčÅ ą║ą░ą║ read-only, ąĖ ąŠąĮąĖ ą┐ąŠą╗ąĮąŠčüčéčīčÄ ąĖąĮąĖčåąĖą░ą╗ąĖąĘąĖčĆčāčÄčéčüčÅ ą▓ ą╝ąŠą╝ąĄąĮčé ą║ąŠąĮčüčéčĆčāąĖčĆąŠą▓ą░ąĮąĖčÅ ąŠą▒čŖąĄą║čéą░.

ąØąĄą╝čāčéąĖčĆčāąĄą╝ąŠčüčéčī čŹč鹊 ą┐čĆąĖąĘąĮą░ą║ čäčāąĮą║čåąĖąŠąĮą░ą╗čīąĮąŠą│ąŠ ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčĆąŠą▓ą░ąĮąĖčÅ, ą│ą┤ąĄ ą▓ą╝ąĄčüč鹊 ą╝čāčéąĖčĆąŠą▓ą░ąĮąĖčÅ ąŠą▒čŖąĄą║čéą░ ąÆčŗ čüąŠąĘą┤ą░ąĄč鹥 ąĮąŠą▓čŗą╣ ąŠą▒čŖąĄą║čé čü ą┤čĆčāą│ąĖą╝ąĖ čüą▓ąŠą╣čüčéą▓ą░ą╝ąĖ. LINQ čüą╗ąĄą┤čāąĄčé čŹč鹊ą╣ ą┐ą░čĆą░ą┤ąĖą│ą╝ąĄ. ąØąĄą╝čāčéąĖčĆčāąĄą╝ąŠčüčéčī čéą░ą║ąČąĄ ą▓ą░ąČąĮą░ ą▓ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ, čćč鹊ą▒čŗ ąĖąĘą▒ąĄąČą░čéčī ą┐čĆąŠą▒ą╗ąĄą╝ čü ąŠą▒čēąĖą╝ ąĘą░ą┐ąĖčüčŗą▓ą░ąĄą╝čŗą╝ čüąŠčüč鹊čÅąĮąĖąĄą╝ - ą┐čāč鹥ą╝ čāčüčéčĆą░ąĮąĄąĮąĖčÅ (ąĖą╗ąĖ ą╝ąĖąĮąĖą╝ąĖąĘą░čåąĖąĖ) ąĘą░ą┐ąĖčüčŗą▓ą░ąĄą╝čŗčģ ą┤ą░ąĮąĮčŗčģ.

ą×ą┤ąĖąĮ ąĖąĘ čłą░ą▒ą╗ąŠąĮąŠą▓ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ąĮąĄą╝čāčéąĖčĆčāąĄą╝čŗčģ ąŠą▒čŖąĄą║č鹊ą▓ - ąĖąĮą║ą░ą┐čüčāą╗čÅčåąĖčÅ ą│čĆčāą┐ą┐čŗ čüą▓čÅąĘą░ąĮąĮčŗčģ ą┐ąŠą╗ąĄą╣ ą┤ą╗čÅ ą╝ąĖąĮąĖą╝ąĖąĘą░čåąĖąĖ ąĘą░ą┤ąĄčƹȹĄą║ ą▒ą╗ąŠą║ąĖčĆąŠą▓ąŠą║. ą¦č鹊ą▒čŗ ą┐čĆąĖą▓ąĄčüčéąĖ ą┐čĆąŠčüč鹊ą╣ ą┐čĆąĖą╝ąĄčĆ, ą┐čĆąĄą┤ą┐ąŠą╗ąŠąČąĖą╝, čćč鹊 čā ąĮą░čü ąĄčüčéčī ą┤ą▓ą░ ą┐ąŠą╗čÅ, ąĖ ą╝čŗ čģąŠčéąĖą╝ čćąĖčéą░čéčī/ąĘą░ą┐ąĖčüčŗą▓ą░čéčī čŹčéąĖ ą┐ąŠą╗čÅ ą░č鹊ą╝ą░čĆąĮąŠ:

int _percentComplete;string _statusMessage;

ąÆą╝ąĄčüč鹊 č鹊ą│ąŠ, čćč鹊ą▒čŗ čĆąĄą░ą╗ąĖąĘąŠą▓ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā ą▓ąŠą║čĆčāą│ čŹčéąĖčģ ą┐ąŠą╗ąĄą╣, ą╝čŗ ą╝ąŠą│ą╗ąĖ ą▒čŗ ąŠą┐čĆąĄą┤ąĄą╗ąĖčéčī čüą╗ąĄą┤čāčÄčēąĖą╣ immutable-ą║ą╗ą░čüčü:

class ProgressStatus // ą¤čĆąĄą┤čüčéą░ą▓ą╗čÅąĄčé ą┐čĆąŠą│čĆąĄčüčü ą║ą░ą║ąŠą╣-č鹊 ą░ą║čéąĖą▓ąĮąŠčüčéąĖ

{

public readonly int PercentComplete;

public readonly string StatusMessage;

// ąŻ čŹč鹊ą│ąŠ ą║ą╗ą░čüčüą░ ą╝ąŠąČąĄčé ą▒čŗčéčī ąĮą░ą╝ąĮąŠą│ąŠ ą▒ąŠą╗čīčłąĄ ą┐ąŠą╗ąĄą╣...

public ProgressStatus (int percentComplete, string statusMessage)

{

PercentComplete = percentComplete;

StatusMessage = statusMessage;

}

}

ąóąŠą│ą┤ą░ ą╝čŗ ą╝ąŠą│ą╗ąĖ ą▒čŗ ąŠą┐čĆąĄą┤ąĄą╗ąĖčéčī ąŠą┤ąĮąŠ ą┐ąŠą╗ąĄ čéą░ą║ąŠą│ąŠ čéąĖą┐ą░ ąĮą░ ąŠą▒čŖąĄą║č鹥 ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ:

readonly object _statusLocker = new object();

ProgressStatus _status;

ąóąĄą┐ąĄčĆčī ą╝čŗ ą╝ąŠąČąĄą╝ čćąĖčéą░čéčī/ąĘą░ą┐ąĖčüčŗą▓ą░čéčī ąĘąĮą░č湥ąĮąĖčÅ čéą░ą║ąŠą│ąŠ čéąĖą┐ą░ ą▒ąĄąĘ čāą┤ąĄčƹȹ░ąĮąĖčÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą┤ą╗čÅ ą▒ąŠą╗čīčłąĄą│ąŠ ą║ąŠą╗ąĖč湥čüčéą▓ą░ ą┐čĆąĖčüą▓ą░ąĖą▓ą░ąĮąĖą╣, č湥ą╝ ąŠą┤ąĮąŠ:

var status = new ProgressStatus (50, "ąĀą░ą▒ąŠčéą░ąĄą╝ čü čŹčéąĖą╝");

// ą¤čĆąĄą┤čüčéą░ą▓ąĖą╝, čćč鹊 ą╝čŗ ą┐čĆąĖčüą▓ą░ąĖą▓ą░ąĄą╝ ąĄčēąĄ ą╝ąĮąŠą│ąŠ ą┐ąŠą╗ąĄą╣...

// ...

lock (_statusLocker) _status = status; // ą×č湥ąĮčī ą║čĆą░čéą║ą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░

ąöą╗čÅ čćč鹥ąĮąĖčÅ ąŠą▒čŖąĄą║čéą░ čüąĮą░čćą░ą╗ą░ ą┐ąŠą╗čāčćą░ąĄą╝ ą║ąŠą┐ąĖčÄ ąŠą▒čŖąĄą║čéą░ (ą▓ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ). ąŚą░č鹥ą╝ ą╝ąŠąČąĮąŠ ą┐čĆąŠčćąĖčéą░čéčī ąĄą│ąŠ ąĘąĮą░č湥ąĮąĖčÅ ą▒ąĄąĘ ąĮąĄąŠą▒čģąŠą┤ąĖą╝ąŠčüčéąĖ čāą┤ąĄčƹȹĖą▓ą░čéčī ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║čā:

ProgressStatus statusCopy;

lock (_locker ProgressStatus) statusCopy = _status; // ąĪąĮąŠą▓ą░ ą║ąŠčĆąŠčéą║ą░čÅ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░

int pc = statusCopy.PercentComplete;

string msg = statusCopy.StatusMessage;

...

ąóąĄčģąĮąĖč湥čüą║ąĖ ą┐ąŠčüą╗ąĄą┤ąĮąĖąĄ 2 čüčéčĆąŠą║ąĖ ą║ąŠą┤ą░ ą┐ąŠč鹊ą║ąŠą▒ąĄąĘąŠą┐ą░čüąĮčŗ ą▒ą╗ą░ą│ąŠą┤ą░čĆčÅ ą┐čĆąĄą┤čłąĄčüčéą▓čāčÄčēąĄą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĄ, ą▓čŗą┐ąŠą╗ąĮčÅčÄčēąĄą╣ ąĮąĄčÅą▓ąĮčŗą╣ ą▒ą░čĆčīąĄčĆ ą┐ą░ą╝čÅčéąĖ (čüą╝. [7] ą▓ 4 čćą░čüčéąĖ čŹč鹊ą╣ ą┤ąŠą║čāą╝ąĄąĮčéą░čåąĖąĖ).

ą×ą▒čĆą░čéąĖč鹥 ą▓ąĮąĖą╝ą░ąĮąĖąĄ, čćč鹊 čŹč鹊 čüą▓ąŠą▒ąŠą┤ąĮčŗą╣ ąŠčé ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ čüą┐ąŠčüąŠą▒ ąŠą▒ąĄčüą┐ąĄčćąĖčéčī čåąĄą╗ąŠčüčéąĮąŠčüčéčī ą│čĆčāą┐ą┐čŗ čüą▓čÅąĘą░ąĮąĮčŗčģ ą┐ąŠą╗ąĄą╣. ąØąŠ čŹč鹊 ąĮąĄ ą┐čĆąĄą┤ąŠčéą▓čĆą░čéąĖčé ą┤ą░ąĮąĮčŗąĄ ąŠčé ąĖąĘą╝ąĄąĮąĄąĮąĖčÅ, ą║ąŠą│ą┤ą░ ąÆčŗ ą▓ą┐ąŠčüą╗ąĄą┤čüčéą▓ąĖąĖ čĆą░ą▒ąŠčéą░ąĄč鹥 čü ąĮąĖą╝ąĖ - ą┤ą╗čÅ čŹč鹊ą│ąŠ ąŠą▒čŗčćąĮąŠ ąĮčāąČąĮą░ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ą░. ąÆ 5 čćą░čüčéąĖ čŹč鹊ą╣ ą┤ąŠą║čāą╝ąĄąĮčéą░čåąĖąĖ ą╝čŗ čĆą░čüčüą╝ąŠčéčĆąĖą╝ ą▒ąŠą╗čīčłąĄ ą┐čĆąĖą╝ąĄčĆąŠą▓ ąĮąĄą╝čāčéąĖčĆčāąĄą╝ąŠčüčéąĖ ą┤ą╗čÅ čāą┐čĆąŠčēąĄąĮąĖčÅ ą╝ąĮąŠą│ąŠą┐ąŠč鹊čćąĮąŠčüčéąĖ, ą▓ą║ą╗čÄčćą░čÅ PLINQ [13].

ąóą░ą║ąČąĄ ą╝ąŠąČąĮąŠ ą▒ąĄąĘąŠą┐ą░čüąĮąŠ ąĮą░ąĘąĮą░čćąĖčéčī ąĮąŠą▓čŗą╣ ąŠą▒čŖąĄą║čé ProgressStatus ąĮą░ ąŠčüąĮąŠą▓ąĄ ąĄą│ąŠ ą┐čĆąĄą┤čŗą┤čāčēąĄą│ąŠ ąĘąĮą░č湥ąĮąĖčÅ (ąĮą░ą┐čĆąĖą╝ąĄčĆ, ą╝ąŠąČąĮąŠ "ąĖąĮą║čĆąĄą╝ąĄąĮčéąĖčĆąŠą▓ą░čéčī" ąĘąĮą░č湥ąĮąĖąĄ PercentComplete) - ą▒ąĄąĘ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ ą▒ąŠą╗čīčłąĄ ąŠą┤ąĮąŠą╣ čüčéčĆąŠą║ąĖ ą║ąŠą┤ą░. ążą░ą║čéąĖč湥čüą║ąĖ ą╝čŗ ą╝ąŠąČąĄą╝ ą┤ąĄą╗ą░čéčī čŹč鹊 ą▒ąĄąĘ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ ąŠą┤ąĖąĮąŠčćąĮąŠą╣ ą▒ą╗ąŠą║ąĖčĆąŠą▓ą║ąĖ č湥čĆąĄąĘ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ čÅą▓ąĮčŗąĄ ą▒ą░čĆčīąĄčĆąŠą▓ ą┐ą░ą╝čÅčéąĖ Interlocked.CompareExchange ąĖ ąŠąČąĖą┤ą░ąĮąĖąĄ ą▓ čåąĖą║ą╗ąĄ (spin-wait). ąŁč鹊 ą┐čĆąŠą┤ą▓ąĖąĮčāčéą░čÅ č鹥čģąĮąĖą║ą░, ą║ąŠč鹊čĆčāčÄ ą╝čŗ ąŠą┐ąĖčłąĄą╝ ą┐ąŠąĘąČąĄ ą▓ čüąĄą║čåąĖąĖ, ą┐ąŠčüą▓čÅčēąĄąĮąĮąŠą╣ ą┐ą░čĆą░ą╗ą╗ąĄą╗čīąĮąŠą╝čā ą┐čĆąŠą│čĆą░ą╝ą╝ąĖčĆąŠą▓ą░ąĮąĖčÄ [3].

[ąĪąĖą│ąĮą░ą╗ąĖąĘą░čåąĖčÅ čü ąŠą▒čĆą░ą▒ąŠčéą║ąŠą╣ ąŠąČąĖą┤ą░ąĮąĖčÅ čüąŠą▒čŗčéąĖčÅ]

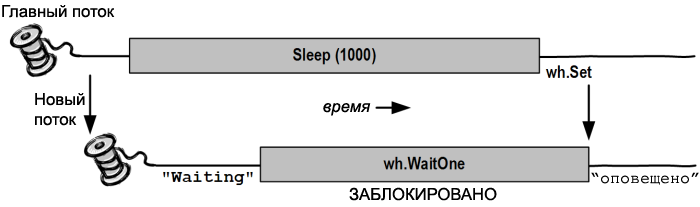

ą×ą▒čĆą░ą▒ąŠčéą║ą░ ąŠąČąĖą┤ą░ąĮąĖčÅ čüąŠą▒čŗčéąĖčÅ (event wait handle) ąĖčüą┐ąŠą╗čīąĘčāąĄčéčüčÅ ą┤ą╗čÅ čüąĖą│ąĮą░ą╗ąĖąĘą░čåąĖąĖ. ąŁč鹊 čüą┐ąŠčüąŠą▒ ąŠą▒ą╝ąĄąĮą░ čüąŠčüč鹊čÅąĮąĖąĄą╝, ą║ąŠą│ą┤ą░ ąŠą┤ąĖąĮ ą┐ąŠč鹊ą║ ąČą┤ąĄčé ą┐ąŠčüčéčāą┐ą╗ąĄąĮąĖčÅ ąŠą┐ąŠą▓ąĄčēąĄąĮąĖčÅ ąŠčé ą┤čĆčāą│ąŠą│ąŠ. Event wait handle čŹč鹊 čüą░ą╝čŗą╣ ą┐čĆąŠčüč鹊ą╣ ą▓ą░čĆąĖą░ąĮčé ą║ąŠąĮčüčéčĆčāą║čåąĖą╣ čüąĖą│ąĮą░ą╗ąĖąĘą░čåąĖąĖ, ąĖ ąŠąĮ ąĮąĄ čüą▓čÅąĘą░ąĮ čü čüąŠą▒čŗčéąĖčÅą╝ąĖ C#. Event wait handle ą┤ąŠčüčéčāą┐ąĮčŗ č湥čĆąĄąĘ čéčĆąĖ čäčāąĮą║čåąĖąĖ: AutoResetEvent, ManualResetEvent ąĖ (ąĖąĘ Framework 4.0) CountdownEvent. ą¤ąĄčĆą▓čŗąĄ ą┤ą▓ą░ ąŠčüąĮąŠą▓ą░ąĮčŗ ąĮą░ ąŠą▒čēąĄą╝ ą║ą╗ą░čüčüąĄ EventWaitHandle ąŠčéą║čāą┤ą░ ąŠąĮąĖ ąĮą░čüą╗ąĄą┤čāčÄčé ą▓ąĄčüčī čüą▓ąŠą╣ čäčāąĮą║čåąĖąŠąĮą░ą╗.

| ąÜąŠąĮčüčéčĆčāą║čåąĖčÅ |

ąØą░ąĘąĮą░č湥ąĮąĖąĄ |

ąĀą░ą▒ąŠčéą░ąĄčé ą╝ąĄąČą┤čā ą┐čĆąŠčåąĄčüčüą░ą╝ąĖ? |

ąŚą░ą│čĆčāąĘą║ą░(*) |

| AutoResetEvent |

ą¤ąŠąĘą▓ąŠą╗čÅąĄčé ą┐ąŠč鹊ą║čā ąŠą┤ąĮąŠą║čĆą░čéąĮąŠ čĆą░ąĘą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčīčüčÅ, ą║ąŠą│ą┤ą░ ą▒čāą┤ąĄčé ą┐ąŠą╗čāč湥ąĮ čüąĖą│ąĮą░ą╗ ąŠčé ą┤čĆčāą│ąŠą│ąŠ ą┐ąŠč鹊ą║ą░. |

ąöąÉ |

1000 ąĮčü |

| ManualResetEvent |

ą¤ąŠąĘą▓ąŠą╗čÅąĄčé ą┐ąŠč鹊ą║čā čĆą░ąĘą▒ą╗ąŠą║ąĖčĆąŠą▓ą░čéčīčüčÅ ąĮą░ą▓čüąĄą│ą┤ą░, ą║ąŠą│ą┤ą░ ąŠąĮ ą┐ąŠą╗čāčćąĖą╗ čüąĖą│ąĮą░ą╗ ąŠčé ą┤čĆčāą│ąŠą│ąŠ ą┐ąŠč鹊ą║ą░ (ą┤ąŠ čüą▒čĆąŠčüą░). |