|

ąśąĮąŠą│ą┤ą░ ą▒čŗą▓ą░ąĄčé ąĮčāąČąĮąŠ čüą║ą░čćą░čéčī ą▓ąĄčüčī čüą░ą╣čé čåąĄą╗ąĖą║ąŠą╝, čćč鹊ą▒čŗ ą▒čŗčüčéčĆąĄąĄ ąĖ čāą┤ąŠą▒ąĮąĄąĄ ąĖąĘčāčćąĖčéčī ąĄą│ąŠ čüčéčĆčāą║čéčāčĆčā ąĖ čüąŠą┤ąĄčƹȹ░ąĮąĖąĄ. ąöą╗čÅ čŹč鹊ą│ąŠ ąĄčüčéčī čüą┐ąĄčåąĖą░ą╗čīąĮčŗąĄ ąĖąĮčüčéčĆčāą╝ąĄąĮčéčŗ, ą║ąŠč鹊čĆčŗąĄ čĆą░čüčüą╝ąŠčéčĆąĄąĮčŗ ą▓ čŹč鹊ą╣ čüčéą░čéčīąĄ.

[HTTrack Website Copier]

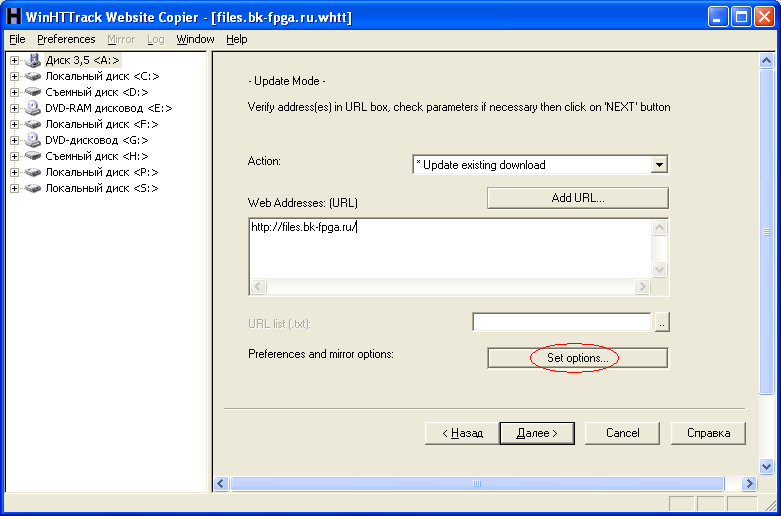

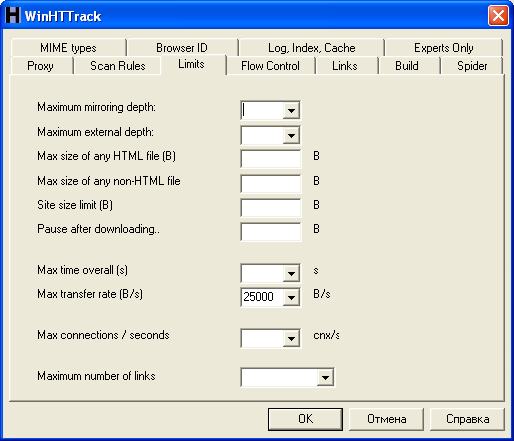

ąæąĄčüą┐ą╗ą░čéąĮą░čÅ ą┐čĆąŠą│čĆą░ą╝ą╝ą░ čü GUI-ąĖąĮč鹥čĆč乥ą╣čüąŠą╝ [1], ąŠč湥ąĮčī čāą┤ąŠą▒ąĮą░čÅ ą┤ą╗čÅ ą▒ąŠą╗čīčłąĖąĮčüčéą▓ą░ čüą╗čāčćą░ąĄą▓. ąÜąŠą┐ąĖčĆčāąĄčé čüą░ą╣čé čåąĄą╗ąĖą║ąŠą╝ čü ąĮčāąČąĮąŠą╣ ą│ą╗čāą▒ąĖąĮąŠą╣ čüčüčŗą╗ąŠą║, ą▓čüąĄ čüčüčŗą╗ą║ąĖ ą░ą▓č鹊ą╝ą░čéąĖč湥čüą║ąĖ ąĖčüą┐čĆą░ą▓ą╗čÅčÄčéčüčÅ ąĮą░ ą╗ąŠą║ą░ą╗čīąĮčŗąĄ, čéą░ą║ čćč鹊 ą┐ąŠčüą╗ąĄ ąĘą░ą║ą░čćą║ąĖ čüą░ą╣čéą░ ąĮąĄ ąĮčāąČąĮąŠ ą┤ą░ąČąĄ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖąĄ ą║ ąśąĮč鹥čĆąĮąĄčéčā. ąŚą░ą║ą░čćą║ą░ čüąŠąĘą┤ą░ąĄčéčüčÅ ąŠč湥ąĮčī ą┐čĆąŠčüč鹊 - ą┤ąŠčüčéą░č鹊čćąĮąŠ čāą║ą░ąĘą░čéčī č鹊ą╗čīą║ąŠ ąĖą╝čÅ ą┐čĆąŠąĄą║čéą░, ą║ąŠčĆąĮąĄą▓čāčÄ čüčüčŗą╗ą║čā ąĮą░ čüą░ą╣čé, ąĖ ą▓čüąĄ ąŠčüčéą░ą╗čīąĮčŗąĄ ąŠą┐čåąĖąĖ ąŠčüčéą░ą▓ąĖčéčī ą┐ąŠ čāą╝ąŠą╗čćą░ąĮąĖčÄ. ąĢčüą╗ąĖ ąČąĄ ąĮčāąČąĮąŠ ą▓ą▓ąĄčüčéąĖ ąŠą│čĆą░ąĮąĖč湥ąĮąĖčÅ (ąĮą░ ą│ą╗čāą▒ąĖąĮčā ą┐čĆąŠčüą╝ąŠčéčĆą░ čüą░ą╣čéą░, ąĮą░ ąŠą▒čŖąĄą╝ ąĘą░ą║ą░čćą░ąĮąĮčŗčģ čäą░ą╣ą╗ąŠą▓) ąĖą╗ąĖ ąĘą░ą┤ą░čéčī ą┤čĆčāą│ąĖąĄ ąŠą┐čåąĖąĖ, č鹊 ąĮą░čüčéčĆąŠą╣č鹥 ąŠą┐čåąĖąĖ ą┐čĆąŠąĄą║čéą░ (ą║ąĮąŠą┐ą║ą░ Set options...). ą×čüąĮąŠą▓ąĮčŗąĄ ąĮą░čüčéčĆąŠą╣ą║ąĖ čĆą░čüą┐ąŠą╗ąŠąČąĄąĮčŗ ąĮą░ ąĘą░ą║ą╗ą░ą┤ą║ą░čģ Scan Rules ąĖ Limits.

|

|

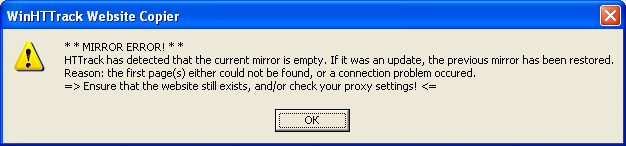

ąĢčüą╗ąĖ ąĮą░ čüą░ą╣č鹥 ąĮąĄčé čäą░ą╣ą╗ą░ čüčéčĆą░ąĮąĖčćą║ąĖ ą┐ąŠ čāą╝ąŠą╗čćą░ąĮąĖčÄ index.html (index.html, index.php, default.html, ...), č鹊 WinHTTrack Website Copier ą▓čŗą┤ą░čüčé ąŠčłąĖą▒ą║čā "** MIRROR ERROR! ** HTTrack has detected that the current mirror is empty. If it was an update, the previous mirror has been restored." ąŁč鹊 ą┐čĆąŠąĖčüčģąŠą┤ąĖčé ąĮą░ čüą░ą╣čéą░čģ, ą║ąŠč鹊čĆčŗąĄ ąŠčĆą│ą░ąĮąĖąĘąŠą▓ą░ąĮčŗ ą┐čĆąŠčüč鹊 ą║ą░ą║ čģčĆą░ąĮąĖą╗ąĖčēąĄ čäą░ą╣ą╗ąŠą▓ ąĖ ą┐ą░ą┐ąŠą║, ąĖ ąĮą░ čüąĄčĆą▓ąĄčĆąĄ čĆą░ąĘčĆąĄčłąĄąĮą░ ąŠą┐čåąĖčÅ ą┐čĆąŠčüą╝ąŠčéčĆą░ ą┤ąĖčĆąĄą║č鹊čĆąĖą╣ (Directory Browsing). ąóą░ą║ąĖąĄ čüą╗čāčćą░ąĖ čĆąĄą┤ą║ąĖ (ą┐čĆąŠčüą╝ąŠčéčĆ ą┤ąĖčĆąĄą║č鹊čĆąĖą╣ WWW čüąĄčĆą▓ąĄčĆą░ ąŠą▒čŗčćąĮąŠ ąĘą░čēąĖčēą░čÄčé ą▓ čåąĄą╗čÅčģ ą▒ąĄąĘąŠą┐ą░čüąĮąŠčüčéąĖ), ąĮąŠ ą▓čüąĄ ąČąĄ ą▒čŗą▓ą░čÄčé.

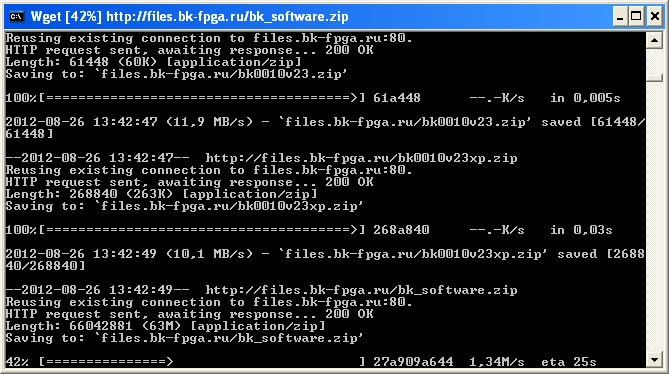

ą¤ąŠą╝ąŠčćčī ą▓ čŹč鹊ą╝ čüą╗čāčćą░ąĄ ą╝ąŠąČąĄčé wget, ą║ąŠč鹊čĆčŗą╣ čüą║ą░čćąĖą▓ą░ąĄčé ą▓čüčÄ čüčéčĆčāą║čéčāčĆčā ą▓ąĖą┤ąĖą╝čŗčģ ą║ą░čéą░ą╗ąŠą│ąŠą▓ ąĖ čäą░ą╣ą╗ąŠą▓ ą┐ąŠ čüčüčŗą╗ą║ąĄ, ąĮąĄ ąŠą▒čĆą░čēą░čÅ ą▓ąĮąĖą╝ą░ąĮąĖčÅ ąĮą░ ąĮą░ą╗ąĖčćąĖąĄ čäą░ą╣ą╗ą░ index.html.

[Wget for Windows]

ąŻčéąĖą╗ąĖčéą░ ą║ąŠą╝ą░ąĮą┤ąĮąŠą╣ čüčéčĆąŠą║ąĖ wget ąĖąĘąĮą░čćą░ą╗čīąĮąŠ ą▒čŗą╗ą░ čĆą░ąĘčĆą░ą▒ąŠčéą░ąĮą░ ą┐ąŠą┤ xNIX (Linux), ąĮąŠ č鹥ą┐ąĄčĆčī ąĄčüčéčī ą┤ąŠčüčéčāą┐ąĮčŗą╣ ą┐ąŠčĆčé wget ą┤ą╗čÅ Windows [2]. ąĪ ą┐ąŠą╝ąŠčēčīčÄ wget ą╝ąŠąČąĮąŠ ąĘą░ą║ą░čćąĖą▓ą░čéčī ą║ą░ą║ ąŠčéą┤ąĄą╗čīąĮčŗąĄ čäą░ą╣ą╗čŗ, čéą░ą║ ąĖ ą┤ąĄą╗ą░čéčī ą┐ąŠą╗ąĮąŠąĄ ąĘąĄčĆą║ą░ą╗ąŠ čüą░ą╣čéą░ čåąĄą╗ąĖą║ąŠą╝. ąŻčüčéą░ąĮąŠą▓ąĖčéčī wget ą┐ąŠą┤ Windows ą┤ąŠą▓ąŠą╗čīąĮąŠ ą┐čĆąŠčüč鹊, ą┐čĆąŠčåąĄčüčü ą┐ąŠ čłą░ą│ą░ą╝ (ą▓čüąĄ čüčüčŗą╗ą║ąĖ ąĮą░ ąĘą░ą║ą░čćą║čā čüą╝. ą▓ [2]):

1. ąĪą║ą░čćą░čéčī ąĖ čāčüčéą░ąĮąŠą▓ąĖčéčī sed-4.2.1-setup.exe.

2. ąĪą║ą░čćą░čéčī wget-1.11.4-1-bin.zip, čĆą░čüą┐ą░ą║ąŠą▓ą░čéčī ą┐ą░ą┐ą║ąĖ ą▓ ąĮąĄą╝ ą▓ čéčā ąČąĄ čüčéčĆčāą║čéčāčĆčā ą║ą░čéą░ą╗ąŠą│ąŠą▓, ą║ą░ą║ą░čÅ ąĄčüčéčī ą▓ c:\Program Files\GnuWin32\.

3. ąĪą║ą░čćą░čéčī čäą░ą╣ą╗čŗ ąĘą░ą▓ąĖčüąĖą╝ąŠčüč鹥ą╣ (DLL) wget-1.11.4-1-dep.zip (ąĄčüą╗ąĖ ąĖčģ ąĮąĄčé), čĆą░čüą┐ą░ą║ąŠą▓ą░čéčī ą▓ čéčā ąČąĄ čüčéčĆčāą║čéčāčĆčā ą║ą░čéą░ą╗ąŠą│ąŠą▓ ą║ą░ą║ą░čÅ ąĄčüčéčī ą▓ c:\Program Files\GnuWin32\.

4. ąóąĄą┐ąĄčĆčī ą╝ąŠąČąĮąŠ ąĘą░ą┐čāčüčéąĖčéčī wget ąĖąĘ ą║ąŠą╝ą░ąĮą┤ąĮąŠą╣ čüčéčĆąŠą║ąĖ, ą┐ąĄčĆąĄą╣ą┤čÅ ą▓ ą┐ą░ą┐ą║čā c:\Program Files\GnuWin32\bin\ (cmd -> wget.exe).

ą¤čĆąĖą╝ąĄčĆčŗ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÅ wget

wget -m http://microsin.net/

ąÆ čŹč鹊ą╝ ą┐čĆąĖą╝ąĄčĆąĄ ą▒čāą┤ąĄčé ąĘą░ą║ą░čćą░ąĮ čüą░ą╣čé čåąĄą╗ąĖą║ąŠą╝, čü čüąŠčģčĆą░ąĮąĄąĮąĖąĄą╝ ąĮą░ čüčéčĆą░ąĮąĖčåą░čģ ąŠčĆąĖą│ąĖąĮą░ą╗čīąĮčŗčģ čüčüčŗą╗ąŠą║.

ąöčĆčāą│ąŠą╣ ą┐čĆąĖą╝ąĄčĆ ą┐ąŠąĘą▓ąŠą╗čÅąĄčé ąĘą░ą╝ąĄąĮąĖčéčī ą▓čüąĄ čüčüčŗą╗ą║ąĖ ąĮą░ ą╗ąŠą║ą░ą╗čīąĮčŗąĄ, čćč鹊ą▒čŗ ąĮąĄ ąĮčāąČąĮąŠ ą▒čŗą╗ąŠ ąŠą▒čĆą░čēą░čéčīčüčÅ ą║ ąŠčĆąĖą│ąĖąĮą░ą╗čīąĮąŠą╝čā čüą░ą╣čéčā ą┐ąŠ čüčüčŗą╗ą║ą░ą╝:

wget -mk http://microsin.net/

ąöą╗čÅ č鹊ą│ąŠ, čćč鹊ą▒čŗ ąŠą│čĆą░ąĮąĖčćąĖčéčī ąĘą░ą│čĆčāąĘą║čā ą║ą░ąĮą░ą╗ą░ čüąĄč鹥ą▓ąŠą│ąŠ ą┐ąŠą┤ą║ą╗čÄč湥ąĮąĖčÅ ą┐čĆąĖ ąĘą░ą║ą░čćą║ąĄ. ąĢčüą╗ąĖ ąÆčŗ ą▒čāą┤ąĄč鹥 ąĘą░ą║ą░čćąĖą▓ą░čéčī čüą░ą╣čé ą▒ąĄąĘ ąŠą│čĆą░ąĮąĖč湥ąĮąĖą╣, č鹊 ą░ą┤ą╝ąĖąĮąĖčüčéčĆą░č鹊čĆ ą╝ąŠąČąĄčé ąÆą░čü ąŠčéą║ą╗čÄčćąĖčéčī. ą£ąŠąČąĮąŠ ą▓ą▓ąĄčüčéąĖ ą┐ą░čāąĘčā ą╝ąĄąČą┤čā ąĘą░ą║ą░čćą║ą░ą╝ąĖ, ąĮą░ą┐čĆąĖą╝ąĄčĆ ą▓ 20 čüąĄą║čāąĮą┤, č鹊ą│ą┤ą░ ąĘą░ą│čĆčāąĘą║ą░ čü čüą░ą╣čéą░ ą▒čāą┤ąĄčé ą▓čŗą│ą╗čÅą┤ąĄčéčī ąĄčüč鹥čüčéą▓ąĄąĮąĮąŠą╣:

wget -mk -w 20 http://microsin.net/

ą£ąŠąČąĮąŠ ąĘą░ą┤ą░čéčī ą┤čĆčāą│ąŠąĄ čćąĖčüą╗ąŠ, ą░ čéą░ą║ąČąĄ čāą║ą░ąĘčŗą▓ą░čéčī čüčāčäčäąĖą║čüčŗ m ą┤ą╗čÅ ą╝ąĖąĮčāčé, h ą┤ą╗čÅ čćą░čüąŠą▓, d ą┤ą╗čÅ ą┤ąĮąĄą╣.

ą¦č鹊ą▒čŗ čüą║ą░čćą░čéčī č鹊ą╗čīą║ąŠ ąŠą┤ąĮčā ą┐ą░ą┐ą║čā, ą╝ąŠąČąĄčé ąŠą║ą░ąĘą░čéčīčüčÅ ą┐ąŠą╗ąĄąĘąĮąŠą╣ ąŠą┐čåąĖčÅ -np (no parent):

wget -mk -np http://example.com/subfolder/

ąĢčüą╗ąĖ čŹčéčā ąŠą┐čåąĖčÄ ąĮąĄ čāą║ą░ąĘą░čéčī, č鹊 wget ą▒čāą┤ąĄčé čéą░ą║ąČąĄ ą┐čĆąŠčüą╝ą░čéčĆąĖą▓ą░čéčī ąĖ ąĘą░ą║ą░čćąĖą▓ą░čéčī čĆąŠą┤ąĖč鹥ą╗čīčüą║čāčÄ ą┐ą░ą┐ą║čā (example.com ą┤ą╗čÅ ąĮą░čłąĄą│ąŠ ą┐čĆąĖą╝ąĄčĆą░).

ąĢčēąĄ ą┐čĆąĖą╝ąĄčĆ:

wget -rkpNl5 www.sysadmin.md

-r ŌĆö čüą║ą░čćąĖą▓ą░čéčī čüąŠą┤ąĄčƹȹĖą╝ąŠąĄ čĆąĄą║čāčĆčüąĖą▓ąĮąŠ

-k ŌĆö ą┐čĆąĄąŠą▒čĆą░ąĘąŠą▓ą░čéčī čüčüčŗą╗ą║ąĖ ą▓ čäą░ą╣ą╗ą░čģ, čćč鹊ą▒čŗ ąĖčģ ą╝ąŠąČąĮąŠ ą▒čŗą╗ąŠ ą┐čĆąŠčüą╝ą░čéčĆąĖą▓ą░čéčī ą╗ąŠą║ą░ą╗čīąĮąŠ

-p ŌĆö ąĘą░ą│čĆčāąČą░čéčī ą▓čüąĄ ą┐ąŠą┤čĆčÅą┤ - ą▓čüčéčĆąŠąĄąĮąĮčŗąĄ ąĖąĘąŠą▒čĆą░ąČąĄąĮąĖčÅ (inlined images), ąĘą▓čāą║ąĖ, čüą▓čÅąĘą░ąĮąĮčŗąĄ čéą░ą▒ą╗ąĖčåčŗ čüčéąĖą╗ąĄą╣ (referenced stylesheets)

-N ŌĆö ą▓ą║ą╗čÄč湥ąĮąĖąĄ ą╝ąĄč鹊ą║ ą▓čĆąĄą╝ąĄąĮąĖ (time-stamping)

-l5 ŌĆö ą╝ą░ą║čüąĖą╝ą░ą╗čīąĮčŗą╣ čāčĆąŠą▓ąĄąĮčī ą│ą╗čāą▒ąĖąĮčŗ čĆąĄą║čāčĆčüąĖąĖ (ą┐čĆąŠčüą╝ąŠčéčĆą░) čĆą░ą▓ąĄąĮ 5

ą¤ąŠą┤čĆąŠą▒ąĮąŠčüčéąĖ ą┐ąŠ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░ąĮąĖčÄ wget čüą╝. ą▓ čüą┐čĆą░ą▓ąĄ man wget.

[ąĪčüčŗą╗ą║ąĖ]

1. HTTrack Website Copier - Free Software Offline Browser (GNU GPL).

2. Wget for Windows. |

ąÜąŠą╝ą╝ąĄąĮčéą░čĆąĖąĖ

microsin: ą┐čĆąŠą▓ąĄčĆčīč鹥, ąĮąĄ ą╝ąĄčłą░ąĄčé ą╗ąĖ čĆą░ą▒ąŠč鹥 ą░ąĮčéąĖą▓ąĖčĆčāčü ąĖą╗ąĖ ą▒čĆą░ąĮą┤ą╝ą░čāąĄčĆ, ą┐čĆąŠą▓ąĄčĆčīč鹥, ą║ą░ą║ čĆą░ąĘčĆąĄčłą░čÄčéčüčÅ ą┤ąŠą╝ąĄąĮąĮčŗąĄ ąĖą╝ąĄąĮą░ ą▓ IP-ą░ą┤čĆąĄčü, ą┐ąŠą┐čĆąŠą▒čāą╣č鹥 ą▓ą╝ąĄčüč鹊 ą┤ąŠą╝ąĄąĮąĮąŠą│ąŠ ąĖą╝ąĄąĮąĖ čüą░ą╣čéą░ ąĖčüą┐ąŠą╗čīąĘąŠą▓ą░čéčī ąĄą│ąŠ IP.

RSS ą╗ąĄąĮčéą░ ą║ąŠą╝ą╝ąĄąĮčéą░čĆąĖąĄą▓ čŹč鹊ą╣ ąĘą░ą┐ąĖčüąĖ